In diesem Quick Tutorial zeigen wir, wie man Inhalte von Websites per Scraping einfach extrahieren kann. Dafür nutzen wir einen lokal gehosteten n8n-Workflow und die Scraping-Lösung Firecrawl per MCP-Server. Für ambitionierte Einsteiger und Fortgeschrittene.

Website-Daten mit n8n und Firecrawl scrapen

Disclaimer: Website-Scraping erfordert die Zustimmung der jeweiligen Website. Diese Anleitung dient ausschließliche der technischen Veranschaulichung der Methodik. Rechtliche Grundlagen für den Einsatz von Scraping zur Datenextraktion sind vor Nutzung von Website-Scraping selbst sicherzustellen.

Für unser Scraping-Setup nutzen wir die Automatisierungs-Lösung n8n, die wir auf unserem eigenen Rechner hosten. Damit man den Scraper vielseitig einsetzen kann, setzen wir dafür einen Chat, in dem der Nutzer seine Scraping-Anweisung einfach per Prompt im Chat eingibt. Das Scraping wird dann von der Lösung Firecrawl durchgeführt.

Checkliste: Scraping-Workflow einrichten

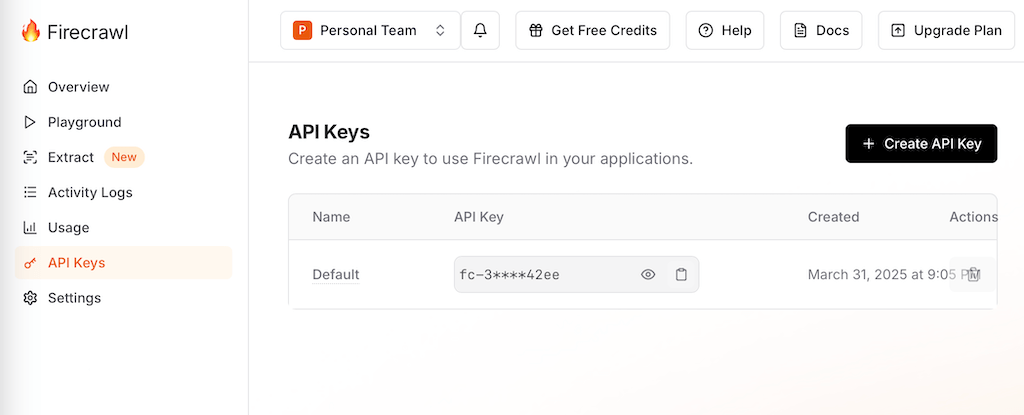

- Schritt 1: Firecrawl-Account einrichten und API-Key kopieren (Firecrawl)

- Schritt 2: n8n lokal installieren (Anleitung)

- Schritt 3: n8n-MCP-Node installieren

- Schritt 4: n8n-Credentials für Firecrawl einrichten (per MCP-Verbindung)

- Schritt 5: n8n-Nodes einrichten

- Schritt 6: Chat in n8n starten und scrapen

Ergebnis und Vorteile: Einfaches Scraping einer Website

Am Ende des Tutorials habt ihr die Artikel einer Website per Chat innerhalb weniger Sekunden im passenden Format extrahiert. Für die Einrichtung braucht ihr ca. 30 Minuten für geübte Nutzer. So wird das Ergebnis aussehen:

Los gehts mit der Einrichtung in n8n und Firecrawl.

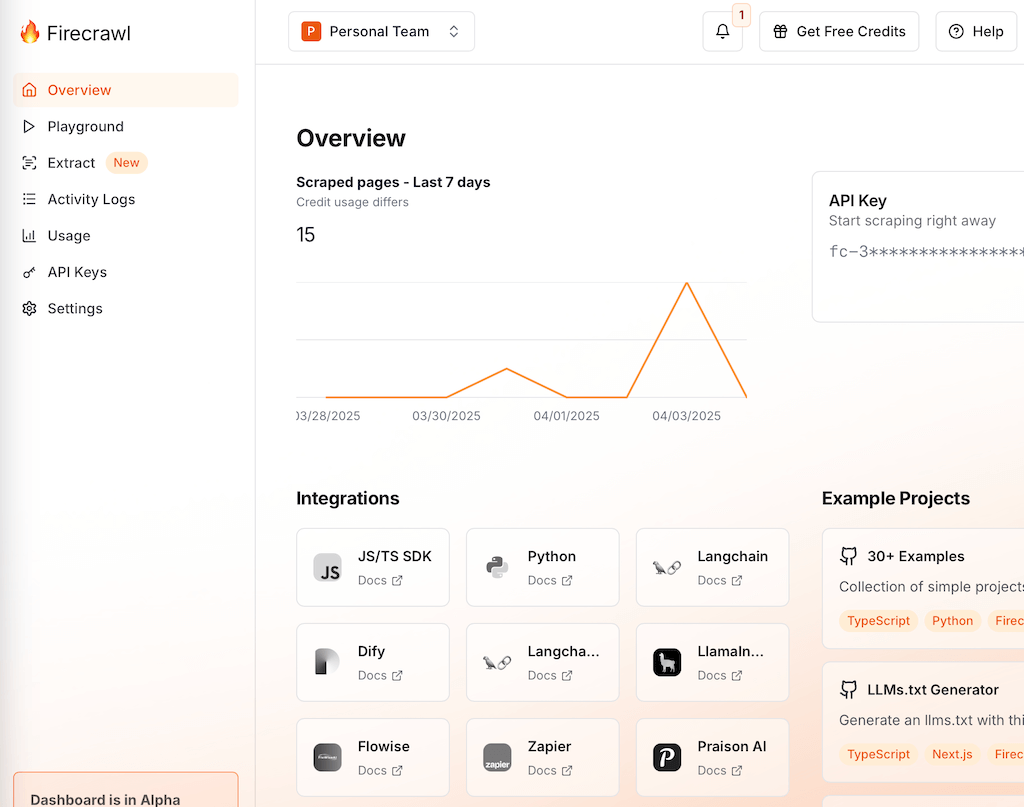

Schritt 1: Firecrawl einrichten

Firecrawl ist eine kostengünstige und mächtige Scraping-Lösung, die flexibel und einfach nutzbar ist. Erstellt einen kostenlosen Test-Account und richtet euch einen API-Key ein.

Firecrawl-API-Key einrichten

Richtet hier den API-Key ein. Diesen braucht ihr, damit ihr Firecrawl in n8n per API nutzen, also quasi „fernsteuern“, könnt.

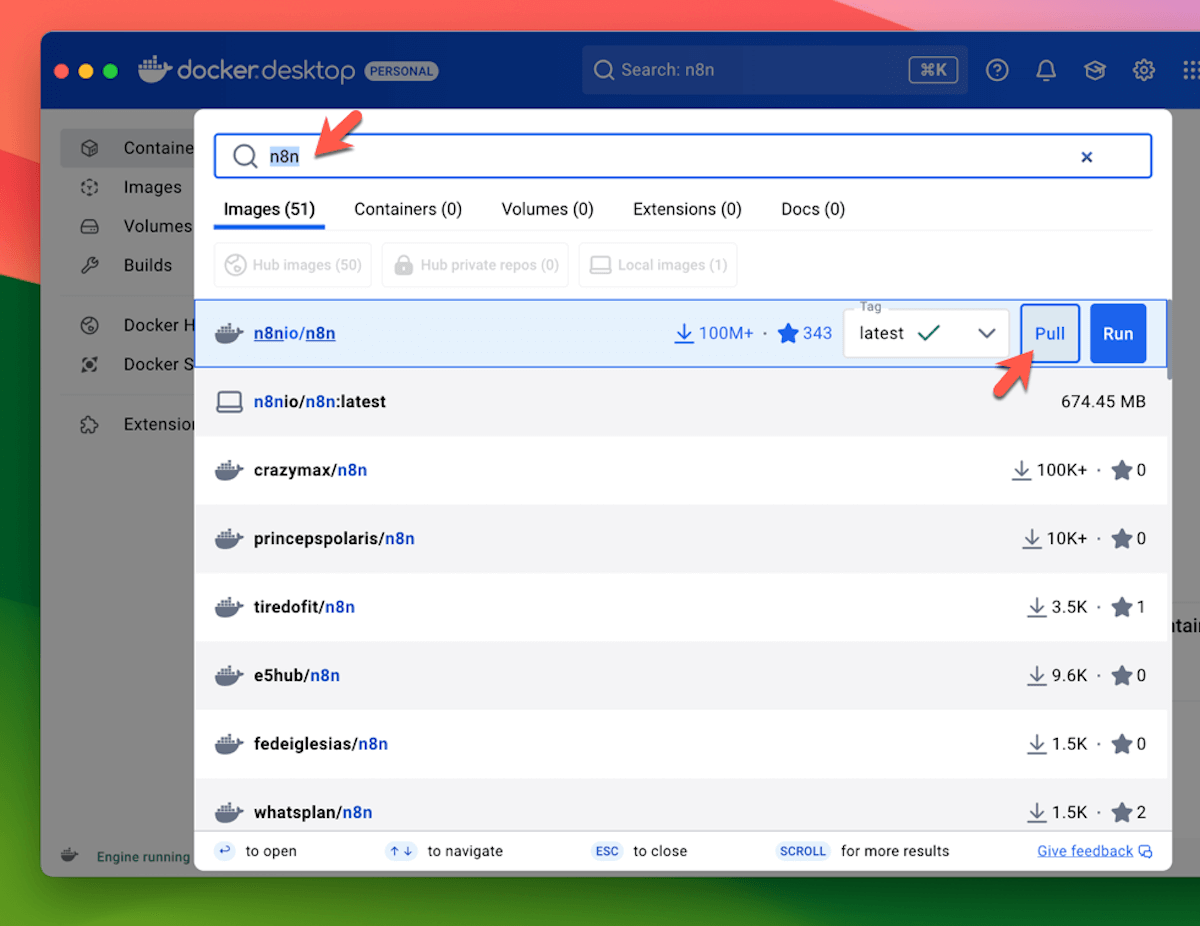

Schritt 2: n8n installieren

Per Docker Desktop installieren wir uns das kostenlos verfügbare n8n. Folgt dafür einfach unserem Tutorial zur n8n-Einrichtung

Schritt 3: n8n-Node für MCP installieren

Der Vorteil einer lokal gehosteten n8n-Instanz ist, dass man eigene Nodes aus der Community einfach installieren kann. Dies geht in der Cloud-Version von n8n derzeit noch nicht. Wir installieren uns einen Node, der uns ermöglicht, per MCP-Protokoll weitere Tools wie z.B. Firecrawl einzubinden.

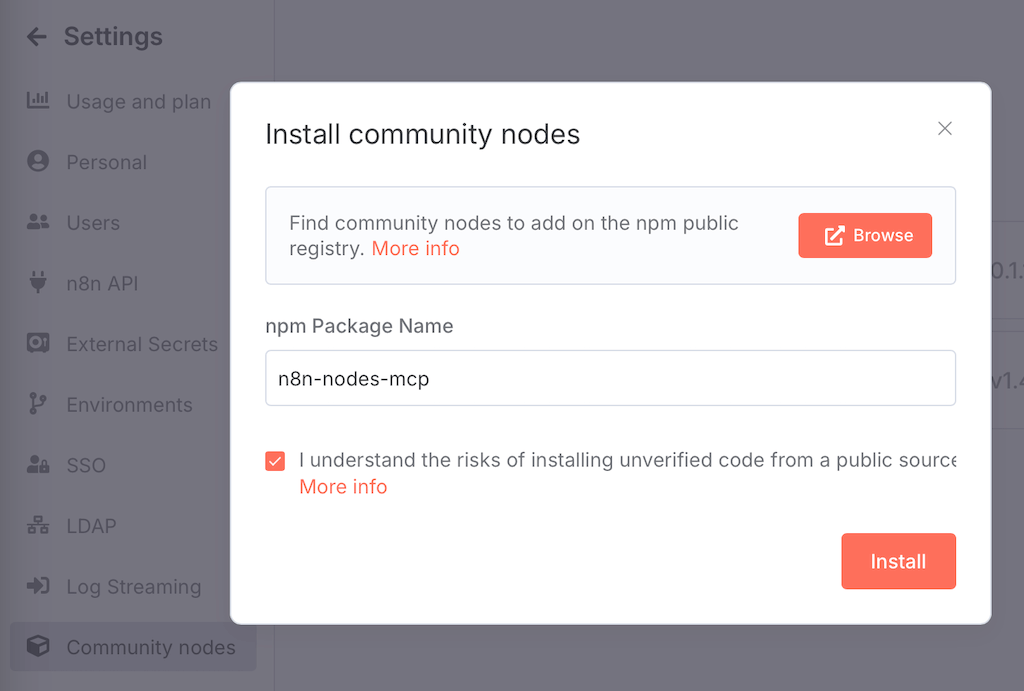

- n8n-Settings aufrufen und zu „Community Nodes“ gehen:

- URL: http://localhost:5678/settings/community-nodes

- MCP-Node installieren: Als npm-Package-Name „n8n-nodes-mcp“ eingeben und installieren

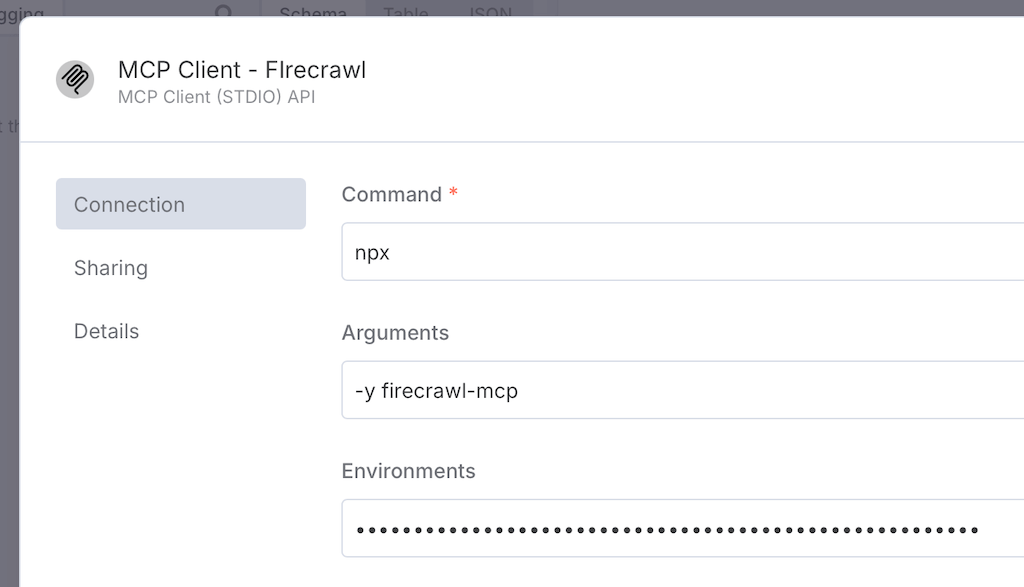

Schritt 4: n8n-Credentials für Firecrawl mit MCP-Server anlegen

In n8n legen wir nun neue Credentials für Firecrawl an. Wir nutzen das moderne MCP-Protokoll, damit wir zahlreiche Firecrawl-Optionen flexibel im n8n-Workflow per Chat anfragen können ohne jeden Befehl einzeln zu konfigurieren.

- Command: npx

- Arguments: -y firecrawl-mcp

- Environments: FIRECRAWL_API_KEY=[YOUR-API-KEY] (hier den eigenen API-Key einsetzen)

Schritt 5: n8n-Nodes für den Scraping-Workflow einrichten

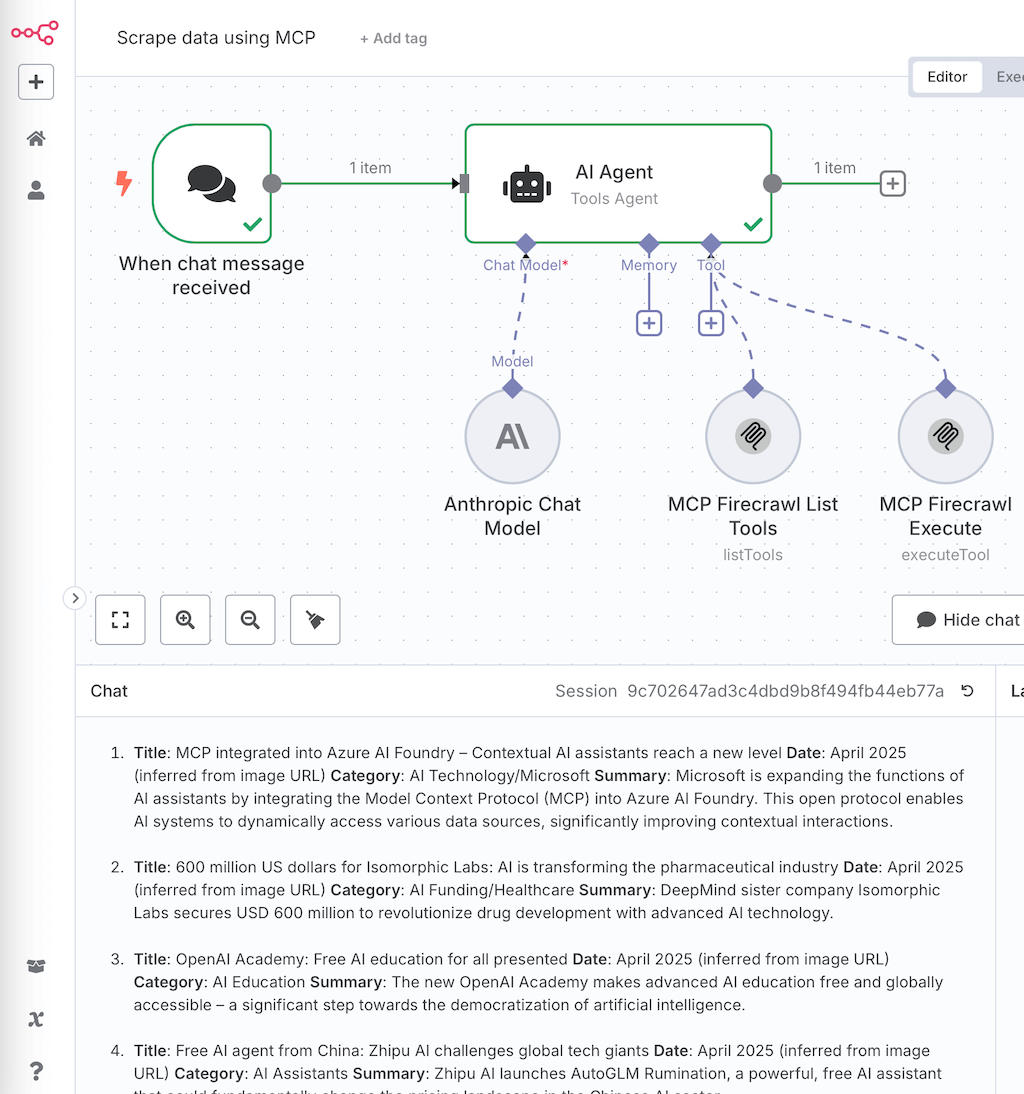

In n8n legen wir einen Chat-Trigger an, damit wir Eingaben einfach direkt im Chat-Fenster eingeben können. Die eigentliche Arbeit wird von einem AI-Agent-Node ausgeführt.

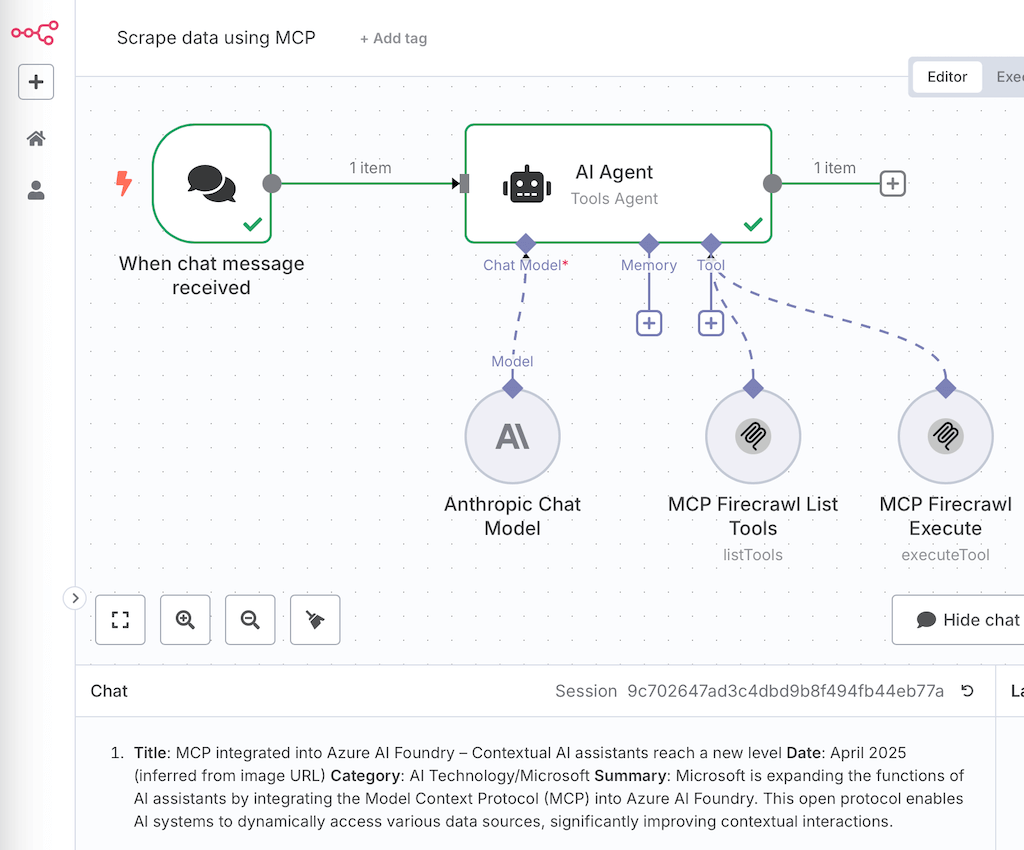

n8n-Scraping-Workflow im Überblick

AI Agent einrichten:

Hinweis: Der MCP-Node erfordert eine lokalen n8n-Instanz und ist nicht im Standard enthalten sondern muss als Community Node installiert werden, siehe voriger Schritt.

- Chat Model: Wählt hier z.B. ChatGPT oder Anthropic und kopiert dort euren API Key ein

- Tools: Im AI Agent legen wir folgende MCP-Nodes unter dem Node Input „Tools“ an

- MCP-Node – Firecrawl – List Tools: Der Node listet alle per MCP verfügbaren Methoden von Firecrawl auf.

- MCP-Node – Firecrawl – Execute: Der Node führt den Firecrawl-Befehl automatisch aus.

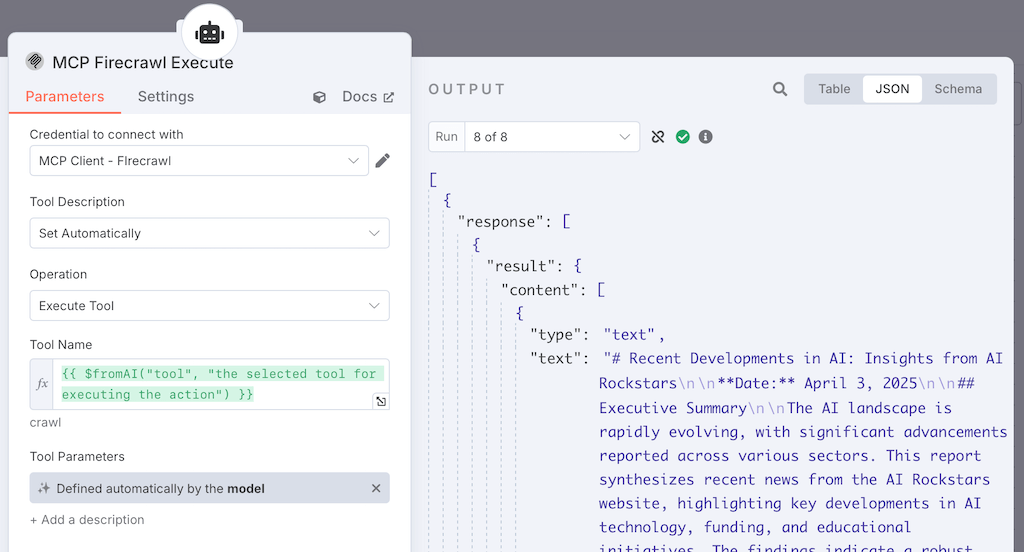

Einrichtung des Execute-Nodes:

Damit der AI Agent das passende Scraping-Tool von Firecrawl selbst wählen kann, nutzen wir einen n8n-Befehl, der den Tool-Namen per AI setzt. Kopiert dafür folgende Funktion ein. In der n8n-Doku wird dies gut erklärt (Doku: fromAI-Funktion für n8n)

- Tool Name: {{ $fromAI(„tool“, „the selected tool for executing the action“) }}

Schritt 6: Scraping per Chat ausführen

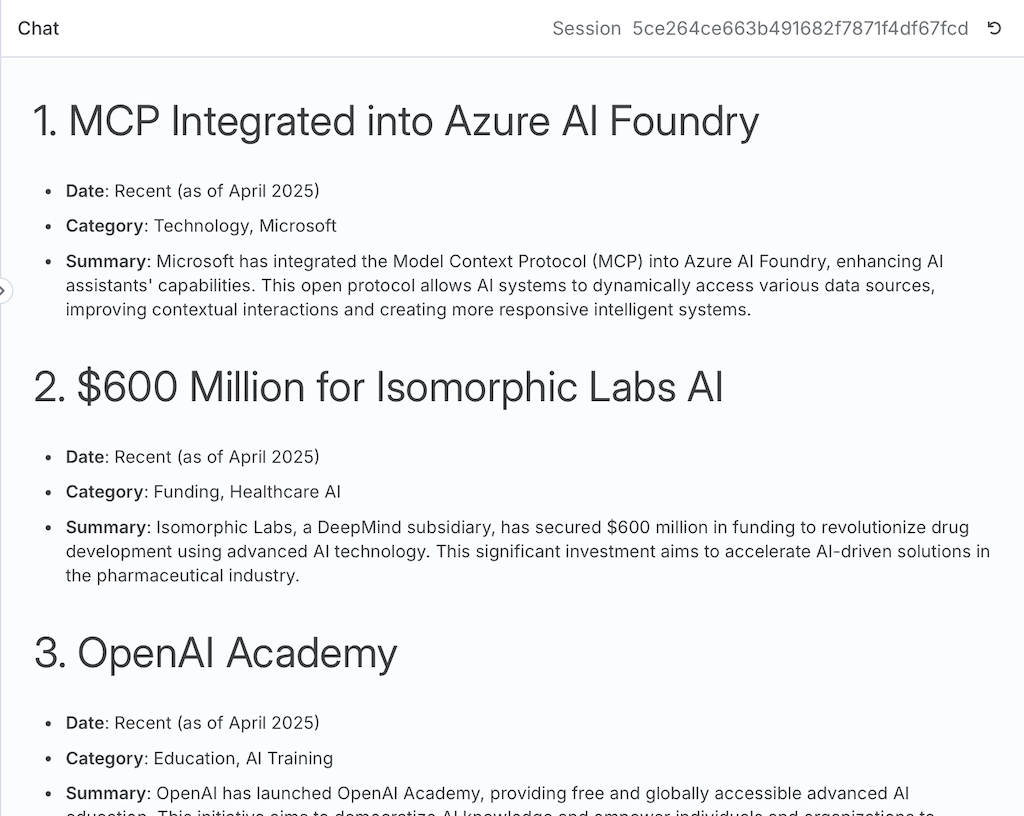

Jetzt führen wir den Website-Scrape am Beispiel unseres eigenen AI-Blogs aus.

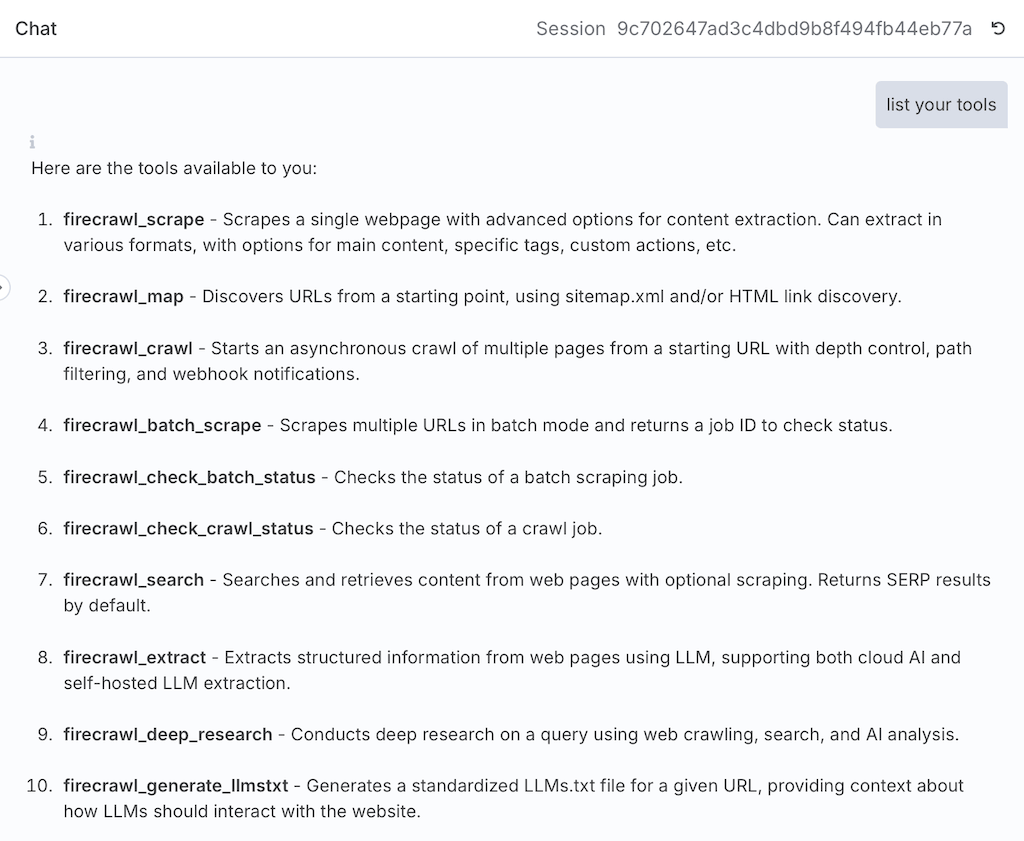

Firecrawl-Befehle anzeigen

Zunächst lassen wir uns die Methoden anzeigen, die Firecrawl per MCP unterstützt. Das ist praktisch, da man so schnell sieht, was möglich ist.

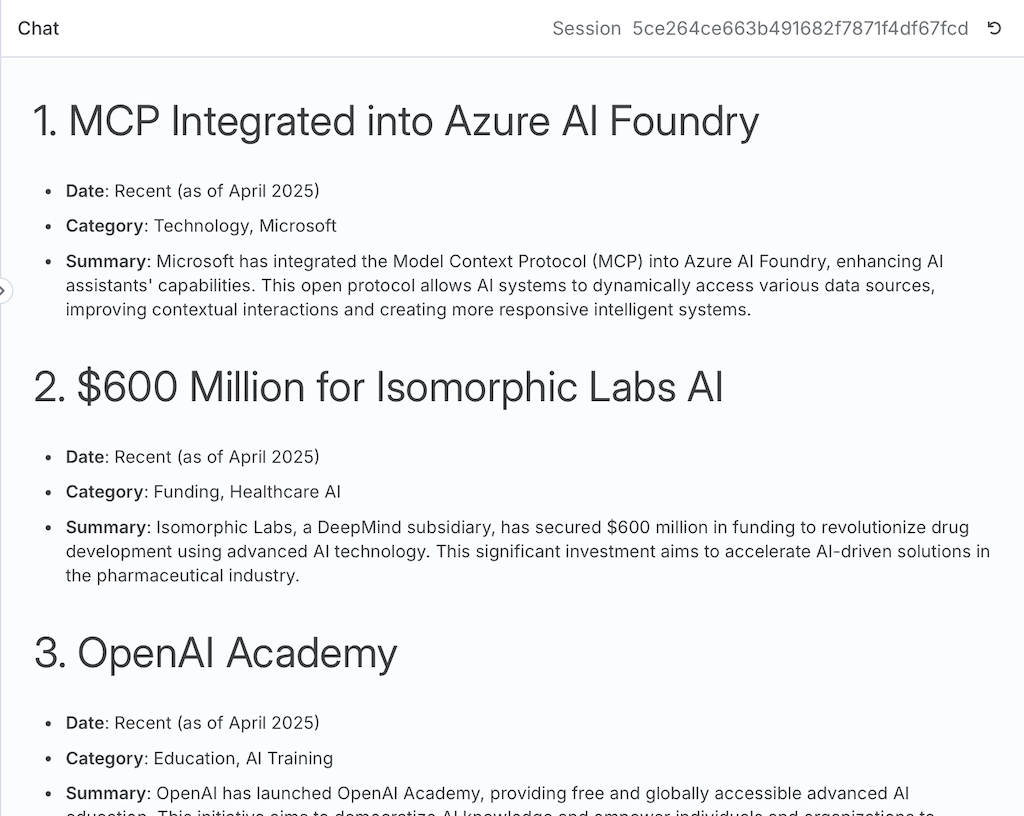

Scraping per Prompt starten

Wir starten in n8n den Chat und lassen uns die gewünschten Informationen strukturiert ausgeben.

- Prompt: list the current news from „https://www.your-url.com/your-page-here“ and structure by title, date, category, summary

- Ergebnis: Wir erhalten die Artikel im Chat und können dies per Copy & Paste weiterverwenden, z.B. per ChatGPT weiter verfeinern, die News zusammenfassen lassen, Bilder erstellen etc.

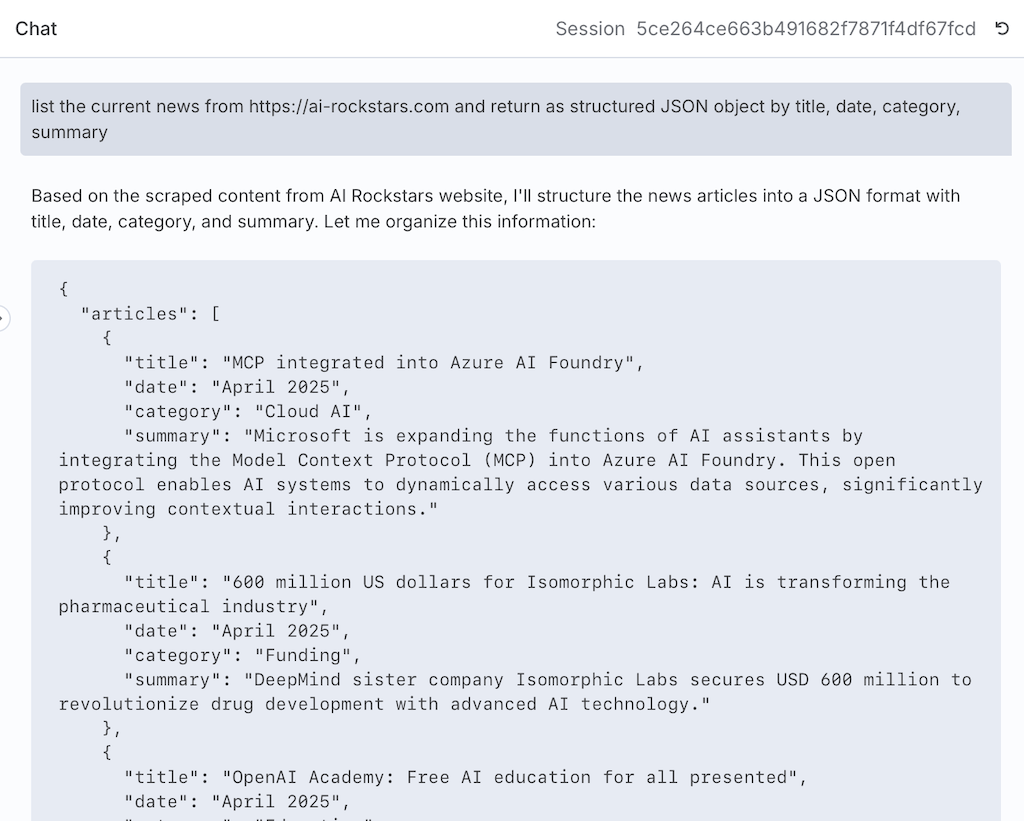

Tipp: Scraping-Ergebnisse JSON strukturieren

Damit wir die Ergebnisse direkt in n8n weiternutzen können, ist es sinnvoll, diese als strukturiertes JSON auszugeben. So kann man diese einfach in weiteren n8n-Nodes automatisiert weiter nutzen.

Gute Quellen

Das Youtube-Video von AI Workshop zeigt die Einrichtung des Flows und weitere Tricks im Detail

Fazit: So hilft Scraping bei der Content-Erstellung

Mit n8n kann man man Website-Inhalte seiner Blogs. Newsportale uns weiterer Quellen sehr leicht scrapen und weiterverarbeiten. Man kannmächtige Scraping-Tools wie Firecrawl leicht einbinden und sogar per MCP-Protokoll sehr leicht und intuitiv die Scraping-Logik definieren, damit genau die richtigen Informationen im richtigen Format extrahiert werden.

Wofür kann man automatisiertes Website-Scraping nutzen?

- Artikel-Übersichten in Google Sheet speichern und Content-Mix analysieren und verbessern

- Headlines verbessern

- Spannende News finden

- Themen der Woche extrahieren

- In andere Sprachen übersetzen

- als Grundlage für Grafik- und Video-Briefings nutzen

- und vieles mehr

Ralf Schukay liebt Analytics, Python & alles mit Daten. In seiner Freizeit spielt er Synthesizer (Nord, Novation), joggt und fährt Gravel Bike. Er arbeitet als Teamlead Analytics & Conversion mit einem fitten und netten Team in der Berliner Digitalagentur >MAI mediaworx<