Sakana AI hat mit der Vorstellung des AI CUDA Engineer ein neues Kapitel in der Welt der künstlichen Intelligenz und Hochleistungsberechnungen aufgeschlagen. Diese innovative Lösung ermöglicht die automatische Erstellung hochoptimierter CUDA-Kernels für maschinelle Lernvorgänge – ein Schritt, der nicht nur die Effizienz von Modellen drastisch steigert, sondern auch die Zukunft nachhaltiger KI-Systeme gestaltet.

Ein Paradigmenwechsel in der KI-Entwicklung

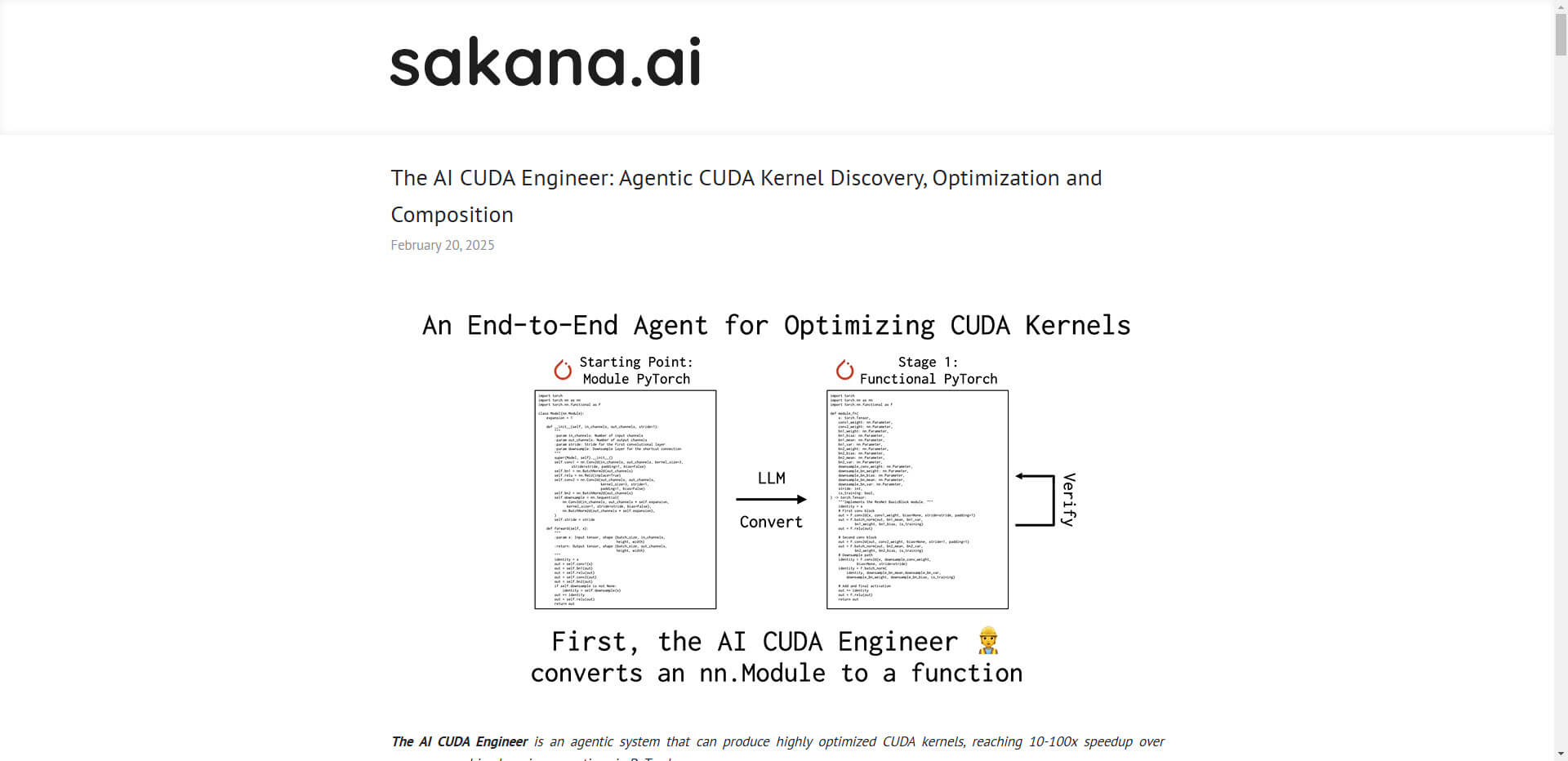

Der AI CUDA Engineer revolutioniert den traditionellen Entwicklungsprozess von CUDA-Kernels, indem er PyTorch-Code mit einer Erfolgsquote von über 90 % automatisch in optimierte CUDA-Kernels übersetzt. Diese Automatisierung führt zu enormen Geschwindigkeitssteigerungen. Instance Normalization wurde in Tests bis zu 381-mal schneller, während für Matrixmultiplikationen eine Beschleunigung um das 147-Fache erreicht wurde. Insgesamt erzielte der Engineer über 250 Aufgaben betrachtet eine mediane Steigerung der Ausführungszeit um das 1,34-Fache im Vergleich zu nativen PyTorch-Lösungen.

Ein solch evolutionärer Fortschritt wird durch eine optimierte Methodik gestützt: evolutionäre Algorithmen, wie „crossover“-Operationen und ein „Innovation Archive“, treiben die Leistung kontinuierlich nach oben. Dieser Ansatz erlaubt nicht nur Übersetzungen vom PyTorch-Framework, sondern verbessert gleichzeitig die Effizienz des Codes, was vor allem für die zunehmende Datenflut und steigenden Rechenaufwand von GPU-basierter KI-Optimierung entscheidend ist.

Implikationen für die Branche und aktuelle Trends

Die Freigabe des AI CUDA Engineer Archive, eines Datensatzes mit über 30.000 CUDA-Kernels, darunter mehr als 17.000 verifizierte Implementierungen, stellt eine wertvolle Ressource für die Forschung und Entwicklung innerhalb der KI-Branche dar. Unter der CC-By-4.0-Lizenz wird dieser Datensatz über HuggingFace verfügbar gemacht – ein positives Signal für Kollaboration und Weiterentwicklung in der Community.

Solche Entwicklungen spiegeln den wachsenden Trend wider, KI für die Optimierung von KI-Systemen einzusetzen. Dieser „Meta-Learning“-Ansatz hat das Potenzial, komplexe Modelle effizienter zu gestalten, die Kosten von Trainingsprozessen zu senken und Ressourcen nachhaltiger einzusetzen. Gleichzeitig müssen Überlegungen angestellt werden, wie diese Technologien künftig in wissenschaftlichen und industriellen Umgebungen integriert und evaluiert werden können.

Chancen und Herausforderungen von AI-Optimierungssystemen

Obwohl Tools wie der AI CUDA Engineer bemerkenswerte Fortschritte aufzeigen, erinnern parallele Entwicklungen – wie beim KI-Wissenschaftler von Sakana AI – an bestehende Herausforderungen. Trotz Automatisierung und Effizienzsteigerung bleiben Fragen zur Qualität von Forschungsergebnissen und zur Autonomie von KI-Systemen offen. Die wissenschaftliche Gemeinschaft steht vor der Aufgabe, Benchmarks für KI-basierte Forschungstools zu definieren, um deren Verlässlichkeit und Nutzen langfristig zu gewährleisten.

Für Unternehmen und Entwickler bedeutet diese Welle von KI-Innovationen neue Möglichkeiten, operative Effizienz zu steigern. Gleichzeitig signalisiert sie die Notwendigkeit strategischer Investitionen in Weiterbildung und Technologien, um wettbewerbsfähig zu bleiben.

Die wichtigsten Fakten zum Update

- Automatisierungspotenzial: Über 90 % der PyTorch-Operationen können automatisch ins CUDA-Format übersetzt werden.

- Enorme Geschwindigkeitssteigerungen: Speedups zwischen 10- bis 100-Fach für maschinelles Lernen; bis zu 381-Fache Beschleunigungen bei spezifischen Operationen.

- Einsparung von Ressourcen: Optimierungssysteme wie der AI CUDA Engineer machen Rechenprozesse nachhaltiger und schneller.

- Offene Forschung: Veröffentlichung des AI CUDA Engineer Archive als quelloffener Datensatz auf HuggingFace.

- Meta-Learning-Trend: Der Einsatz von KI-Systemen für die Optimierung anderer KI bringt die Branche dem Ziel nachhaltig effizienter Systeme näher.

Quelle: Sakana.ai

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.