Der Durchbruch für Open-Source KI ist da: OLMo 2 32B setzt neue Maßstäbe in Leistung und Effizienz.

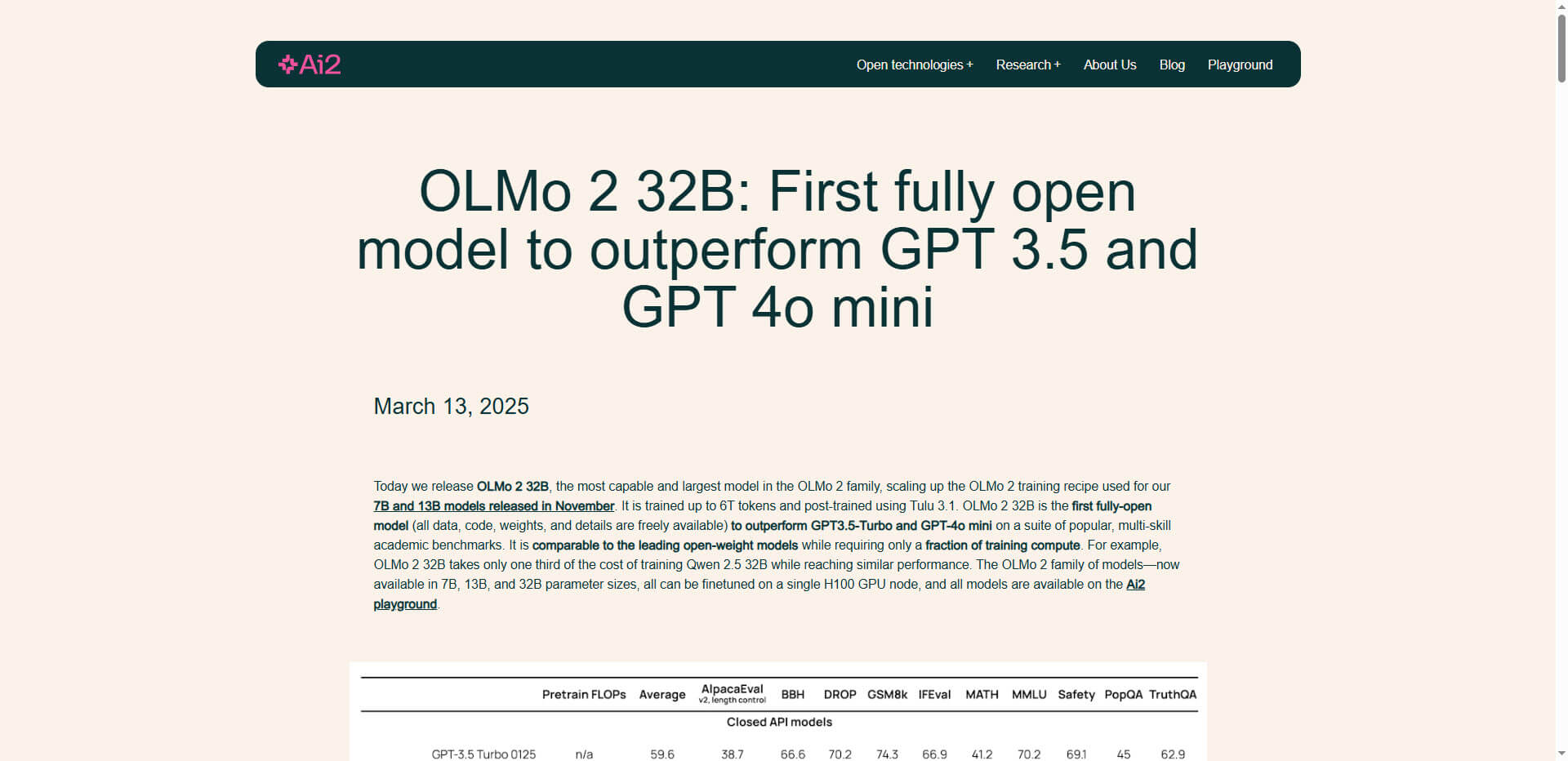

Das Allen Institute for AI (AI2) hat mit OLMo 2 32B ein neues Large Language Model vorgestellt, das einen bedeutenden Fortschritt in der Welt der offenen KI-Modelle markiert. Als erstes vollständig offenes Modell übertrifft es GPT-3.5-Turbo und GPT-4o mini bei einer Reihe akademischer Benchmark-Tests. Dabei benötigt es nur einen Bruchteil der Rechenleistung vergleichbarer Modelle – ein klares Zeichen dafür, dass Open-Source-KI in eine neue Phase eintritt.

Die Bedeutung dieser Entwicklung kann kaum überschätzt werden: Mit OLMo 2 32B verringert sich der Abstand zwischen offenen und geschlossenen KI-Systemen auf etwa 18 Monate. Die vollständige Transparenz des Projekts, bei dem sämtliche Daten, Code, Gewichtungen und Trainingsdetails frei verfügbar sind, fördert zudem die wissenschaftliche Zusammenarbeit und Innovationskraft in der gesamten Branche.

Technische Überlegenheit durch innovative Trainingsmethoden

Mit seinen 32 Milliarden Parametern wurde OLMo 2 32B auf bis zu 6 Billionen Tokens trainiert. Der Trainingsprozess umfasste ein Vortraining auf OLMo-Mix-1124 (3,9 Billionen Tokens) und ein Mid-Training auf Dolmino-Mix-1124. Diese spezifische Trainingsmethodik hat es dem Modell ermöglicht, mit nur einem Drittel der Trainingskosten von Qwen 2.5 32B vergleichbare Leistungen zu erzielen.

Besonders beeindruckend ist die Trainingsinfrastruktur: Das Modell wurde auf Augusta trainiert, einem 160-Knoten AI Hypercomputer von Google Cloud Engine, der Verarbeitungsgeschwindigkeiten von über 1.800 Tokens pro Sekunde pro GPU erreichte. Diese technische Effizienz macht OLMo 2 32B nicht nur zu einem leistungsstarken, sondern auch zu einem wirtschaftlich attraktiven Modell für Forscher und Entwickler.

Demokratisierung fortschrittlicher KI-Technologie

OLMo 2 32B steht für einen Paradigmenwechsel in der KI-Forschung. Das Modell ist in der Hugging Face Transformers-Bibliothek und im Hauptzweig von vLLM integriert, was eine breite Verfügbarkeit sicherstellt. Es übertrifft oder entspricht den Fähigkeiten von Modellen wie GPT-3.5 Turbo, GPT4-o mini, Qwen 2.5 32B und Mistral 24B, während es sich der Leistung größerer Modelle wie Qwen 2.5 72B und Llama 3.1 und 3.3 70B annähert.

Die Zukunftspläne des Teams umfassen die Verbesserung des logischen Denkvermögens des Modells und die Erweiterung seiner Fähigkeit, längere Texte zu verarbeiten. Dies deutet darauf hin, dass OLMo 2 32B erst der Anfang einer neuen Generation offener KI-Modelle ist, die die Landschaft der künstlichen Intelligenz grundlegend verändern könnten.

Zusammenfassung

- OLMo 2 32B ist das erste vollständig offene Modell, das GPT-3.5-Turbo und GPT-4o mini in akademischen Benchmark-Tests übertrifft

- Das Modell erreicht seine Leistung mit nur einem Drittel der Trainingskosten vergleichbarer Modelle

- Mit 32 Milliarden Parametern wurde es auf bis zu 6 Billionen Tokens trainiert

- Die vollständige Transparenz (Daten, Code, Gewichtungen, Trainingsdetails) fördert die Zusammenarbeit in der KI-Forschung

- Der Abstand zwischen offenen und geschlossenen KI-Systemen wird auf etwa 18 Monate reduziert

- OLMo 2 32B ist in Hugging Face Transformers und vLLM integriert

- Zukünftige Entwicklungen werden auf logisches Denken und die Verarbeitung längerer Texte abzielen

Quelle: Ai2

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.