Das KI-Hardware-Startup Groq hat spezielle Chips erstellt, die gängige Sprachmodelle extrem stark beschleunigen. Dies kann jetzt für alle mit den beliebten Modellen Mixtral, Mistral und Llama 2 auf der Groq-Website getestet werden.

Groq im Test: 10-20fach schnellere GenAI-Modelle

Im Test haben wir das Mixtral-Modell „8x7B 32K“ beauftragt, ein Marketing-Konzept zu erstellen. Als Ergebnis hat das Modell 500 Wörter (3.700 Zeichen) generiert, wobei Mixtral das Ergebnis beinahe ohne Wartezeit zurückgeliefert hat. Nach nur 4 Sekunden war das Konzept vollständig generiert. Die Ergebnisse werden dabei live zurückgegeben.

Groq kann man hier ohne Registrierung direkt live erleben (Tipp: machen!)

Ergebnis: Das durch Mixtral generierte Marketing-Konzept

Performance von Groq mit dem Mixtral-Modell: 1,7 Sekunden für 500 Wörter

Insgesamt benötigte Groq zwar 4 Sekunden, jedoch fließen hier auch Wartezeiten durch parallele Nutzung durch andere Nutzer und Latenzzeiten im Internet ein. Tatsächlich brauchte das Modell nur 1,7 Sekunden, um die 500 Wörter zu generieren (siehe Inference Time getrennt nach Dauer der Verarbeitung des Input-Prompts und des Text-Outputs). Das entspricht einem Durchsatz von unglaublichen 840 Token pro Sekunde (ca. 20x schneller als bei ChatGPT)

Die Vorteile beschleunigter GenAI-Modelle

Die Vorteile liegen auf der Hand: Ein schnelles LLM ermöglicht ein deutlich beschleunigteres Texte erstellen, Übersetzungen anfertigen, Code generieren lassen oder einfach nur recherchieren. Wir schätzen, dass man damit die Produktivität bei typischen Aufgaben um den Faktor 2-3 steigern kann. Deutlich stärker kommen die Vorteile beim codebasierten Einsatz von LLMs via API zutage, denn hier kann der volle Durchsatz von 500 Tokens pro Sekunde ausgereizt werden.

Welche Sprachmodelle unterstützt Groq?

Auf der Groq-Website kann man derzeit folgende Opensource-AI-Modelle kostenlos und ohne Registrierung direkt testen:

- Mixtral 8x7B 32K (gilt als „fast so gut“ wie GPT-4)

- Mistral 7B 8K (in etwa vergleichbar mit GPT-3.5-Turbo)

- Llama 2 70B 4K (Metas OpenSource-Modell)

Damit werden von Groq einige der aktuell vielversprechendsten OpenSource-LLMs noch besser gemacht. Diese übertreffen damit die Geschwindigkeit von GPT-4 („das aktuell führende Sprachmodell“) um Längen.

Groq ist jedoch nicht auf diese Modelle festgelegt, sondern kann prinzipiell alle Modelle und auch Games beschleunigen, da die optimierten Chips durch ihre Bauweise einen hohen Durchsatz und geringe Latenz haben.

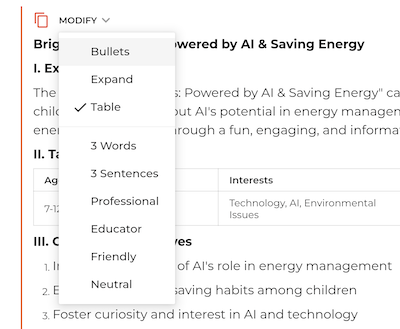

Weiteres Feature auf der Groq-Website: Ergebnis als Tabelle ausgeben

Wer kostenlos die mächtigen und beschleunigten Text-KIs nutzen will, kann sogar noch ein praktisches weiteres Feature auf der Groq-Website entdecken: Man kann die Output-Tonalität schnell anpassen, in 3 Sätzen zusammenfassen lassen oder besonders praktisch: als Tabelle umformattieren.

Beispiel: Ausgabe des generierten Contents als Tabellen

Fazit und Ausblick: KI wird 2024 extrem schnell

Groq macht die Arbeit mit KI noch besser, denn wer kennt es nicht: Oft gibt die KI nicht das gewünschte zurück. Mit Groq-Beschleunigung ist dies nicht weiter störend, denn in wenigen Sekunden hat man den generierten Text korrigiert und verfeinert.

Auch OpenAI ist parallel dabei, auch sein beliebtes Sprachmodell durch eigenproduzierte Chips zu beschleunigen. Und NVIDIA arbeitet ebenfalls kontinuierlich an Leistungssteigerungen seiner führenden KI-Chips. Zu erwarten ist, dass das beliebte ChatGPT und auch Microsofts Copilot noch 2024 ebenso schnell werden.

Das KI-Rennen hat durch Technologien wie Groq nun wortwörtlich noch einmal mehr an Fahrt aufgenommen, was die Adaption und Nutzung von KI im Alltag deutlich vorantreiben wird.

Mehr erfahren:

Ralf Schukay liebt Analytics, Python & alles mit Daten. In seiner Freizeit spielt er Synthesizer (Nord, Novation), joggt und fährt Gravel Bike. Er arbeitet als Teamlead Analytics & Conversion mit einem fitten und netten Team in der Berliner Digitalagentur >MAI mediaworx<