Crawlee vereint High-Speed-HTTP-Scraping und moderne Browser-Automatisierung in einer einzigen, skalierbaren Node.js-Bibliothek, um komplexe Web-Daten effizienter zu extrahieren. Durch intelligente Fallback-Mechanismen, die Browser nur bei Bedarf zuschalten, lassen sich im Vergleich zu reinen Playwright-Setups bis zu 90 Prozent der Systemressourcen einsparen. Wir werfen einen Blick auf die Architektur, die Performance-Benchmarks und die realen Herausforderungen im Dauerbetrieb.

Crawlee Web Scraping: Die wichtigsten Infos

- Crawlee vereint als Open-Source-Framework schnelle HTTP-Requests und komplexe Headless-Browser-Automatisierung unter einer einzigen „Unified API“, um den Wartungsaufwand bei Scraping-Projekten massiv zu senken.

- Die Architektur erlaubt es Entwicklern, nahtlos zwischen ressourcenschonenden Text-Parsern und vollständiger Browser-Simulation zu wechseln, ohne den Code neu schreiben zu müssen, sobald eine Webseite JavaScript-Hürden einführt.

- Durch intelligente Automatisierungen wie den

AutoscaledPoolverwaltet das Tool CPU- und RAM-Lasten selbstständig, um Abstürze bei hoher Skalierung proaktiv zu vermeiden. - Finanziell ergibt sich ein enormes Einsparpotenzial bei den Infrastrukturkosten, da reine HTTP-Crawler bis zu 50-mal schneller sind und 90% weniger Speicher verbrauchen als browserbasierte Lösungen.

- Zudem eliminiert die integrierte Anti-Blocking-Logik mit automatischem Fingerprint-Management teure Ausfallzeiten und reduziert den Bedarf an manueller Pflege von Stealth-Plugins drastisch.

- Implementiere Crawlee primär in TypeScript-Umgebungen und nutze das „Hybrid-Pattern“, bei dem Requests standardmäßig „billig“ via HTTP laufen und nur bei Blockaden automatisch an „teure“ Browser eskaliert werden.

- Setze für reine Python-Data-Science-Workflows weiterhin auf Scrapy, da Crawlee hier architektonischen Overhead erzeugt und die Integration in Pandas-Pipelines weniger reif ist.

- Starte neue Projekte direkt dockerisiert, um bekannte Speicherlecks bei tagelangen Jobs durch einfache, geplante Container-Restarts pragmatisch zu umgehen.

Zusammenfassung

- Massive Performance-Unterschiede: Der HTTP-basierte

CheerioCrawlerarbeitet 10- bis 50-mal schneller als Browser-Lösungen und erreicht auf einem Single-Core einen Durchsatz von > 500 Seiten/Minute, während Playwright oft nur 10-50 Seiten schafft. - Ressourcen-Effizienz: Durch ein Hybrid-Pattern lassen sich 90-95% der Requests auf E-Commerce-Seiten statisch lösen, was den RAM-Verbrauch um 90% senkt, da speicherhungrige Headless Browser (1GB+ pro Instanz) nur als Fallback genutzt werden.

- Kein Vendor-Lock-in: Dank Apache 2.0 Lizenz ist das Framework vollständig via Docker kostenlos self-hosted nutzbar; Kosten entstehen nur bei optionaler Nutzung der Managed Cloud (ab $39/Monat).

- Existierende Stabilitätsrisiken: Bei Langzeit-Jobs (Long-Running) führen ungelöste Memory Leaks und „Detached Contexts“ häufig zu OOM-Crashes, die in der Praxis oft nur durch präventive Container-Neustarts umgangen werden können.

Der größte Pain Point beim Skalieren von Scraping-Projekten ist oft der unvermeidliche Technologiewechsel: Man startet mit leichtgewichtigen HTTP-Requests, läuft gegen eine JavaScript-Wand und muss den gesamten Code für einen Headless Browser neu schreiben. Crawlee eliminiert dieses Problem durch eine strikte Unified API Architektur.

Die 3-in-1 Logik: Konsistenz durch Vererbung

Seit dem Release von Version 3.0.0 (August 2022) basieren alle Hauptklassen – CheerioCrawler, PlaywrightCrawler und PuppeteerCrawler – auf derselben BasicCrawler-Klasse. Das bedeutet: Die Methoden zur Steuerung der Queue (enqueueLinks) und zur Datenspeicherung (pushData) sind identisch, unabhängig von der zugrunde liegenden Engine.

Das requestHandler-Objekt bietet ein Unified Interface. Entwickler können die Logik für das Extrahieren von Daten schreiben, ohne sich darum kümmern zu müssen, ob gerade rohes HTML geparst oder eine vollständige DOM-Simulation durchlaufen wird. Ein Wechsel von reinem HTTP zu einem browserbasierten Ansatz erfordert oft nur das Ändern des Klassennamens im Konstruktor.

Benchmarks: Performance-Gap und Ressourcen

Die Wahl der richtigen Klasse hat massive Auswirkungen auf die Infrastrukturkosten. Während Browser-Automatisierung für moderne Single Page Applications (SPAs) oft notwendig ist, zeigen Benchmarks, warum sie nur als Fallback dienen sollte:

| Metrik | CheerioCrawler (HTTP-only) | Playwright/Puppeteer (Browser) |

|---|---|---|

| Geschwindigkeit | 10-50x schneller | Limitiert durch Rendering-Zeit |

| Throughput | > 500 Seiten/Minute (1 Core) | 10-50 Seiten/Minute (je nach JS-Last) |

| RAM-Verbrauch | Minimal (reines Text-Parsing) | 1GB+ pro Instanz (Concurrency-Level) |

| Overhead | Gering | Hoch (Startzeit, Context-Creation) |

Der CheerioCrawler verbraucht im Schnitt 90% weniger Speicher als seine browserbasierten Pendants. Auf einer Standard-Maschine (1 CPU Core, 4GB RAM) lässt sich so ein massiver Durchsatz erzielen, während Browser-Instanzen schnell ins CPU-Throttling oder OOM (Out of Memory) laufen.

Open Source als strategischer „Loss Leader“

Technisch gesehen fungiert das Framework als „Einstiegsdroge“ für die Apify Plattform. Dennoch ist der Code unter der permissiven Apache 2.0 Lizenz veröffentlicht. Das bedeutet:

- Kein Vendor-Lock-in: Das Tool ist voll funktionsfähig ohne Cloud-Anbindung.

- Docker-Ready: Entwickler können Crawlee kostenlos in eigenen Containern auf AWS, Google Cloud oder lokaler Hardware deployen.

- Monetarisierung: Apify monetarisiert nicht den Code, sondern die Managed Cloud Infrastructure (ab $39/Monat), die Skalierung und Proxy-Management übernimmt. Wer die Infrastruktur selbst wartet, zahlt nichts.

Die Entscheidung zwischen Crawlee, Scrapy und einer „Raw“-Implementierung ist keine Geschmacksfrage, sondern eine strategische Weichenstellung basierend auf deinem vorhandenen Tech-Stack und den Skalierungsanforderungen.

Zielgruppen-Matrix: Wer braucht was?

- Für TypeScript-Web-Entwickler: Crawlee ist die definitive „Batteries-Included“ Lösung. Wer Web-Apps baut und Scraping als Feature integriert, profitiert sofort von der Typensicherheit und dem nahtlosen Wechsel zwischen HTTP- und Headless-Browser-Crawlern.

- Für Data Scientists: Scrapy bleibt der Standard, wenn die Pipeline komplett in Python läuft. Die Integration in Pandas oder direkte AI-Pipelines ist hier ungeschlagen. Ein Wechsel zu Crawlee lohnt sich nur, wenn komplexe Browser-Interaktionen (SPA-Rendering) die Fähigkeiten von

scrapy-playwrightübersteigen. - Für Bastler & Puristen: Wer „Raw“ Playwright oder Puppeteer nutzt, entscheidet sich für maximale Kontrolle, zahlt dafür aber mit hohem Wartungsaufwand für Queues, Retries und Proxies.

Vergleichstabelle: Die harten Fakten

Hier der direkte Vergleich der Architektur-Ansätze:

| Feature | Crawlee (TS/JS) | Scrapy (Python) | Raw Playwright/Puppeteer |

|---|---|---|---|

| Browser Support | First-Class: Nativ integriert inkl. Fingerprint-Management. | Plugin-basiert: Erfordert `scrapy-playwright`; fühlt sich oft „angeflanscht“ an. | Native: Maximale API-Kontrolle, aber keine Abstraktionsschicht. |

| Scaling | AutoscaledPool: Dynamische Concurrency basierend auf CPU/RAM-Last. | Manuell via `CONCURRENT_REQUESTS` Einstellungen. | Manuell (Entwickler ist für Loop & Ressourcen verantwortlich). |

| Anti-Blocking | Session Pools & intelligente Fingerprints out-of-the-box. | Benötigt Middleware-Config (z.B. `scrapy-rotating-proxies`). | Stealth-Plugins (z.B. `puppeteer-extra-plugin-stealth`) müssen selbst gepflegt werden. |

| Queueing | Integriertes RequestQueue-System. | Reife Scheduler-Architektur. | Muss selbst implementiert werden (z.B. via Redis). |

Deep Dive: Skalierung und Anti-Blocking

Der entscheidende technische Vorteil von Crawlee gegenüber „Raw“-Lösungen liegt im AutoscaledPool. Während man bei Raw-Scripten oder Scrapy oft manuell die Concurrency-Limits raten muss (um Memory Leaks zu vermeiden), überwacht Crawlee die Systemressourcen (CPU & RAM) und drosselt oder beschleunigt den Crawler automatisch.

In der Praxis zeigt sich zudem ein enormer Unterschied im Anti-Blocking Management:

- Raw Playwright: Du musst Plugins wie

stealth-extramanuell updaten und konfigurieren, sobald Cloudflare seine Erkennungsmuster ändert. - Crawlee: Browser-Fingerprints und Session-Rotationen sind abstrahiert. Du nutzt einfach integrierte Features, statt Boilerplate-Code für Stealth-Mechanismen zu schreiben.

Fazit zur Architektur: Crawlee eliminiert den „Glue Code“, den man normalerweise schreibt, um Playwright produktionsreif zu machen. Wer jedoch eine reine Python-Umgebung pflegt, sollte nur wechseln, wenn die dynamischen Websites mit scrapy-playwright instabil werden.

Der heilige Gral moderner Scraping-Architektur ist Ressourceneffizienz. Da ein vollwertiger Headless Browser (via Playwright) oft 1GB+ RAM pro Instanz verbraucht, während ein reiner HTTP-Parser (Cheerio) mit einem Bruchteil dessen arbeitet und 10- bis 50-mal schneller ist, sollten wir den Browser nur als letztes Mittel („Last Resort“) einsetzen.

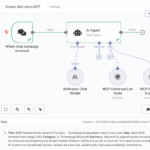

Das Hybrid-Pattern löst dieses Problem durch eine dynamische Eskalations-Strategie: Wir versuchen jeden Request zuerst „billig“ via HTTP. Nur wenn JavaScript-Rendering zwingend nötig ist (oder wir geblockt werden), übergeben wir die Aufgabe an den schweren Browser.

1. Die Architektur: Shared Queue

Das Herzstück dieses Patterns ist die geteilte RequestQueue. Anders als bei isolierten Skripten greifen in Crawlee beide Crawler-Klassen auf denselben Zustand zu. Wir definieren eine Queue, in die der CheerioCrawler fehlschlagende URLs zurücklegt, damit der PlaywrightCrawler sie aufsammeln kann.

2. Implementierung der Weichenstellung

Der Code muss erkennen, wann HTML allein nicht ausreicht. Ein typischer Indikator ist ein fehlender CSS-Selektor (z.B. .price), der darauf hinweist, dass der Inhalt client-seitig via React oder Vue nachgeladen wird.

Hier ist das TypeScript-Setup für dieses Szenario:

import { CheerioCrawler, PlaywrightCrawler, RequestQueue } from 'crawlee';

// Schritt 1: Eine gemeinsame Queue für beide Crawler erstellen

const requestQueue = await RequestQueue.open();

// Schritt 2: Der schnelle "First Line of Defense" Crawler

const cheerioCrawler = new CheerioCrawler({

requestQueue, // Bindung an die Shared Queue

maxRequestRetries: 1, // Wir wollen hier nicht oft retrien, sondern schnell scheitern

requestHandler: async ({ $, request }) => {

// Versuch, Daten aus dem statischen HTML zu ziehen

const price = $('.price').text();

// Check: Fehlt das Datum? Dann brauchen wir wohl JS rendering.

if (!price) {

console.log(`⚠️ JS detected on ${request.url}, moving to browser queue...`);

// WICHTIG: Request nicht verwerfen, sondern erneut in die Queue legen

// Das Flag 'needsBrowser' steuert die Logik.

await requestQueue.addRequest({

url: request.url,

userData: { ...request.userData, needsBrowser: true },

uniqueKey: Math.random().toString() // Erzwingt Duplikat, um Skip zu umgehen

});

return;

}

console.log(`✅ Fast Scrape success: ${price}`);

},

});

// Schritt 3: Der "Heavy Lifter" für schwierige Fälle

const browserCrawler = new PlaywrightCrawler({

requestQueue,

requestHandler: async ({ page, request }) => {

// Dieser Crawler ignoriert alles, was nicht explizit markiert wurde

if (!request.userData.needsBrowser) return;

// Playwright rendert JS, der Selector ist nun verfügbar

const price = await page.locator('.price').innerText();

console.log(`✅ Browser Scrape success: ${price}`);

},

});

// Execution: Erst die schnelle Flotte, dann die schwere Artillerie

await cheerioCrawler.run(['https://shop.example.com/products']);

await browserCrawler.run();

3. Vorteile im Produktionsbetrieb

Diese Methode spart massiv Infrastrukturkosten. In Benchmarks lassen sich ca. 90-95% der Requests auf E-Commerce-Seiten oft statisch lösen. Das bedeutet für die Praxis:

- Durchsatz: Die Basis-Last läuft mit über 500 Seiten pro Minute (auf Standard-Hardware).

- Stabilität: Da

CheerioCrawlerkein Browser-Objekt öffnet, gibt es hier keine „Detached Frame“-Probleme oder Memory Leaks, die bei langlaufenden Playwright-Jobs oft Docker-Restarts erfordern. - Stealth: Sollte der HTTP-Request blockiert werden, wirkt der darauffolgende Playwright-Request (mit neuem Fingerprint und potenziell rotierter IP) wie ein völlig neuer Besucher.

Die Schattenseiten: Produktions-Risiken und „Bloat“

Während das Marketing von Crawlee die „Unified API“ als Heiligen Gral verkauft, zeigen Diskussionen von Power-Usern auf GitHub und Reddit (r/webscraping) eine deutlich differenziertere Realität. Wer Crawlee in einer groß angelegten Produktionsumgebung einsetzt, stößt auf architektonische Hürden, die bei kleinen Skripten unsichtbar bleiben.

Speicherlecks: Der „OOM“-Albtraum

Das größte Risiko für Long-Running Jobs (Scraper, die über Tage oder Wochen laufen) ist das Speichermanagement. Node.js ist berüchtigt für Probleme mit der Garbage Collection bei komplexen Objekt-Referenzen.

- Das Problem: Besonders bei der Nutzung von rotierenden Proxies und Session-Pools werden abgetrennte Browser-Kontexte (

detached contexts) oft nicht schnell genug aus dem Speicher entfernt. - Die Folge: Der RAM-Verbrauch steigt schleichend an, bis der Prozess mit einem OOM (Out of Memory) Crash abstürzt.

- Der „Fix“: In der Praxis behelfen sich DevOps-Teams oft mit einer „Brute Force“-Lösung. Statt das Memory Leak im Code zu jagen, wird der Docker-Container präventiv alle paar Stunden neu gestartet. Das garantiert Stabilität, ist aber weit entfernt von sauberem Software-Design.

Dependency-Hölle: Die Kosten der Abstraktion

Die Entscheidung, alle Crawler (Cheerio, Playwright, Puppeteer) unter einem Dach zu vereinen, führt zu massiven Abhängigkeiten („Bloat“).

- Wer eine schlanke HTTP-Only Lösung (via

CheerioCrawler) bauen will, muss oft dennoch den Ballast des gesamten Frameworks mittragen. - Standard-Installationen ziehen Playwright-Binaries und Browser-Bibliotheken mit sich, selbst wenn diese im Code nie aufgerufen werden.

- Dies bläht Docker-Images unnötig auf und verlängert CI/CD-Pipelines, da Gigabytes an Browser-Dependencies installiert werden, die für einfache Text-Scraper irrelevant sind. Power-User müssen diese manuell ausschließen (

peerDependenciesignorieren), was die Konfiguration verkompliziert.

Enterprise-Ready vs. „Developer Fun“

Crawlee zielt stark auf eine moderne Developer Experience (DX) ab, schießt dabei aber für Enterprise-Umgebungen teilweise übers Ziel hinaus.

Die Standard-Konfiguration ist „geschwätzig“ und beinhaltet Elemente wie ASCII-Art beim Start oder sehr umgangssprachliche („cutesy“) Log-Meldungen. Was in einem Hobby-Projekt charmant wirkt, stört in professionellen Logging-Stacks (z.B. Datadog, ELK-Stack). Diese Logs erzeugen unnötiges Rauschen („Noise“) und erschweren das automatisierte Parsen von echten Fehlermeldungen. Manuelle Konfiguration ist nötig, um das Tool auf ein seriöses Log-Level („Silent“ oder „JSON-only“) zu zwingen.

Fazit

Crawlee ist derzeit die unbestrittene Königsklasse für Web-Scraping im Node.js/TypeScript-Ökosystem. Es löst das größte architektonische Problem der Branche – den Bruch zwischen ressourcensparendem HTTP-Crawling und schwerfälliger Browser-Automatisierung – mit einer Eleganz, die Scrapy inzwischen alt aussehen lässt. Die „Unified API“ ist kein Marketing-Gimmick, sondern ein massiver Produktivitäts-Booster, der Spaghetti-Code verhindert.

Dennoch ist das Tool kein Allheilmittel. Es erkauft sich den Komfort durch massiven „Bloat“ (riesige node_modules, aufgeblähte Docker-Images) und kämpft bei Long-Running-Jobs mit den typischen Node.js-Memory-Problemen. Es ist ein Enterprise-Werkzeug, das bedient werden will, keine leichtgewichtige Library für das schnelle Skript zwischendurch.

Die Entscheidungshilfe:

- Hol es dir, wenn: Du Web-Entwickler bist, TypeScript sprichst und skalierbare Crawler für moderne SPAs (React/Vue) bauen musst. Das Hybrid-Pattern (erst Cheerio, dann Fallback auf Playwright) ist der einzige wirtschaftlich sinnvolle Weg, große Datenmengen zu scrapen.

- Lass die Finger davon, wenn: Dein Team fest in der Python-Welt verankert ist oder du nur einfache, statische HTML-Seiten verarbeitest. Für Letzteres ist Crawlee absoluter Overkill; für Ersteres ist der Migrationsaufwand von Scrapy zu hoch.

- Hör auf damit: „Nacktes“ Playwright oder Puppeteer für Scraping zu nutzen. Du verschwendest Zeit mit Boilerplate-Code für Queues und Retries, die Crawlee „out-of-the-box“ besser löst.

Nächster Schritt:

Installiere Crawlee, aber vertraue nicht blind auf die Standard-Settings. Implementiere sofort die oben beschriebene Shared Queue Architektur. Und der wichtigste Praxistipp: Wenn du das Ding in Produktion (Docker/Kubernetes) bringst, plane regelmäßige Container-Restarts ein. Der „OOM-Killer“ ist real, und präventive Neustarts sind aktuell zuverlässiger als die Jagd nach Memory Leaks.

Kurz gesagt: Crawlee professionalisiert das Scraping und holt es aus der Bastler-Ecke – mit allen Vor- und Nachteilen seriöser Software-Architektur.

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.