Die neue Ironwood TPU (7. Generation) von Google revolutioniert die KI-Infrastruktur mit außergewöhnlicher Leistung und Effizienz. Diese Hardware-Innovation adressiert die wachsenden Anforderungen komplexer KI-Modelle und bietet bedeutende Vorteile für deine Entwicklungs- und Inferenzprozesse.

Die Ironwood-TPU-Technologie von Google bildet das Fundament für die nächste Generation von KI-Anwendungen – von autonomen Agenten bis hin zu Echtzeit-Videogenerierung und komplexen KI-Systemen, die nahtlos in Geschäftsprozesse integriert werden können. Mit Ironwood schiebt Google eine neue Generation Tensor Processing Units (TPU v7) an den Start, die genau darauf zielt.

- Drastisch verbesserte Energieeffizienz ermöglicht nicht nur einen geringeren CO2-Fußabdruck, sondern führt zu erheblichen Kosteneinsparungen bei Training und Inferenz großer Modelle.

- Schnellere Trainingszyklen verkürzen die Zeit von Wochen auf Tage, wodurch du häufiger experimentieren und deine Time-to-Market bei KI-Projekten drastisch reduzieren kannst.

- Spezialisierte Architektur optimiert Matrix-Multiplikationen und behebt den Speicherbandbreiten-Flaschenhals, was die Verarbeitung multimodaler Daten (Text, Bild, Video) deutlich beschleunigt.

- Exklusiv in der Google Cloud Platform verfügbar, bietet Ironwood hervorragende Integration mit JAX und TensorFlow, erfordert jedoch die Berücksichtigung eines potenziellen Vendor-Lock-ins.

- Demokratisierung des Trainings durch geringere finanzielle Eintrittsbarrieren ermöglicht auch kleineren Unternehmen das Training eigener Foundation Models, was zuvor nur Tech-Giganten vorbehalten war.

In der Praxis sieht’s so aus: Dein Modelltraining dauert manchmal ewig, die Cloud-Kosten schießen durch die Decke – und du weißt, dass dies kein skalierbarer Zustand ist. Ironwood verspricht einen echten Richtungswechsel. Schluss mit: „Upgrade um Upgrade, aber das Bottleneck bleibt.“ Hier kommt echte Effizienz ins Spiel, ohne dass du dich durch seitenlange Whitepaper kämpfen musst.

Was erwartet dich im Artikel?

- Wieso Ironwood deinen Workflow im Training und in der Inferenz spürbar beschleunigt

- Wie die Energieeffizienz deine Kosten (und Nerven!) schont

- Wann und für wen der Umstieg auf Ironwood wirklich sinnvoll ist – ohne Vendor-Lock-in-Fallen zu verschweigen

Ironwood TPU: Die neue Generation der KI-Infrastruktur ist da

Google hat gerade die Karten neu gemischt. Mit der Ironwood TPU, der siebten Generation ihrer Tensor Processing Units, wird die Messlatte für Hardware-Performance extrem hoch gelegt. Das ist nicht nur ein kleines Versions-Update – das ist der Treibstoff, den wir für die nächste Welle der Generativen KI dringend brauchen.

Du kennst den Schmerzpunkt mit hoher Wahrscheinlichkeit aus deinen eigenen Projekten: Unsere Modelle werden exponentiell komplexer, die Parameterzahlen explodieren und die Rechenkapazität stößt an physikalische Grenzen.

Das Ende der Fahnenstange? Nicht mit dieser Hardware.

Wir stehen vor einem massiven Infrastruktur-Problem. Der Hunger nach Compute-Power für Training und Inferenz frisst nicht nur Budgets, sondern treibt auch den Energieverbrauch in unhaltbare Höhen. Wenn deine Latenzzeiten hochgehen, leidet die User Experience. Wenn die Stromkosten explodieren, stirbt dein Business Case. Genau hier setzt Google mit Ironwood an. Dieser Chip wurde nicht im Vakuum entwickelt, sondern als direkte Antwort auf die skalierbaren Workloads, die du heute in der Cloud fährst.

Was Ironwood für dich bedeutet

Ironwood ist mehr als nur Silizium; es ist ein Versprechen für die Effizienz deiner Pipeline. Laut Google liegt der Fokus massiv auf einer besseren Energieeffizienz bei gleichzeitig höherer Leistung pro Watt. Für dich als Entwickler oder Tech-Lead bedeutet das konkret:

- Schnellere Iterationen: Wenn das Training von Tagen auf Stunden sinkt, kannst du öfter experimentieren und deine Modelle schneller zur Marktreife bringen.

- Nachhaltige Skalierung: Du kannst größere Modelle deployen, ohne dass dein CO2-Fußabdruck (und deine Cloud-Rechnung) durch die Decke geht.

- Optimierte Inferenz: Deine Anwendungen reagieren schneller. In einer Welt, in der Real-Time-Interaktion mit LLMs der Standard wird, ist Latenz der neue Währungskurs.

Wir bewegen uns weg von „Brute Force“ hin zu intelligenter, spezialisierter Hardware. Ironwood ist das Fundament, auf dem du die KI-Tools von morgen baust. Mach dich bereit, deine Workflows anzupassen – die Hardware ist jetzt bereit für den nächsten Schritt.

Ironwood TPU im Detail: Technische Spezifikationen und Neuerungen

Schluss mit Wartezeiten beim Training. Google legt nach und bringt mit Ironwood die 7. Generation seiner Tensor Processing Units (TPU) an den Start. Wenn du dachtest, Trillium (6. Generation) wäre das Ende der Fahnenstange gewesen, wirst du hier eines Besseren belehrt. Ironwood ist nicht einfach nur ein iteratives Update – es ist ein massiver Sprung für deine Infrastruktur-Performance.

Das Fundament dieses Chips ist Googles konsequenter Custom-Silicon-Ansatz. Anders als bei generischen GPUs, die für Grafik und KI gleichermaßen herhalten müssen, ist Ironwood maßgeschneidert für die Matrix-Multiplikationen moderner Transformer-Modelle. Hard- und Software greifen hier perfekt ineinander.

Was Ironwood besser macht als Trillium

Der direkte Vergleich zur Vorgängergeneration zeigt, wo Google den Hebel angesetzt hat. Für dich als ML-Engineer bedeutet das konkret:

- Massive Speicherbandbreite: Der häufigste Flaschenhals bei großen LLMs ist nicht die Rechenkraft, sondern der Datentransfer. Ironwood bietet deutlich schnelleren High Bandwidth Memory (HBM), damit deine GPUs nicht auf Daten warten müssen („Memory Wall“).

- Optimierte Interconnects: Die Latenz zwischen den Chips im Pod wurde reduziert. Das erlaubt dir, Distributed Training über Tausende von Chips noch linearer zu skalieren.

- Spezialisierte Sparsity-Cores: Die Architektur wurde angepasst, um „Sparse Models“ effizienter zu berechnen. Du kannst also unnötige Parameter im Netz überspringen, ohne Performance zu verlieren.

Effizienz: Mehr Power, weniger Overhead

Hier wird es wirtschaftlich interessant. Leistung um jeden Preis ermöglicht sich heute kaum noch ein Unternehmen leisten. Ironwood setzt neue Maßstäbe bei der Energieeffizienz (Performance pro Watt). Warum ist das für dich wichtig?

- Senkung der Betriebskosten (OpEx): Wenn du Inferenz im großen Stil betreibst, schlägt jeder Watt direkt auf deine Cloud-Rechnung durch. Ironwood liefert mehr Throughput bei gleichem Energieeinsatz.

- Nachhaltigkeit: KI-Training steht regelmäßig wegen des CO2-Fußabdrucks in der Kritik. Mit der 7. Generation kannst du komplexere Modelle trainieren, ohne dass dein ökologischer Footprint explodiert.

Ironwood ist die Antwort auf die Frage, wie wir die nächste Welle von multimodalen Modellen überhaupt noch rechentechnisch bewältigen können. Mach dich bereit, deine Pipelines auf diese neue Power anzupassen.

Ironwood vs. Konkurrenz: So schlägt sich Google gegen NVIDIA und AMD

Der Markt für KI-Beschleuniger ist längst kein reines NVIDIA-Monopol mehr. Mit Ironwood (TPU v7) wirft Google ein echtes Schwergewicht in den Ring, das die Dominanz der H100 und H200 GPUs nicht durch rohe Gewalt, sondern durch intelligente Architektur herausfordert. Für dich als Entwickler oder Architekt heißt das: Du hast endlich valide Alternativen, um deinen Trainings- und Inferenz-Stack zu optimieren.

Spezialisierung vs. Alleskönner

Während NVIDIAs Hopper-Architektur (H100/H200) der unbestrittene Generalist für praktisch jede CUDA-basierte Anwendung ist, spielt Ironwood seine Stärken in einer spezifischen Nische aus: Massive Matrix-Operationen in Googles eigenem Ökosystem.

- Training: Ironwood wurde entwickelt, um riesige Transformer-Modelle effizienter zu skalieren. Dank optischer Interconnects (OCI) können Tausende Chips zu einem Super-Pod vernetzt werden. Das reduziert Latenzen drastisch und beschleunigt die Konvergenz bei großen LLMs.

- Inferenz: Hier glänzt der Chip durch eine enorme Energieeffizienz. Google hat Ironwood so designt, dass er pro Watt mehr Token generiert als vergleichbare GPUs. Das senkt deine laufenden Betriebskosten massiv, sobald dein Modell live geht.

Kosteneffizienz und Ökosystem

Der unter Umständen größte Hebel für dein Budget: Preis-Leistung. NVIDIA-Instanzen sind regelmäßig extrem teuer und knapp. Google positioniert Ironwood in der Google Cloud Platform (GCP) als kostengünstigere Alternative für Workloads, die auf Frameworks wie JAX oder TensorFlow laufen.

Aber Achtung: Du bist hier an das Google-Ökosystem gebunden. Im Gegensatz zu AMDs MI300X, der sich zunehmend als offener Drop-In-Ersatz für NVIDIA positioniert, ist Ironwood ein exklusives Cloud-Produkt. Dafür erhältst du aber eine vertikal integrierte Lösung, bei der Hardware und Compiler (XLA) perfekt aufeinander abgestimmt sind.

Der direkte Vergleich

Hier siehst du auf einen Blick, wo Ironwood im Vergleich zu den Platzhirschen steht:

| Feature | Google Ironwood (TPU v7) | NVIDIA H100 / H200 | AMD Instinct MI300X |

| Primärer Fokus | Effizienz & Skalierung (Training/Inferenz) | Maximale Performance & Flexibilität | Speicherbandbreite & Preis-Leistung |

| Software-Stack | Optimiert für JAX / TensorFlow (PyTorch via XLA) | CUDA (Industriestandard, maximale Kompatibilität) | ROCm (Open Source, holt stark auf) |

| Vernetzung | Proprietäre Optical Circuit Switches (extrem skalierbar) | NVLink / InfiniBand | Infinity Fabric |

| Verfügbarkeit | Exklusiv via Google Cloud (GCP) | Überall (Cloud, On-Prem), aber regelmäßig Lieferengpässe | Cloud (Azure/Oracle) & On-Prem |

| Rockstar-Faktor | 🚀 Beste Wahl für reine Cloud-Native & JAX User | 👑 Der Standard für maximale Flexibilität | 🛠 Der Preis-Leistungs-Herausforderer |

Fazit für dich: Wenn dein Stack bereits in der Google Cloud liegt und du bereit bist, auf JAX oder optimiertes PyTorch zu setzen, ist Ironwood regelmäßig die wirtschaftlichere und skalierbarere Wahl gegenüber der teuren NVIDIA-Hardware.

Praktische Anwendung: Ironwood TPU in Google Cloud nutzen

Genug der Theorie, schauen wir uns an, wie du diese Rechenpower auf die Straße bringst. Ironwood ist nicht nur ein technisches Upgrade, sondern ein echter Gamechanger für deinen Development-Workflow. Wenn du bereit bist, deine Trainingszeiten massiv zu verkürzen, ist hier deine Roadmap.

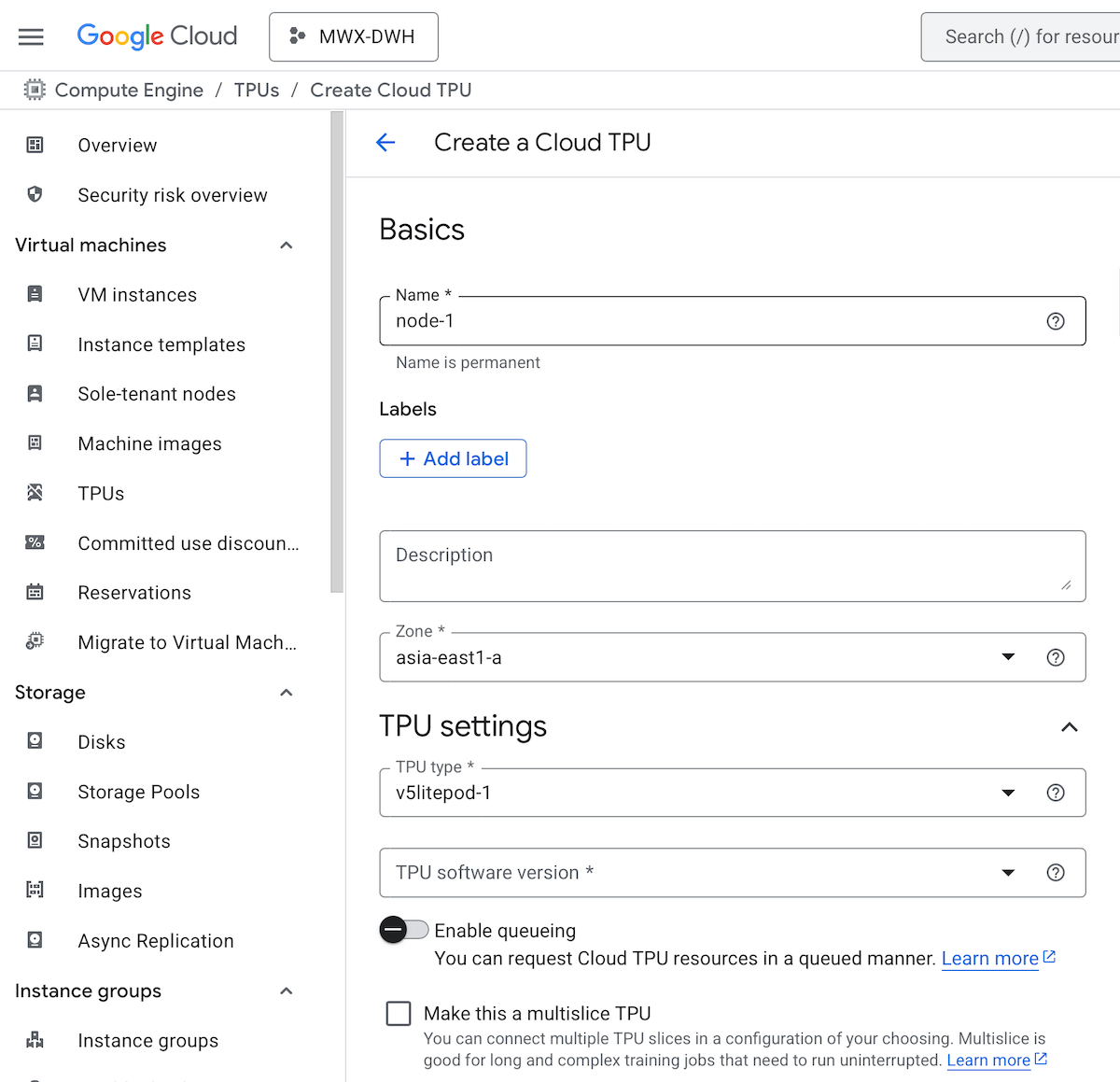

Google Cloud Einrichtung für TPUs

Du musst keine Hardware kaufen oder Serverräume kühlen. Ironwood steht dir direkt über die Google Cloud Platform (GCP) zur Verfügung. Der Zugriff erfolgt typischerweise über TPU Nodes oder TPU VM-Architekturen.

- Setup:

- Starte deine Instanz über die

gcloud-CLI oder die GUI. - Achte darauf, direkt die neuen tpu-v7-ironwood (oder entsprechende Codename-Flags) Zonen auszuwählen. Unterstützte Zonen: see https://docs.cloud.google.com/tpu/docs/regions-zones

- Aktiviere die Cloud-TPU-API: https://console.cloud.google.com/apis/library/tpu.googleapis.com

- Gehe zu Compute Engine, Bereich „TPU“ und erstelle eine neue TPU-Engine: https://console.cloud.google.com/compute/tpus/

- Starte deine Instanz über die

- Erste Schritte: Nutze vorkonfigurierte Deep Learning Images, um Treiberkonflikte zu vermeiden. Du willst coden, nicht debuggen.

Anleitung zur TPU-Erstellung auf HuggingFace: https://huggingface.co/docs/optimum-tpu/en/tutorials/tpu_setup

Workloads: Wann ist Ironwood dein Tool?

Nicht jede Aufgabe braucht einen Vorschlaghammer. Ironwood lohnt sich besonders für massives Parallel-Computing.

- Training von LLMs: Wenn du Transformer-Modelle mit Milliarden von Parametern trainierst.

- Large-Scale Inference: Wenn Latenz dein Endgegner ist und du Echtzeit-Antworten für komplexe GenAI-Modelle brauchst.

- Wissenschaftliche Simulationen: Überall dort, wo Matrix-Multiplikationen dominieren.

Migration und Code: JAX & TensorFlow

Die Zeiten, in denen TPU-Code komplett neu geschrieben werden musste, sind vorbei. Google hat die Software-Stacks massiv optimiert.

- JAX ist King: Ironwood und JAX sind wie füreinander geschaffen. Die Performance-Skalierung über mehrere Pods hinweg ist hier am nahtlosesten.

- TensorFlow & PyTorch: Dank des XLA (Accelerated Linear Algebra) Compilers werden deine bestehenden Graphen effizient auf die TPU-Architektur gemappt.

- Best Practice: Nutze High-Level Libraries wie Flax oder Keras. Sie abstrahieren die Hardware-Verteilung, damit du dich auf die Modell-Architektur konzentrieren kannst.

Der ROI-Check: Lohnt sich der Wechsel?

Hier musst du strategisch denken. Der Stundenpreis für Ironwood mag höher erscheinen als bei Standard-GPUs, aber die Metrik, die zählt, ist „Time-to-Convergence“.

- Wenn du dein Modell in 2 Tagen statt 2 Wochen fertig trainiert hast, sparst du nicht nur Compute-Kosten, sondern gewinnst wertvolle Time-to-Market.

- Für experimentelle kleine Projekte bleib bei kleineren Instanzen. Sobald du aber in die Produktion oder das Fine-Tuning großer Modelle gehst, rechnet sich die Effizienz von Ironwood fast sofort.

Auswirkungen auf die KI-Entwicklung: Training und Inferenz neu gedacht

Lass uns Tacheles reden: Hardware ist nicht nur „Infrastruktur“, sie ist der Begrenzer deiner Kreativität. Wenn dein Modelltraining Wochen dauert, verlierst du nicht nur Zeit, sondern auch den Innovationsvorsprung. Ironwood ändert hier die Spielregeln massiv, besonders wenn du mit gigantischen Parameter-Mengen arbeitest.

Der offensichtlichste Vorteil ist der massive Geschwindigkeitsschub für Large Language Models (LLMs) und komplexe multimodale Systeme. Wir sprechen hier nicht von inkrementellen Verbesserungen. Ironwood wurde spezifisch optimiert, um die Matrix-Multiplikationen, die das Herzstück jedes neuronalen Netzes bilden, effizienter abzuarbeiten.

Das hat direkte Konsequenzen für deinen Workflow:

- Schnellere Iterationszyklen: Du kannst experimentelle Architekturen schneller validieren (oder verwerfen).

- Multimodale Power: Die gleichzeitige Verarbeitung von Text, Bild und Video wird durch den erhöhten Speicherdurchsatz endlich flüssig.

- Skalierbarkeit: Du kannst größere Batches fahren, ohne dass die Performance einbricht.

Google nutzt diese Power natürlich zuerst selbst. Ironwood ist der Motor hinter den neuesten Iterationen von Gemini. Das bedeutet für dich: Wenn du Google-Modelle über die API nutzt, profitierst du indirekt von sinkenden Latenzen und präziseren Outputs, da Google seine Modelle auf dieser Hardware schneller und öfter nachtrainieren ermöglicht.

Aber der unter Umständen spannendste Punkt ist die Demokratisierung des Trainings. Durch die extrem gesteigerte Energieeffizienz pro Rechenoperation sinken die effektiven Kosten für das Training eigener Foundation Models. Vor ein paar Jahren war das Training eines brauchbaren LLMs nur Tech-Giganten vorbehalten. Mit effizienteren TPUs wie Ironwood sinkt die finanzielle Eintrittsbarriere für Startups und mittelständische Unternehmen drastisch.

Zuletzt eröffnet dies neue Horizonte für die Inferenz. Während das Training regelmäßig im Batch-Modus läuft, muss die Inferenz in Echtzeit passieren. Ironwood ermöglicht es, deutlich komplexere Modelle in Echtzeit-Anwendungen zu integrieren, ohne dass der Endnutzer „Lag“ spürt. Das ist der Schlüssel für die nächste Welle von KI-Apps, die nicht nur im Rechenzentrum, sondern als Backend für Edge-Cases und dezentrale Services fungieren. Dein nächster KI-Agent wird also nicht nur klüger, sondern verdammt schnell.

Strategische Einordnung: Chancen, Grenzen und Marktpositionierung

Ironwood ist ein technisches Biest, keine Frage. Aber als Lead Tech Editor sage ich dir: Hardware ist immer nur so gut wie die Strategie dahinter. Bevor du dein gesamtes Trainings-Budget in die neue TPU-Generation wirfst, müssen wir über den Vendor-Lock-in sprechen.

TPUs sind hochspezialisiert. Wenn du deine Modelle und Pipelines – regelmäßig unter Verwendung von JAX oder stark optimiertem TensorFlow – auf die Ironwood-Architektur ausrichtest, bindest du dich exklusiv an die Google Cloud Platform (GCP). Ein späterer Wechsel zu AWS oder Azure? Das wird schmerzhaft und teuer, da du deinen Code refactorn musst, um wieder effizient auf NVIDIA-GPUs zu laufen.

Der Chip-Krieg und die Verfügbarkeit

Wir befinden uns mitten in einem massiven Rüstungswettlauf. Ironwood ist Googles Frontalangriff auf NVIDIAs H100 und den kommenden Blackwell-Chip. Für dich als Nutzer hat dieser „Chip-Krieg“ einen riesigen Vorteil: Konkurrenz drückt langfristig die Preise für Inferenz und Training.

Aber Achtung: High-End-Hardware ist rar.

- Verfügbarkeit: Rechne initial mit Wartezeiten. Die größten Cluster sind regelmäßig für strategische Google-Partner oder interne Projekte (wie Gemini Updates) reserviert.

- Roadmap: Ironwood ist nicht das Ende der Fahnenstange. Die Zyklen werden kürzer. Google optimiert bereits die Nachfolger, um noch spezifischer auf die Architektur von Large Language Models (LLMs) einzugehen. Deine Infrastruktur muss agil bleiben.

Investitionsempfehlung: Für wen lohnt es sich?

Nicht jeder braucht die Power (und die Fesseln) von Ironwood. Hier ist meine Einschätzung für dein Unternehmen:

- Startups & Scale-ups: Wenn Flexibilität deine Währung ist, bleib vorerst bei GPU-basierten Clustern oder setze auf Container, die portabel sind. Der Vendor-Lock-in ermöglicht für junge Firmen tödlich sein, wenn Google die Preise anzieht. Nutze Ironwood nur punktuell für massive Trainings-Jobs, wenn die Kosteneffizienz den Migrationsaufwand schlägt.

- Enterprises: Liegen deine Daten eh schon im Google Data Lake? Trainierst du eigene Foundation Models? Dann ist Ironwood ein No-Brainer. Die vertikale Integration in die GCP-Services (Vertex AI, GKE) spart dir massiv Zeit und Engineering-Ressourcen. Hier schlägt Performance die Flexibilität.

Entscheide dich nicht für den Hype, sondern für den Workflow, der zu deiner Skalierung passt.

Die Infrastruktur der KI-Zukunft nimmt Gestalt an

Vergiss inkrementelle Updates. Mit der 7. Generation seiner TPUs – Codename Ironwood – zeigt Google deutlich, wo der Hammer hängt. Wir reden hier nicht mehr nur über etwas mehr Geschwindigkeit. Wir sprechen über die fundamentale Hardware-Architektur, die notwendig ist, um die wildesten KI-Träume der nächsten Jahre überhaupt erst rechenbar zu machen.

Ironwood ist der Motor, der unter der Haube brummt, während wir an der Oberfläche mit ChatGPT oder Gemini spielen. Die wichtigsten Erkenntnisse, die du mitnehmen musst:

- Massive Effizienz: Mehr Rechenleistung pro Watt bedeutet nicht nur eine grünere Bilanz, sondern handfeste Kosteneinsparungen beim Training riesiger Modelle.

- Speicherbandbreite: Der Flaschenhals bei modernen LLMs ist regelmäßig nicht die Rechenkraft, sondern wie schnell Daten bewegt werden können. Ironwood löst diese Bremse.

- Skalierung: Diese Chips sind dafür gebaut, in Clustern („Pods“) zu arbeiten, die wie ein einziger Supercomputer agieren.

Was heißt das konkret für dich?

Hier trennt sich die Spreu vom Weizen. Je nach deiner Rolle musst du jetzt handeln:

1. Für ML-Engineers & Data Scientists: Wenn du bisher ausschließlich auf GPUs fixiert warst, ist jetzt der Zeitpunkt für den Switch. Die Integration von TPUs in Frameworks wie JAX und PyTorch (via XLA) ist so reibungslos wie nie zuvor. Teste deine Workflows auf der Google Cloud. Du könntest Trainingszeiten von Wochen auf Tage drücken.

2. Für CTOs & Produkt-Manager: Hardware ist kein langweiliges Infrastruktur-Thema mehr, sondern ein echter Wettbewerbsvorteil. Durch die effizientere Inferenz, die Ironwood ermöglicht, kannst du komplexere Modelle (z.B. multimodale Agenten) live schalten, ohne dass deine Unit Economics explodieren. Rechne es durch!

Der Ausblick: Die nächste Innovations-Welle

Ironwood ist der Treibstoff für das, was kommt. Wir bewegen uns weg von reinen Chatbots hin zu autonomen Agenten und Videogenerierung, die echte Rechenmonster sind. Diese Hardware ermöglicht es, KI nicht nur als isoliertes Tool, sondern als Echtzeit-Layer über ganze Geschäftsprozesse zu legen.

Die Infrastruktur steht bereit. Jetzt liegt es an dir, die Software zu bauen, die diese Power auch auf die Straße bringt. Let’s rock this.

Ironwood macht deine KI-Projekte realitätsnah skalierbar

Die Hardware-Revolution ist da, und Ironwood TPU v7 ist der Beweis: KI-Training und Inferenz waren noch nie so effizient und kostengünstig zugleich. Google hat nicht einfach einen neuen Chip gebaut – sie haben die Spielregeln für deine nächste Generation von AI-Anwendungen neu geschrieben.

Diese drei Game-Changer musst du auf dem Schirm haben:

- Energieeffizienz wird zu deinem Budget-Hebel: Ironwood liefert mehr Performance pro Watt. Das bedeutet weniger Cloud-Kosten bei komplexeren Modellen

- Speicherbandbreite löst den Memory-Wall: Deine LLMs warten nicht mehr auf Daten, sondern rechnen kontinuierlich durch

- Skalierung über Tausende Chips: Multi-Pod-Training macht Foundation Models auch für mittlere Unternehmen erschwinglich

Deine nächsten Schritte – heute umsetzbar:

Starte klein, aber starte jetzt. Teste deine kritischen Workloads auf Google Cloud mit TPU v7-Instanzen. Vergleiche deine aktuellen GPU-basierten Trainingszeiten mit Ironwood-Performance. Du wirst überrascht sein.

Überarbeite deine ML-Pipeline für JAX oder optimiertes PyTorch. Die Migration ist weniger aufwendig als gedacht, aber der Performance-Schub ist massiv.

Rechne deine TCO (Total Cost of Ownership) neu durch. Ironwood mag teurer pro Stunde erscheinen, aber kürzere Trainingszeiten und effizientere Inferenz ändern deine Wirtschaftlichkeit fundamental.

Die KI-Infrastruktur von morgen steht heute bereit. Während andere noch über Hardware philosophieren, baust du bereits die Anwendungen, die damit möglich werden.

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.