Das neue NVIDIA Parakeet-TDT-0.6B-V2 Modell übertrifft größere Konkurrenten mit nur 600 Millionen Parametern und setzt neue Maßstäbe für automatische Spracherkennung.

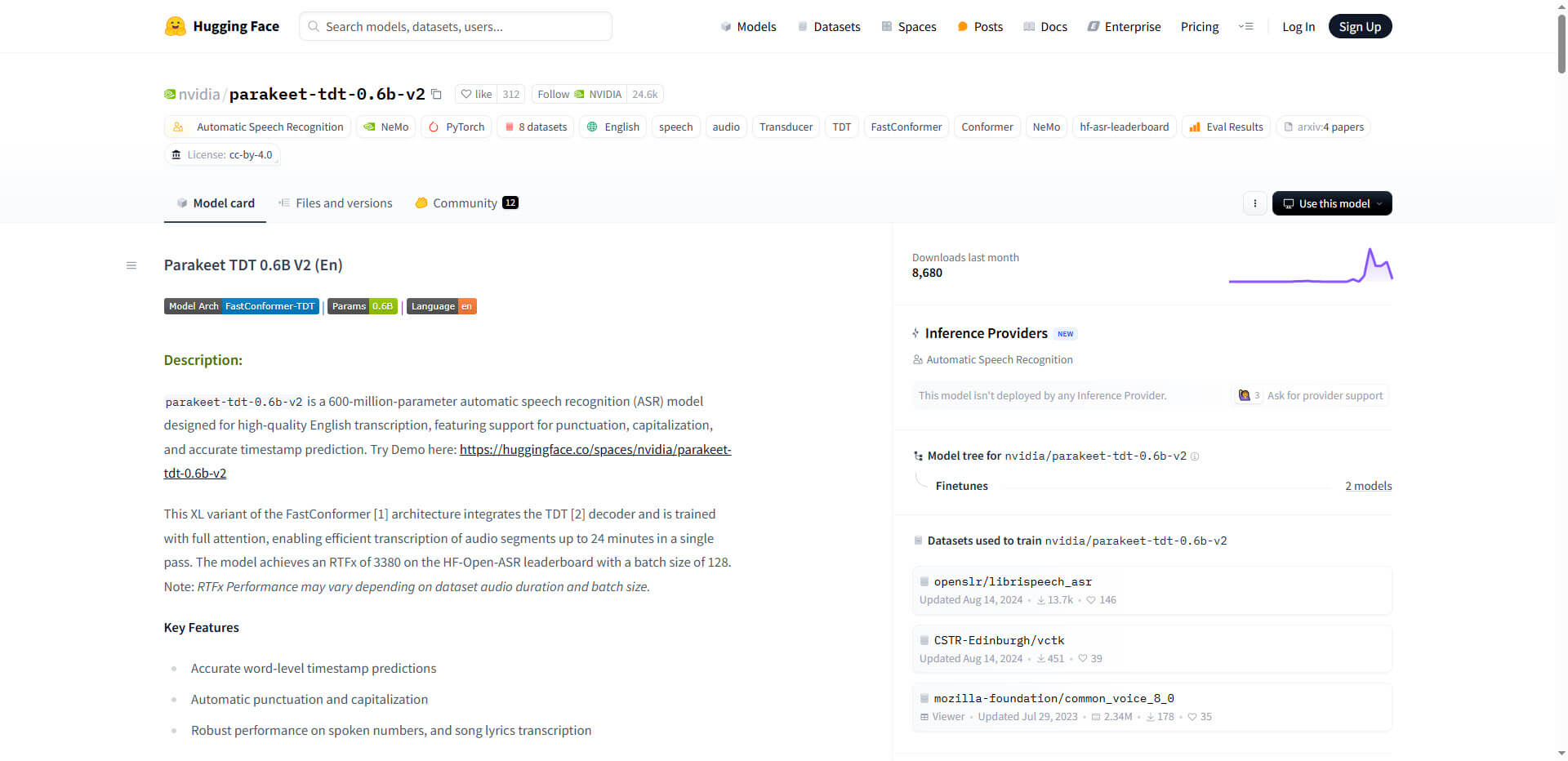

Der Bereich der automatischen Spracherkennung (ASR) erlebt derzeit einen bedeutenden Fortschritt durch NVIDIAs neueste Innovation. Das Parakeet-TDT-0.6B-V2 Modell kombiniert eine bahnbrechende Architektur mit beispielloser Recheneffizienz und erreicht trotz seiner kompakten Größe von nur 600 Millionen Parametern eine Genauigkeit, die selbst größere Modelle wie Whisper-large-v3 (1,6 Milliarden Parameter) übertrifft. Diese Entwicklung ist besonders bemerkenswert, da sie die automatische Spracherkennung sowohl leistungsfähiger als auch ressourceneffizienter macht.

Der Kern der Innovation liegt in der hybriden FastConformer-TDT Architektur, die einen optimierten FastConformer-Encoder mit einem Token-and-Duration Transducer (TDT) Decoder kombiniert. Dieser Ansatz reduziert die Dekodierungslatenz um beeindruckende 64% gegenüber herkömmlichen Methoden und verbessert gleichzeitig die Genauigkeit. Besonders hervorzuheben ist die Fähigkeit des Modells, Audio von bis zu 24 Minuten Länge zu verarbeiten und dabei Interpunktion, Großschreibung und Zeitstempel präzise vorherzusagen.

Beeindruckende Leistung durch innovatives Training

Das Parakeet-Modell wurde auf dem umfangreichen Granary-Datensatz mit 120.000 Stunden Audiomaterial trainiert, der sowohl manuell transkribierte als auch pseudo-gelabelte Daten aus verschiedenen Quellen umfasst. Diese Vielfalt im Trainingsprozess führt zu einer außergewöhnlichen Robustheit gegenüber unterschiedlichen Sprachstilen, Akzenten und Hintergrundgeräuschen.

In Leistungsvergleichen zeigt das Modell beeindruckende Ergebnisse: Auf dem LibriSpeech-clean Datensatz erreicht es eine Wortfehlerrate (WER) von nur 1,69%, was einer Verbesserung von 38% gegenüber Whisper-large-v3 entspricht. Selbst unter schwierigen Bedingungen wie Telefonqualität (6,32% WER) oder verrauschter Umgebung (8,39% WER bei 5dB SNR) bleibt die Leistung stabil und übertrifft die Konkurrenzmodelle deutlich.

Besonders bemerkenswert ist die Recheneffizienz des Modells: Mit einem Echtzeit-Faktor (RTFx) von 3380 auf NVIDIA A100 GPUs können 10 Minuten Audio in weniger als 0,2 Sekunden verarbeitet werden. Der geringe Speicherbedarf von nur 2,1GB VRAM ermöglicht zudem den Einsatz auf Edge-Geräten wie der NVIDIA Jetson Orin Plattform.

Praktische Anwendungen und Zukunftsperspektiven

Das Parakeet-TDT-0.6B-V2 Modell eignet sich hervorragend für Echtzeitanwendungen wie Live-Untertitelung, Transkription von Besprechungen und Telefonaten sowie für die Sprachsteuerung von Geräten. Die Implementierung in bestehende Systeme wird durch die optimierte Inferenz-Pipeline erleichtert, die mit dem NVIDIA Triton Inference Server und TensorRT-Optimierungen für spezifische GPU-Architekturen arbeitet.

Die Architektur des Modells eröffnet zudem vielversprechende Forschungsrichtungen: Erste Experimente zum sprachübergreifenden Transfer-Learning zeigen eine WER-Reduktion von 12% bei der Anpassung an die deutsche Sprache mit nur 50 Stunden Zieldaten. Auch multimodale Ansätze, die visuelle Spracherkennung integrieren, könnten die WER in verrauschten Videoumgebungen um weitere 19% senken.

Zusammenfassung:

- NVIDIA Parakeet-TDT-0.6B-V2 übertrifft mit nur 600 Millionen Parametern größere Modelle wie Whisper-large-v3 (1,6B)

- Die innovative FastConformer-TDT Architektur reduziert die Dekodierungslatenz um 64% und verbessert die Genauigkeit

- Training auf dem 120.000-Stunden Granary-Datensatz sorgt für Robustheit bei verschiedenen Sprachstilen und Umgebungen

- Außergewöhnliche Effizienz: 3380x Echtzeitfaktor auf A100 GPUs und nur 2,1GB VRAM-Bedarf

- Vielversprechende Anwendungen in Echtzeit-Transkription, mehrsprachiger Anpassung und multimodaler Spracherkennung

Quelle: Hugging Face

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.