Google attackiert mit dem Release von Gemini 2.5 – in der Szene als „Nano Banana“ bekannt – frontal die künstlerische Vormachtstellung von Midjourney v7. Während Midjourney weiterhin die ästhetische Referenz bleibt, liefert Googles Modell jetzt perfekten Text im Bild und generiert Assets in rekordverdächtigen zwei Sekunden. Wir analysieren im Detail, ob roher Utility-Speed am Ende doch über den „künstlerischen Soul“ triumphiert.

- Geschwindigkeits-Benchmark: Google Gemini 2.5 liefert Ergebnisse in unter 2 Sekunden (Flash Mode), während Midjourney v7 im Standard-Modus ca. 22 Sekunden benötigt.

- Kosten-Effizienz: Statt Midjourneys Abo-Kosten (bis zu $120/Monat) ermöglicht Google skalierbare Workflows per API für nur $0.05 pro Bild.

- Technische Architektur: Google nutzt einen multimodalen Transformer für perfektes Text-Rendering (z.B. „SALE 2026“), während Midjourney als klassisches Diffusions-Modell oft an Schriftzeichen scheitert.

- Massenverarbeitung: Für E-Commerce-Manager generiert Googles API 100 Bilder in unter 1 Minute, wohingegen Midjourney auf den manuellen Einzelbild-Workflow fokussiert bleibt.

Hier zeigt sich Anfang 2026 eine fundamentale Spaltung des Ökosystems. Während 2024 noch alle Modelle versuchten, „alles für jeden“ zu sein, haben sich die Marktführer nun in komplett unterschiedliche Philosophien diversifiziert. Es ist kein Rennen mehr um das gleiche Ziel, sondern eine Aufteilung des Territoriums.

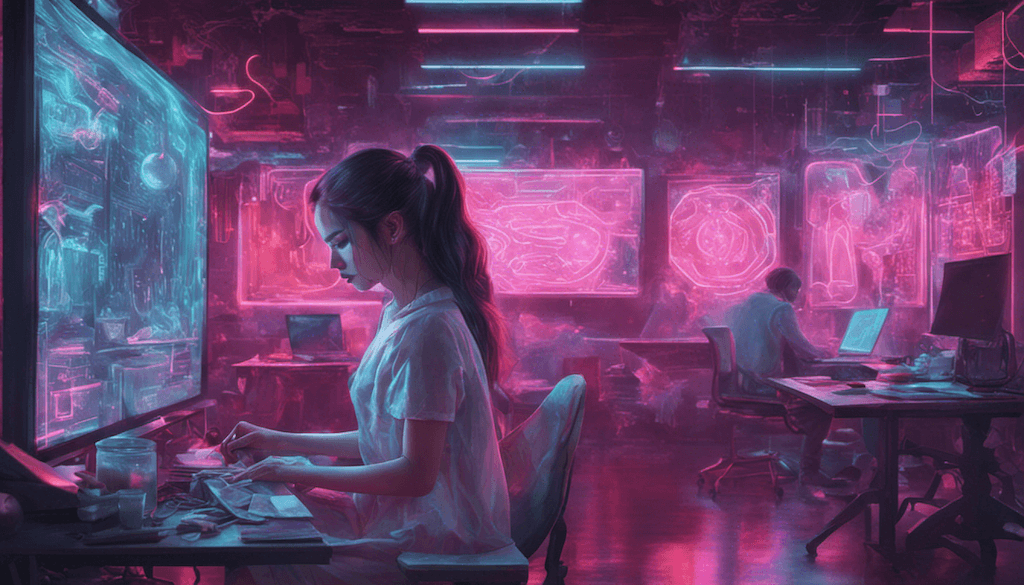

Google: Der utilitaristische Photoshop-Killer

Googles Strategie mit Gemini 2.5 Flash Image (Community-Nickname: „Nano Banana“) zielt nicht darauf ab, den Künstler zu ersetzen, sondern den Prozess. Das Modell positioniert sich als hochskalierbares Werkzeug für den Massenmarkt, bei dem Funktion über Emotion steht.

- Utility First: Statt künstlerischer Freiheit bietet Google brutale Prompt Adherence. Wenn ein E-Commerce-Manager einen „Sneaker auf neon-nassem Asphalt“ bestellt, liefert Google genau das – ohne unerwünschte Interpretationen.

- Multimodales Verstehen: Das Killer-Feature ist hier die visuelle Problemlösung. Man kann Gemini ein Foto eines kaputten Fahrrads zeigen und instruieren: „Zeige mir, wie es repariert aussieht.“ Das Modell versteht den Kontext und generiert die Lösung. Das ist kein reines Text-to-Image mehr, sondern logische Bildbearbeitung.

- Zielgruppe: Coder, Social Media Manager für E-Commerce und Redakteure, die Tausende Assets automatisiert und konsistent benötigen.

Midjourney: Die Festung der „High-End-Ästhetik“

Midjourney v7 hat sich bewusst gegen die sterile Präzision entschieden und verteidigt die Nische der künstlerischen Emotionalität. Trotz Kritik an der sinkenden „Seele“ im Vergleich zu v6 bleibt v7 der Goldstandard für alles, was einen „Wow-Effekt“ erzeugen muss.

- Vibe over Precision: Midjourney opfert oft die exakte räumliche Platzierung von Objekten für einen stimmigeren Gesamtlook (Beleuchtung, Komposition, Textur). Es ist kein Werkzeug für technische Zeichnungen, sondern für Moodboards.

- Der Netflix-Faktor: Wer ein Pitch-Deck für eine Serie oder ein hochauflösendes Cover-Art braucht, akzeptiert den umständlicheren Workflow von v7, weil das Ergebnis weniger nach „Corporate Art Generator“ aussieht als bei Google.

- Zielgruppe: Storyboarder, Concept Artists und Designer, die Atmosphäre wichtiger finden als fotorealistische Logik.

Strategischer Split im Vergleich (Q1 2026)

| Merkmal | Google (Nano Banana) | Midjourney v7 |

|---|---|---|

| Philosophie | Utility: Ersetze Photoshop & Stock-Fotos | Artistry: Ersetze den Öl-Maler & Illustrator |

| Analogie | Hochgeschwindigkeits-Druckerei | Digitales Atelier |

| Stärke | Kontextverständnis & Text-Rendering | Lichtstimmung & „Vibe“ |

| Schwäche | Wirkt oft steril & „soulless“ | Workflow-Hürden & Zensur-Filter |

| Primärer Use-Case | Programmatische Massenerstellung (API) | Einzelbild-Kunstwerke & Pitches |

Fazit aus der Praxis: Wer 2026 ein Marketing-Dashboard baut, integriert Googles API. Wer das Artwork für ein Fantasy-Buch entwirft, nutzt Midjourney. Die Zeiten, in denen ein Tool beide Welten bediente, sind vorbei.

Tech-Shootout: Midjourney v7 gegen „Nano Banana“ (Gemini 2.5)

Anfang 2026 stehen sich zwei technologische Philosophien unversöhnlich gegenüber: Die ästhetische Präzision von Midjourney und die rohe Utility-Power von Google. Während Midjourney v7 auf einem hochspezialisierten, proprietären Diffusions-Modell basiert, setzt Google bei seinem Gemini 2.5 Flash Image Model (Community-Nickname „Nano Banana“) auf einen multimodalen Transformer, der nativ in das LLM integriert ist.

Das Resultat ist ein drastischer Unterschied in der Latenz: Midjourney benötigt im normalen „Fast Mode“ rund 22 Sekunden pro Bild. Selbst im reduzierten „Draft Mode“ vergehen etwa 4 Sekunden. Googles Flash Mode hingegen liefert Ergebnisse in unter 2 Sekunden – faktisch Echtzeit.

Hard Specs im direkten Vergleich

Hier die technischen Eckdaten der aktuellen Marktführer (Stand Q1 2026):

| Feature | Midjourney v7 | Google „Nano Banana“ (Gemini 2.5) |

|---|---|---|

| Architektur | Diffusions-Modell (Fokus Textur/Licht) | Multimodaler Transformer (Native LLM Integration) |

| Geschwindigkeit | ~22s (Standard), ~4s (Draft) | < 2 Sekunden (Flash Mode) |

| Auflösung | Upscale bis 4K+ möglich | Native 1024×1024 (Flash), bis 2048px (Pro) |

| Text-Rendering | Verbessert, aber fehleranfällig | Perfekt lesbar (In-Image Text) |

| Zugang | Web-Interface & Discord | Vertex AI & API (Programmatisch) |

| Kosten | Abo-Modell ($10 – $120 / Monat) | Pay-per-Use ($0.05 / Bild) |

Feature-Fokus: Ästhetik vs. Nutzwert

Bei den Funktionen zeigt sich die Zielgruppentrennung am deutlichsten.

- Midjourney v7 (Der Künstler): Die Stärke liegt in der „Omni Reference“. Dieses Feature sichert Charakter-Konsistenz über mehrere Bilder hinweg, indem es Gesichter und Stilelemente speichert („Personalization“). Der Fokus liegt auf mikroskopischer Kontrolle von Texturen und Lichtstimmung – ideal für High-End-Artworks, wo Zeit keine Rolle spielt.

- Google Gemini 2.5 (Das Werkzeug): Das Killer-Feature ist das In-Image Text Rendering. Während Diffusions-Modelle oft an Schriftzügen scheitern, generiert Gemini fehlerfreie Texte (z.B. auf Schildern oder Labels) direkt im Bild. Zudem ermöglicht die Architektur Multi-Turn Editing: Man kann via Chat Änderungen am Bild vornehmen („Mach den Himmel blau“), ohne den Rest der Komposition zu zerstören.

Die Kosten-Falle: Abo vs. API

Für Unternehmen ist das Pricing der entscheidende Faktor für die Skalierung.

- Midjourney: Setzt klassisch auf SaaS-Abos. Ein professioneller Nutzer zahlt bis zu $120 im Monat für den „Mega“-Plan. Eine offizielle API für Massen-Integretation existiert kaum, was Unternehmen oft zu grauen Drittanbieter-Lösungen zwingt.

- Google: Bietet ein aggressives Pay-per-Use Modell via Vertex AI. Mit $0.05 pro Bild im Flash Mode und $0.24 im Pro Mode ist die Hürde für automatisierte Workflows extrem niedrig. Wer tausende Assets für E-Commerce generieren muss, fährt mit der Google-API rechnerisch günstiger und stabiler als mit manuellen MJ-Seats.

Praxis-Guide: Automatisierungscode vs. kreativer Editor-Workflow

Der tiefste Graben zwischen den beiden Koryphäen verläuft nicht bei der Bildqualität, sondern bei der Integration. Während Google auf skalierbare Pipelines für Developer setzt, optimiert Midjourney den manuellen Loop für Art Direktoren.

Hier ist der direkte Workflow-Vergleich für den Praxiseinsatz 2026:

| Feature | Google „Nano Banana“ (API) | Midjourney v7 (Web Editor) |

|---|---|---|

| Zielgruppe | Developer, E-Com Manager, App-Builder | Designer, Concept Artists, Storyteller |

| Interface | Python / REST API | Web-UI (Canvas) & Discord |

| Kern-Stärke | Batch-Processing (100 Bilder in <1 Min) | Granulare Kontrolle (Inpainting, Zoom) |

| Text-Rendering | Nativ („SALE 2026“ perfekt lesbar) | Verbesserungswürdig, oft „Gibberish“ |

Google „Nano Banana“: Massenproduktion via Python

Für E-Commerce-Plattformen oder dynamische Marketing-Kampagnen ist der Gemini 2.5 Flash Image Endpoint (Community-Code: „Nano Banana“) unschlagbar. Der Use-Case: Sie benötigen 100 Produktvariationen mit korrektem Text-Labeling, ohne einen Grafiker zu beschäftigen.

Dank erstklassiger Optical Character Recognition (OCR) und Render-Fähigkeiten schreibt das Modell Texte wie „SALE 2026“ fehlerfrei direkt in die Neon-Reklame des Bildes. Der folgende 5-Zeilen-Stack generiert ein fertiges Marketing-Asset in unter 3 Sekunden:

import google.genai as genai

from PIL import Image

import io

# Initialisierung (API Key notwendig)

client = genai.Client(api_key="DEIN_API_KEY")

# Prompt: Beachtet die explizite Text-Anforderung

prompt = "Ein futuristischer Sneaker auf neon-nassem Asphalt, Seitenansicht. Im Hintergrund Leuchtreklame mit dem Text 'SALE 2026'. Fotorealistisch, 8k."

response = client.models.generate_content(

model="gemini-2.5-flash-image",

contents=[prompt],

config={

"response_modalities": ["IMAGE"],

"aspect_ratio": "16:9" # Native Unterstützung ohne Cropping

}

)

# Speichern des Assets

for part in response.parts:

if part.inline_data:

image = Image.open(io.BytesIO(part.inline_data.data))

image.save("sneaker_campaign_2026.png")

print("Asset generiert: sneaker_campaign_2026.png")

Midjourney v7: Der manuelle „Art Director“-Workflow

Wer keine Massenware, sondern das perfekte Buchcover oder Pitch-Deck-Image sucht, nutzt den Midjourney Web-Editor. Die Zeit von Discord-Hacks ist vorbei; v7 glänzt durch Character Consistency und präzises Inpainting.

Ein typischer Workflow für ein Fantasy-Buchcover sieht 2026 so aus:

- Basis-Generierung: Der Prompt

fantasy landscape, ethereal fog, ancient ruins --v 7 --personalizesetzt das Grundgerüst und nutzt die gelernte Ästhetik des Users. - Omni Reference (–cref): Um den Protagonisten konsistent zu halten, laden Sie ein Referenzbild hoch und taggen es als Character Reference. Midjourney überträgt Gesichtsstrukturen und Kleidung exakt in die neue Szene.

- Vary Region (Inpainting): Hält die Figur das Schwert falsch? Kein neuer Prompt nötig.

- Markieren Sie im Web-Interface die Hand.

- Ändern Sie den lokalen Prompt auf „hold a glowing orb“.

- V7 rendert nur diesen Ausschnitt neu, Licht und Schatten der Umgebung bleiben perfekt erhalten.

Fazit: Google liefert „Utility“ per Code, Midjourney liefert „Craftsmanship“ per Handarbeit.

Wer die Hochglanz-Broschüren ignoriert und in den Foren von r/LocalLLaMA oder HackerNews gräbt, findet schnell die Limitierungen, die in keinem Marketing-Deck stehen. Die Community-Kritik lässt sich Anfang 2026 auf einen Nenner bringen: Midjourney verliert seine Seele, Google verliert seine Nerven bei der Sicherheit.

Hier sind die größten Frust-Faktoren im direkten Vergleich:

| Pain Point | Midjourney v7 | Google „Nano Banana“ (Gemini 2.5) |

|---|---|---|

| Community-Urteil | „Sterile Perfektion“ | „Corporate PowerPoint Generator“ |

| Haupt-Bug | Inkonsistente Prompt Adherence im Vergleich zu v6.1 | „I am an LLM“-Bug (Verweigerung der Generierung) |

| Filter-Problem | Censorship Creep (harmlose Prompts geblockt) | Extrem strikte Safety-Filter (Marken, Personen) |

| Qualitäts-Gate | Gleichbleibend hoch | Web-Drosselung: API > Web Interface |

Midjourney v7: Der „Soulless“-Effekt

Technisch ist v7 ein Meilenstein – Hände haben fünf Finger, die Anatomie stimmt. Doch genau das wird zum Problem. Power-User kritisieren massiv, dass die Bilder wie glatte Stock-Fotos wirken. Der „künstlerische Soul“ und die zufälligen, ästhetischen Imperfektionen von v6 sind einer sterilen Hochglanz-Optik gewichen.

Ein Top-Kommentar auf Reddit fasst die Stimmung zusammen: „V7 ist offiziell schlechter als 6.1“, da die Prompt Adherence (das Befolgen von Anweisungen) oft schwächer wirkt als bei der Konkurrenz. Dazu kommt ein aggressiverer NSFW-Filter, der selbst harmlose Storytelling-Prompts wie „Woman in bar“ blockiert und damit professionelle Workflows stört.

Google Gemini 2.5: Identitätskrise und Drosselung

Bei Google (Nickname „Nano Banana“) liegt das Problem nicht in der Ästhetik, sondern in der Usability. Das größte Ärgernis ist der sogenannte „I am an LLM“-Bug. Obwohl das Modell nativ Bilder generieren kann, verweigert es in Chat-Sessions häufig den Dienst mit dem Hinweis, es sei ein reines Sprachmodell. User müssen oft neue Chats starten, um das Modell „aus dem Schlaf zu wecken“.

Zusätzlich fühlen sich Consumer-Nutzer benachteiligt:

- Web-App vs. API: Wer über

gemini.google.comgeneriert, erhält oft auf 1024px limitierte, teilweise verwaschene Ergebnisse. - API-Qualität: Die volle Schärfe und Detailtiefe gibt es nur über den kostenpflichtigen API-Zugriff ($0.24/Bild im Pro Mode).

Während Midjourney also mit seiner künstlerischen Ausrichtung kämpft, wird Google als „Corporate Art Generator“ verspottet: Perfekt für Business-Präsentationen und absolut sicher (keine Marken, keine Promis), aber ohne jede „Vibe“-Nuance für echte Kunst.

Fazit

Der Kampf um die „eierlegende Wollmilchsau“ der KI-Bildgenerierung ist 2026 offiziell beendet. Wir sehen keinen Wettkampf mehr, sondern eine Segregation. Google und Midjourney haben sich in gegensätzliche Ecken des Rings zurückgezogen: Hier die brutale Effizienz der Automatisierung, dort die (noch) uneingeholte Ästhetik des digitalen Ateliers. Wer heute noch pauschal fragt, welches Tool „besser“ ist, hat den Markt nicht verstanden. Die Romantik ist vorbei – es geht nicht mehr um Kunst, sondern um Prozesse.

Die Entscheidungshilfe:

- Nimm Google (Nano Banana), wenn: Du skalieren musst. Dein Jobtitel ist Developer, E-Commerce-Manager oder Performance Marketer. Du brauchst 1.000 Produktbilder mit korrektem Text („SALE 2026“) in 5 Minuten via Python. Hier regiert „Utility“ und niedrige Kosten per API. Nimm in Kauf, dass die Bilder oft nach Corporate-Stock-Foto aussehen.

- Bleib bei Midjourney v7, wenn: Du das eine perfekte „Hero-Image“ brauchst. Du bist Art Director, Concept Artist oder Storyteller. Du brauchst Vibe, Atmosphäre und „Omni Reference“ für konsistente Charaktere. Nimm die workflow-feindlichen Hürden, die teuren Abos und die Wartezeiten in Kauf, denn Google kann diese ästhetische Tiefe schlicht nicht liefern.

- Lass die Finger von Midjourney, wenn du automatisieren willst – es gibt keine vernünftige API.

- Lass die Finger von Google, wenn du künstlerische Freiheit suchst – die Zensur-Filter und der Mangel an „Seele“ ersticken jede Kreativität im Keim.

Action:

Überprüfe deine Abos. Für 90% der reinen „Bilderzeugung“ (Blogpost-Header, Social Media Futter) ist Googles Pay-per-Use-Modell via Vertex AI mittlerweile effizienter und billiger. Behalte Midjourney als Luxus-Tool für die 10% der Arbeit, bei denen der Kunde „Wow“ sagen muss. Die Zeit der One-Tool-Solutions ist vorbei – bau dir deinen Stack aus Spezialisten.

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.