Wieder ist eine Woche vergangen und wieder gab es spannende Neuigkeiten im Bereich AI. Diese Woche mit dabei: Google Lumiere, MidJourney V6-Update und Google Chrome.

OpenAIs ChatGPT-Beta: Ein Sprung in Richtung multifunktionaler KI-Assistenten

OpenAI hat eine innovative Beta-Funktion für ChatGPT eingeführt, die es ermöglicht, mehrere GPTs in einem einzigen Chatfenster zu integrieren. Durch das Verwenden des „@“-Zeichens können Benutzer spezifische GPTs ansprechen, die daraufhin interaktiv antworten. Dieses Feature demonstriert OpenAIs Streben, ChatGPT zu einem vielseitigen, persönlichen Assistenten zu entwickeln. Die Funktion ermöglicht es, verschiedene GPT-Persönlichkeiten, wie beispielsweise nachgebildete Chatbots von Donald Trump und Joe Biden, miteinander interagieren zu lassen.

| Key Point | Details |

|---|---|

| Funktion | Beta-Feature in ChatGPT zur Integration mehrerer GPTs in einem Chatfenster |

| Mechanismus | Aktivierung spezifischer GPTs mittels „@“-Zeichen |

| Beispiel | Interaktion zwischen simulierten Chatbots (z.B. Donald Trump und Joe Biden) |

| Ziel von OpenAI | Entwicklung von ChatGPT zu einem universellen, personalisierten Assistenten |

Link: https://the-decoder.de/chatgpts-neueste-funktion-ist-openais-naechster-schritt-hin-zum-allzweck-assistenten/

Hier ist unser Artikel zu den GPT Mentions und wie ihr das GPT Mention Feature bestmöglich anwenden und für euch nutzen könnt.

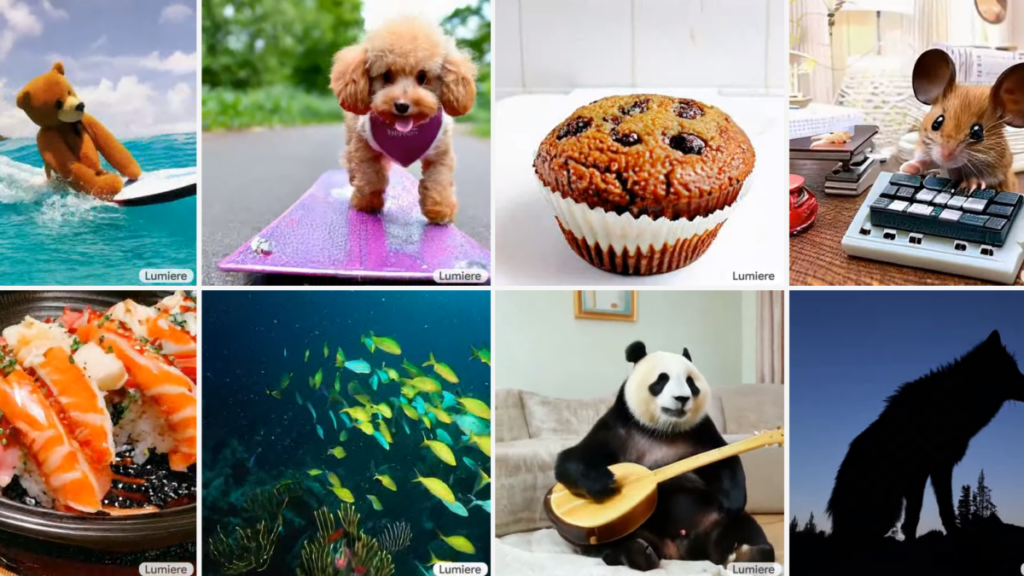

Lumiere von Google: Durchbruch in generativer KI für realitätsnahe Videos

Google präsentiert Lumiere, ein innovatives Text-zu-Video (T2V) Diffusionsmodell, das neue Maßstäbe in der Videoerstellung setzt. Mit seiner einzigartigen Space-Time U-Net (STUNet) Architektur erzeugt Lumiere Videos mit kohärenten Bewegungen und hoher Qualität. Im Gegensatz zu früheren Modellen, die auf einer Modellkaskade basierten, generiert Lumiere die gesamte Videosequenz auf einmal, was zu realistischeren Bewegungen führt. Das Modell wurde mit 30 Millionen Videos trainiert und zeigt beeindruckende Ergebnisse im Vergleich zu anderen Methoden.

| Key Point | Details |

|---|---|

| Projekt | Lumiere von Google |

| Modelltyp | Text-zu-Video (T2V) Diffusionsmodell |

| Besonderheit | Space-Time U-Net (STUNet) Architektur für kohärente Bewegungen und hohe Qualität |

| Training | 30 Millionen Videos mit zugehörigen Text-Untertiteln |

| Videoeigenschaften | 80 Frames bei 16 Frames pro Sekunde, 5 Sekunden lange Videos |

Link: https://the-decoder.de/lumiere-google-zeigt-neue-generative-ki-fuer-realistische-videos/

Midjourneys V6-Update: Neue Dimensionen in der KI-gesteuerten Bildbearbeitung

Midjourney hat sein V6-Update veröffentlicht, das die Funktionen Schwenken, Zoomen und Variieren (Region) einführt. Diese Funktionen erlauben eine verbesserte Bildbearbeitung mit mehr Kohärenz und weniger Wiederholungen. Die Pan-Funktion kombiniert Schwenken und Zoomen und ist kompatibel mit Upscale, Vary (Region) und Remix. Das Update macht auch Midjourneys Alpha-Webseite, die Bildgenerierung ermöglicht, für Nutzer zugänglicher, die mindestens 5000 Bilder erstellt haben. Zusätzlich gibt es eine neue Feedback-Funktion, um die Entwicklungsarbeit zu optimieren.

Key Pointe-Tabelle

| Key Point | Details |

|---|---|

| Update | Midjourneys V6-Update mit neuen Bildbearbeitungsfunktionen |

| Neue Funktionen | Schwenken, Zoomen und Variieren (Region) für verbesserte Bildgestaltung |

| Pan-Funktion | Kombination aus Schwenken und Zoomen, kompatibel mit Upscale, Vary (Region) und Remix |

| Website-Zugang | Erweiterte Zugänglichkeit der Alpha-Webseite für aktive Nutzer |

| Feedback-Feature | Neue Funktion zur Verbesserung der Entwicklungsarbeit basierend auf Nutzer-Feedback |

Link: https://the-decoder.de/midjourneys-v6-update-bringt-pan-zoom-vary-und-breiteren-website-zugang/

Meta-Prompting: Eine neue Ära in der Effizienz großer Sprachmodelle

Meta-Prompting, entwickelt von Forschern der Stanford University und OpenAI, ist ein innovatives Verfahren, das die Leistung von großen Sprachmodellen bei logischen Aufgaben verbessert. Es funktioniert, indem komplexe Aufgaben in kleinere, handhabbare Teile zerlegt und von spezialisierten „Experten“-Modellen bearbeitet werden. Dieser Ansatz hat in Experimenten mit GPT-4 bessere Ergebnisse als herkömmliche Prompting-Methoden erzielt, insbesondere bei logischen Herausforderungen.

| Key Point | Details |

|---|---|

| Entwicklung | Von Forschern der Stanford University und OpenAI |

| Verfahren | Meta-Prompting zur Leistungssteigerung großer Sprachmodelle |

| Funktion | Zerlegung komplexer Aufgaben in kleinere Teile für Expertenmodelle |

| Anwendungsbereich | Besonders effektiv bei logischen Aufgaben |

| Ergebnisse | Übertrifft herkömmliche Prompting-Methoden in Experimenten mit GPT-4 |

Link: https://the-decoder.de/meta-prompting-kann-die-logik-leistung-grosser-sprachmodelle-verbessern/

Längere Denkprozesse: Ein Schlüssel zur Verbesserung von Sprachmodellen

Eine Studie offenbart, dass „Chain of Thought“-Prompts, also längere Gedankenketten, die Leistungsfähigkeit großer Sprachmodelle wie GPT-4 signifikant steigern können, selbst wenn sie fehlerhafte Informationen enthalten. Diese Methode verbessert die Argumentationsfähigkeit der Modelle, indem sie komplexe Probleme in ausführlichere Schritte zerlegt. Erstaunlicherweise zeigen die Ergebnisse, dass die Länge der Gedankenketten wichtiger ist als die exakte Richtigkeit jedes einzelnen Schrittes.

| Key Point | Details |

|---|---|

| Studienbefund | Längere Chain-of-Thoughts verbessern Sprachmodelle |

| Einfluss | Längere Gedankenketten wichtiger als Genauigkeit der Schritte |

| Anwendung | Besonders effektiv bei komplexen Problemlösungen |

| Modelle | Wirksam bei großen Sprachmodellen wie GPT-4 |

Link: https://the-decoder.de/prompt-engineering-laengere-chain-of-thoughts-verbessern-die-leistung-von-sprachmodellen/

Google’s Gemini-Pro: Eine neue Ära für Bard auf GPT-4-Niveau

Google hat ein neues, leistungsfähigeres Gemini-Pro-Modell für seinen Chatbot Bard vorgestellt, das in der menschlichen Bewertung auf dem Niveau von GPT-4 liegt. Das Modell belegte auf Anhieb den zweiten Platz im neutralen Benchmark der Chatbot Arena, knapp hinter dem GPT-4-Turbo. Zudem plant Google die baldige Veröffentlichung von Gemini Ultra, das Gemini-Pro-Scale in seiner Leistungsfähigkeit noch übertreffen soll.

| Key Point | Details |

|---|---|

| Modell | Gemini-Pro für Googles Bard |

| Leistung | Vergleichbar mit GPT-4 |

| Ranking | Zweiter Platz in der Chatbot Arena |

| Zukünftiges Update | Einführung von Gemini Ultra geplant |

Link: https://the-decoder.de/google-veroeffentlicht-neues-bard-gemini-modell-das-auf-gpt-4-niveau-liegen-koennte/

OpenAI’s GPT-4: Leistungsstärker und preisgünstiger

OpenAI hat sein GPT-4-Modell (gpt-4-0125-preview) verbessert, das effizienter arbeitet und die sogenannte „Faulheit“ reduziert, die sich in unvollständigen Antworten äußerte. Zudem senkt OpenAI die Preise für das GPT-3.5-Turbo-Modell und führt zwei neue Einbettungsmodelle ein: text-embedding-3-small und text-embedding-3-large. Neue Verwaltungstools für API-Schlüssel bieten Entwicklern mehr Kontrolle und Einblick in die API-Nutzung.

| Key Point | Details |

|---|---|

| Modellverbesserung | GPT-4 (gpt-4-0125-preview), effizienter und mit reduzierter „Faulheit“ |

| Preissenkung | Preise für GPT-3.5-Turbo-Modell reduziert |

| Neue Einbettungsmodelle | Text-embedding-3-small und text-embedding-3-large |

| API-Verwaltungstools | Neue Tools für bessere Kontrolle und Übersicht der API-Nutzung |

Link: https://the-decoder.de/openai-stellt-verbessertes-gpt-4-modell-vor-und-senkt-die-api-preise/

Nvidias RTX Video HDR: Revolutioniert SDR-zu-HDR-Video-Konvertierung

Nvidia stellt mit RTX Video HDR eine beeindruckende KI-Lösung vor, die Standard Dynamic Range (SDR)-Videos in High Dynamic Range (HDR)-Videos umwandelt. Dieses Tool arbeitet in Kombination mit RTX Video Super Resolution und benötigt für die HDR-Funktionalität einen HDR10-kompatiblen Monitor. Es ist in Chromium-basierten Browsern verfügbar und erfordert den Januar-Studio-Treiber sowie die Aktivierung der Windows HDR-Funktionen.

| Key Point | Details |

|---|---|

| Produkt | Nvidia RTX Video HDR |

| Funktion | Wandelt SDR-Videos in HDR-Videos um |

| Kompatibilität | Erfordert HDR10-kompatiblen Monitor |

| Verfügbarkeit | In Chromium-basierten Browsern |

| Zusätzliche Anforderungen | Januar-Studio-Treiber und Windows HDR-Funktionen |

Link: https://the-decoder.de/nvidia-rtx-video-hdr-wandelt-sdr-videos-mit-ki-in-hdr-videos-um/

Google Ads und Gemini-Chatbot: Revolutioniert die Erstellung von Suchkampagnen

Google Ads hat das fortschrittliche KI-Modell Gemini integriert, um die Erstellung von Suchkampagnen durch einen Chat-basierten Workflow zu optimieren. Diese Funktion, die derzeit in den USA und Großbritannien für englischsprachige Nutzer verfügbar ist, ermöglicht es, Anzeigeninhalte einschließlich Werbemitteln und Keywords effizienter zu gestalten. Besonders kleine Unternehmen profitieren von dieser Innovation, indem sie ihre Anzeigenqualität um 42 % steigern. In naher Zukunft wird die Funktion auch KI-generierte Bilder vorschlagen, versehen mit Wasserzeichen und Metadaten.

| Key Point | Details |

|---|---|

| Integration | Gemini-KI-Modell in Google Ads |

| Funktion | Chat-basierte Erstellung von Suchkampagnen |

| Verfügbarkeit | Aktuell für englischsprachige Nutzer in den USA und Großbritannien |

| Vorteil | Steigerung der Anzeigenqualität um 42 % für kleine Unternehmen |

| Zukünftige Funktion | Einbindung von KI-generierten Bildern mit Wasserzeichen und Metadaten |

Link: https://the-decoder.de/mit-google-ads-kann-man-jetzt-suchkampagnen-mit-einem-gemini-chatbot-erstellen/

Chromes KI-Revolution: Tab-Auto-Sortierung und Schreibhilfe für effizienteres Surfen

Google Chrome führt mit dem neuesten Update (M121) drei neue KI-Funktionen ein: den Tab-Organizer, KI-generierte Designs und einen Schreibassistenten. Der Tab Organizer erleichtert die Verwaltung von Tabs durch automatisches Gruppieren basierend auf dem Inhalt, während die KI-generierten Designs individuelle Browser-Themen ermöglichen. Die „Help me write“-Funktion unterstützt Nutzer beim Verfassen von Texten, indem sie KI-generierte Vorschläge bereitstellt. Diese Innovationen werden das Nutzererlebnis und die Effizienz beim Surfen im Internet erheblich verbessern.

| Key Point | Details |

|---|---|

| Chrome Update | M121 mit neuen KI-Funktionen |

| Tab Organizer | Automatisches Gruppieren von Tabs basierend auf Inhalt |

| KI-generierte Designs | Individuelle Browser-Themen |

| Schreibassistent | „Help me write“-Funktion für KI-generierte Textvorschläge |

Link: https://the-decoder.de/ki-updates-fuer-chrome-bringen-auto-sortierung-fuer-tabs-und-schreibhilfen/

Google strebt 2024 die Führung in der KI-Entwicklung an – doch der Weg ist noch weit

Google hat sich für 2024 das Ziel gesetzt, die weltweit fortschrittlichste, sicherste und verantwortungsvollste KI zu entwickeln. Dies umfasst die Integration von KI in bestehende Produkte wie Geschäftsanwendungen, Pixel-Smartphones und generative Suche, aber das Unternehmen hat noch keinen erfolgreichen eigenständigen KI-Produkt wie ChatGPT entwickelt. Der Verlust von Geschäft im Cloud-Bereich an Microsoft, das dank der Zusammenarbeit mit OpenAI schneller wächst, und der Druck auf die Qualität der Google-Suche durch KI-Spam sind Herausforderungen auf diesem Weg.

| Key Point | Details |

|---|---|

| Zielsetzung | Entwicklung der weltweit fortschrittlichsten KI |

| Produktintegration | KI in bestehende Produkte wie Geschäftsanwendungen, Pixel-Smartphones |

| Cloud-Geschäft | Verlust an Microsoft aufgrund der OpenAI-Kooperation |

| Suchqualität | Unter Druck durch KI-Spam |

Link: https://the-decoder.com/google-aims-to-deliver-worlds-most-advanced-ai-in-2024-and-it-certainly-has-a-long-way-to-go/

RunwayMLs Innovation: Mit dem Multi-Motion Brush von Bildern zu Videos

RunwayML revolutioniert die Videobearbeitung mit dem Multi-Motion Brush, einem Tool, das statische Bilder in animierte Videos verwandelt. Benutzer können bis zu fünf Objekte in einem Bild individuell animieren, wodurch neue Dimensionen der Kreativität freigesetzt werden. Diese technologische Neuerung ist benutzerfreundlich und erweitert die Möglichkeiten im Bereich der visuellen Inhalte erheblich.

Key Pointe-Tabelle

| Key Point | Details |

|---|---|

| Tool | Multi-Motion Brush von RunwayML |

| Funktion | Verwandelt statische Bilder in animierte Videos |

| Objekt-Animation | Bis zu fünf Objekte pro Bild animierbar |

| Benutzerfreundlichkeit | Intuitive Bedienung für breites Anwendungsspektrum |

Link: https://www.analyticsvidhya.com/blog/2024/01/runwayml-introduces-a-multi-motion-brush-to-turn-images-into-videos/

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.