Du möchtest RAG-Systeme nicht nur verstehen, sondern produktionsreif umsetzen? Dieser Guide führt dich in 30 Tagen von der Datenstrategie bis zum Live-Betrieb – mit konkreten Kosten, bewährten Tool-Entscheidungen und einem realen Case-Beispiel aus dem Mittelstand.

- RAG kombiniert aktuelle Wissensdatenbanken mit LLM-Intelligenz und liefert dir präzise Antworten aus deinen eigenen Dokumenten – ohne teures Fine-Tuning, das bei jeder Datenänderung wiederholt werden müsste und schnell fünfstellige Beträge kostet.

- Die richtige Vector Database entscheidet über Latenz und Skalierbarkeit: Pinecone startet in 10 Minuten (ab 70 Euro monatlich), Weaviate bietet Hybrid-Search für deutsche Fachtexte (30 Prozent weniger Retrieval-Fehler), Milvus schafft 25.000 Queries pro Sekunde bei 100 Millionen Vektoren.

- Chunk-Größe ist kritischer als dein LLM-Modell – Tests zeigen, dass 200 bis 350 Token mit 10 bis 20 Prozent Überlappung die besten Ergebnisse für deutschsprachige Texte liefern; bei rechtlichen Dokumenten erhöhe den Overlap auf 30 Prozent, damit Definitionen nicht verloren gehen.

- Re-Ranking senkt deine LLM-Kosten um bis zu 60 Prozent: Ein zusätzlicher Layer sortiert die Top-20-Retrieval-Ergebnisse neu und wählt die relevantesten fünf aus – Kosten circa 0,002 Euro pro Anfrage, Einsparung bis zu 900 Euro monatlich bei 100 täglichen Anfragen.

- Automatisierte Datenaktualisierung via Blue-Green-Indexing verhindert Downtime beim Reindexing: Baue einen neuen Index parallel auf, switch den Traffic atomic um und spare 90 Prozent der Kosten, indem nur geänderte Dokumente neu geembeddet werden.

- ROI erreicht nach vier bis zwölf Monaten: Ein mittelständisches SaaS-Unternehmen reduzierte Support-Tickets um 43 Prozent mit einem Budget von 2.500 Euro monatlich – eingesparte Personalkosten amortisierten die Investition bereits nach vier Monaten.

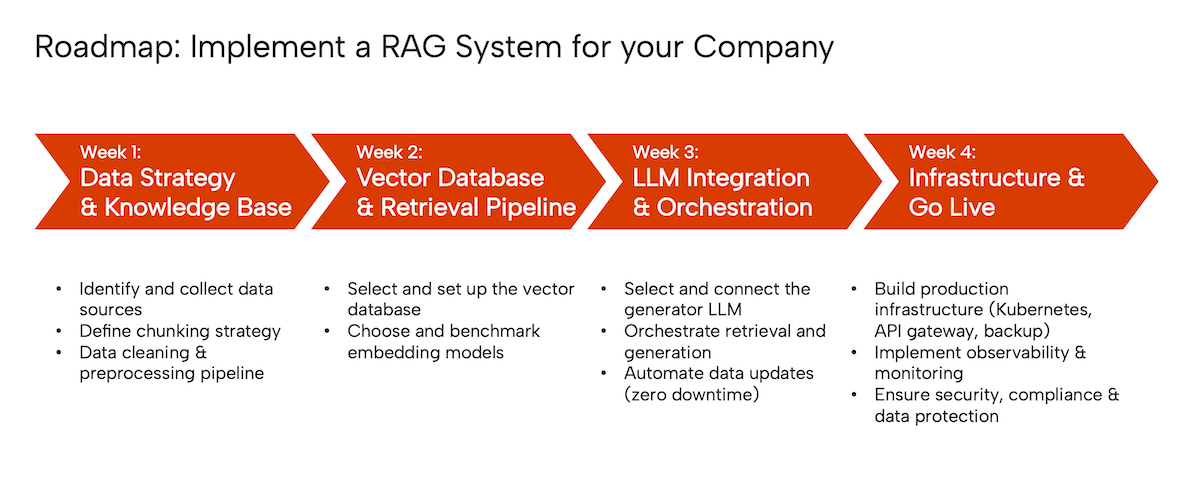

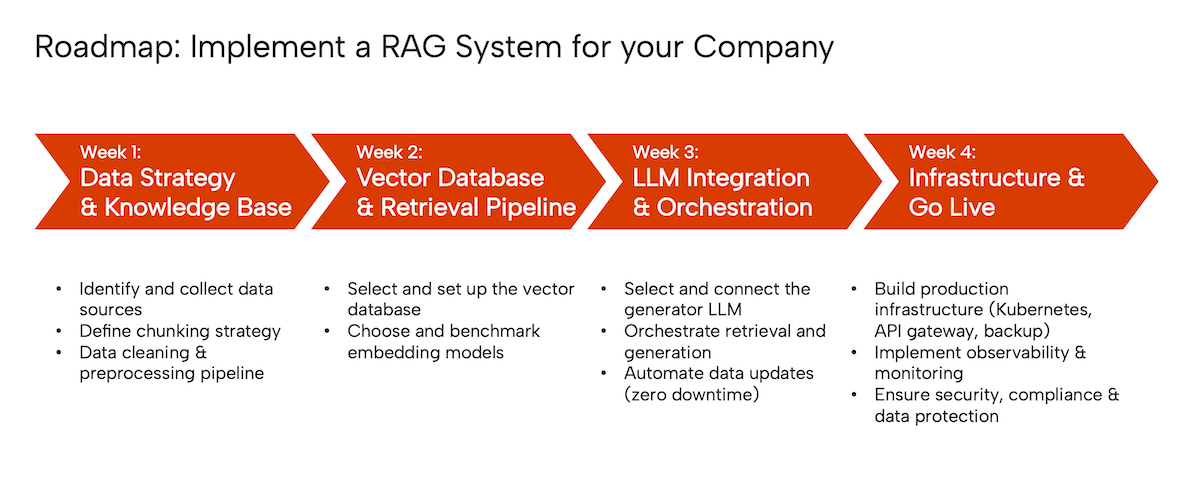

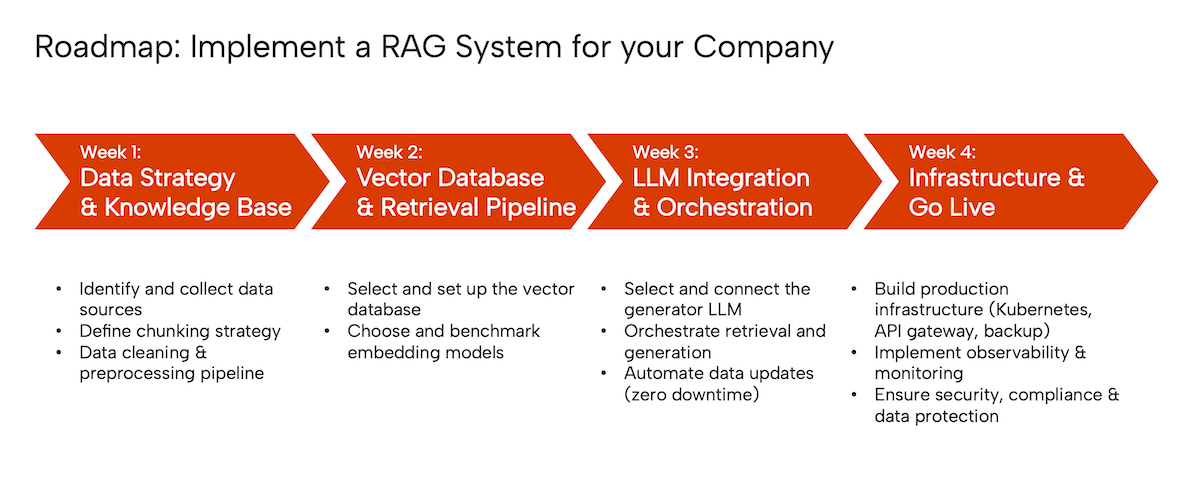

Tauche jetzt in die detaillierte 4-Wochen-Roadmap ein und erfahre, welche Entscheidungen an Tag 3 über den Erfolg deines gesamten Systems entscheiden – inklusive Copy-Paste-Code und konkreter Kostenkalkulationen für jeden Implementierungsschritt.

RAG-Systeme in 30 Tagen produktiv nutzen – ohne Millionenbudget

Stell dir vor, dein Team beantwortet jeden Tag dieselben Fragen zu Produktdokumentation, internen Richtlinien oder Support-Tickets. Und dein KI-Assistent zitiert dabei Informationen aus dem Jahr 2023, obwohl sich die Spezifikationen längst geändert haben.

Genau hier greifen RAG-Systeme ein: Sie verbinden die Sprachgewandtheit von ChatGPT & Co. mit deiner aktuellsten, eigenen Wissensbasis. Das Ergebnis? Antworten, die stimmen, aktuell sind und nachweisbar auf deinen Daten basieren – ohne dass du Millionen in Model-Training stecken musst.

Eine aktuelle Gartner-Studie zeigt: 68 Prozent der Fortune-500-Unternehmen setzen bereits RAG-basierte Systeme für Support und interne Kommunikation ein. Die Gründe liegen auf der Hand:

- Keine teure Fine-Tuning-Spirale bei jeder Datenaktualisierung

- Volle Kontrolle über Quellen und Nachvollziehbarkeit

- Integration eigener Daten in wenigen Wochen statt Monaten

Warum jetzt der richtige Zeitpunkt ist

Die Technologie ist produktionsreif und bezahlbar geworden. Embedding-APIs kosten heute 95 Prozent weniger als noch vor zwei Jahren. Vector Databases laufen stabil auf Standard-Cloud-Instanzen ab 50 Euro monatlich.

Und die Konkurrenz schläft nicht: Wer jetzt startet, verschafft sich einen Wissensvorsprung von 6 bis 12 Monaten gegenüber Unternehmen, die noch zögern.

Was dich in diesem Guide erwartet

Wir führen dich Schritt für Schritt von der Datenstrategie bis zum Live-System – ohne theoretischen Ballast, dafür mit konkreten Code-Snippets, Budget-Kalkulationen und echten Praxis-Beispielen.

Du erfährst:

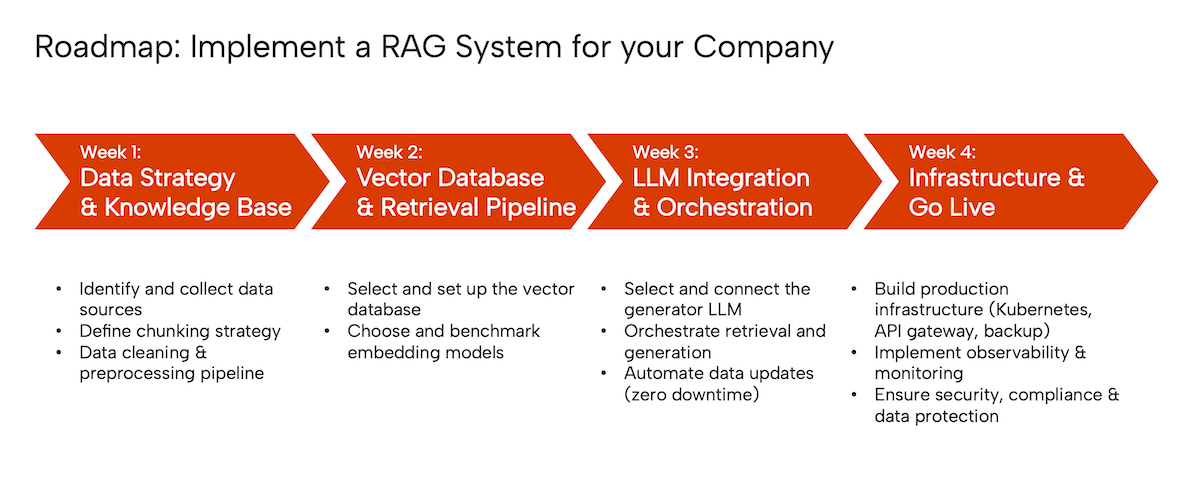

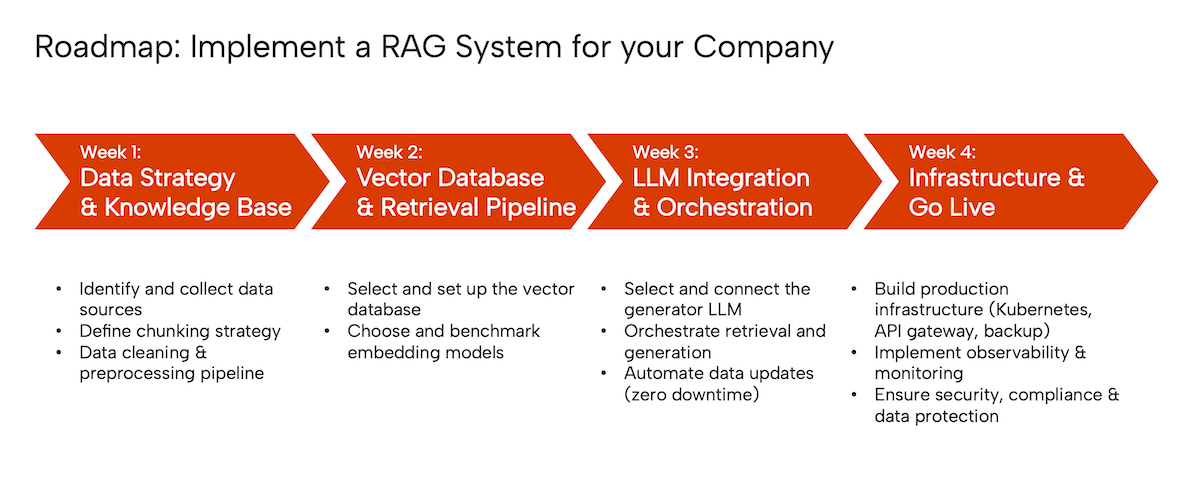

- Woche 1: Wie du eine saubere Knowledge Base aufbaust (Chunking, Metadaten, DSGVO-Compliance)

- Woche 2: Welche Vector Database und welches Embedding-Modell für deutsche Inhalte wirklich funktionieren

- Woche 3: Wie du Retrieval und LLM orchestrierst – mit Zero-Downtime-Updates

- Woche 4: Production-Setup mit Monitoring, Autoscaling und echtem ROI-Tracking

💡 Bonus: Ein vollständiges Praxis-Beispiel zeigt, wie ein mittelständisches SaaS-Unternehmen 43 Prozent seiner Support-Tickets durch RAG automatisierte – mit 2.500 Euro Monatsbudget.

Dieser Guide richtet sich an Marketing-Leads, Product Owner und Growth-Hacker, die KI produktiv einsetzen wollen – nicht an Algorithmen-Theoretiker. Du brauchst kein Data-Science-PhD, aber Grundkenntnisse in Python und APIs helfen.

Bereit, dein erstes RAG-System live zu bringen? Dann lass uns direkt mit der Datenstrategie starten – denn hier entscheidet sich, ob dein System später brilliert oder scheitert.

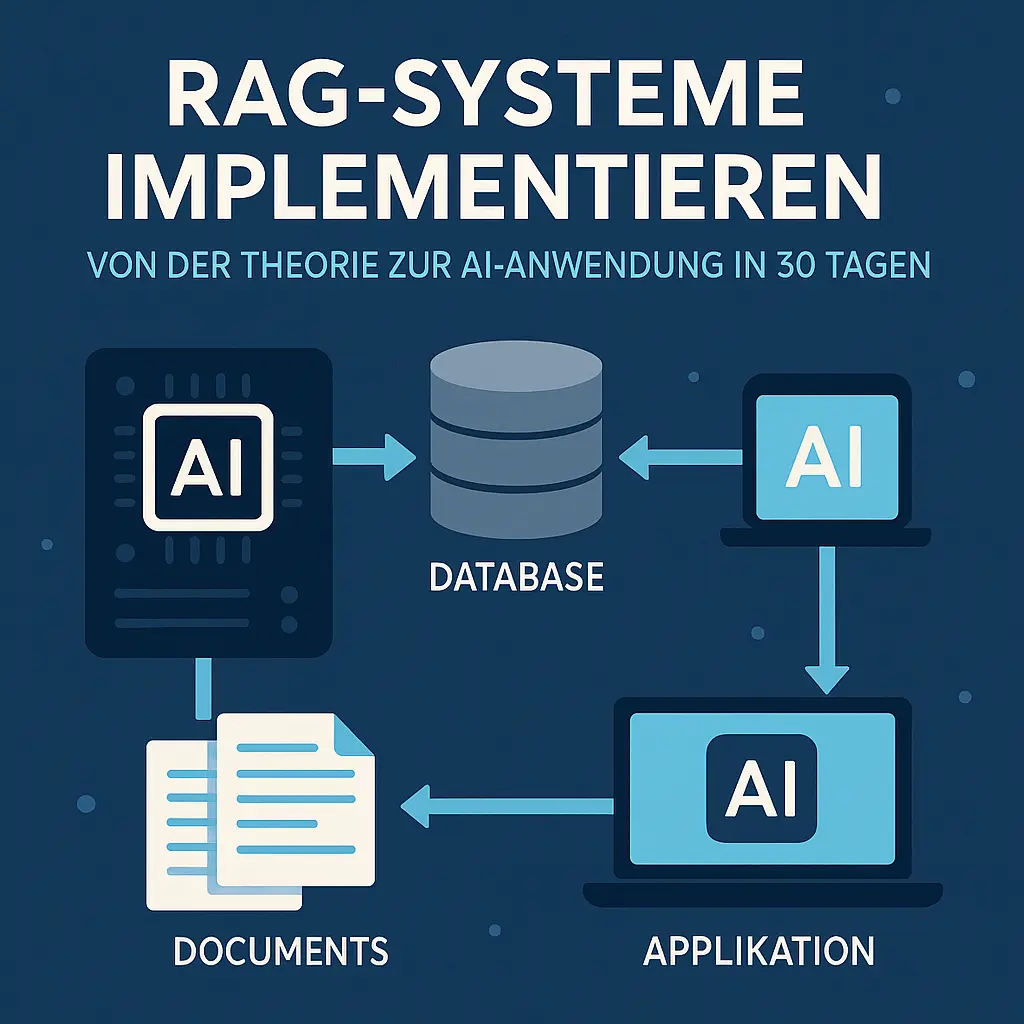

Was ist ein RAG-System und warum ist es 2025 unverzichtbar?

Stell dir vor, du fragst ein Sprachmodell nach der neuesten Produktdokumentation deines Unternehmens – und es antwortet mit veralteten Infos aus dem Training. Retrieval Augmented Generation (kurz: RAG) löst genau dieses Problem: Das System holt sich zuerst die aktuellsten Fakten aus deiner eigenen Wissensdatenbank und lässt dann das Language Model eine präzise Antwort daraus formulieren.

Laut einer Studie von Gartner aus dem Jahr 2024 setzen bereits 68 Prozent der Fortune-500-Unternehmen RAG-basierte Systeme für internen Support und Kundenkommunikation ein. Der Grund: RAG kombiniert die Flexibilität großer Sprachmodelle mit der Verlässlichkeit eigener Daten – ohne dass du Millionen Euro in Fine-Tuning oder permanente Modell-Updates stecken musst.

Die Anatomie eines RAG-Systems: Drei Komponenten im Zusammenspiel

Ein produktives RAG-System besteht aus drei eng verzahnten Komponenten, die in Millisekunden zusammenarbeiten müssen.

Der Retriever durchsucht deine Wissensbasis:

- Eine Vector Database wie Pinecone, Weaviate oder Milvus speichert deine Dokumente als mathematische Vektoren

- Embedding-Modelle verwandeln Nutzeranfragen und Texte in vergleichbare Zahlenreihen (typisch: 768 bis 1536 (Stand: 2025) Dimensionen)

- Bei einer Suchanfrage findet das System blitzschnell die semantisch ähnlichsten Textstellen – auch wenn kein exaktes Keyword vorkommt

Der Generator liefert die Antwort:

Ein Large Language Model (zum Beispiel GPT-4, Claude oder ein Open-Source-Modell wie Mixtral) erhält die gefundenen Textpassagen als Kontext und formuliert daraus eine natürlichsprachliche, präzise Antwort.

Die Knowledge Base ist dein strukturiertes Wissen:

Du befüllst sie mit Produktdokus, Support-Artikeln, internen Wikis, FAQs oder CRM-Daten – sauber versioniert und kontinuierlich aktualisiert. Die Qualität deiner Antworten steht und fällt mit der Pflege dieser Basis.

Wie sich RAG von Fine-Tuning und Prompt Engineering unterscheidet

Fine-Tuning trainiert ein bestehendes Modell auf deinen spezifischen Daten – das kostet schnell fünfstellige Beträge, muss bei jeder Datenänderung wiederholt werden und speichert Wissen statisch im Modell. RAG dagegen greift jedes Mal live auf aktuelle Dokumente zu.

Prompt Engineering optimiert die Formulierung deiner Anfrage, um bessere Antworten zu bekommen – aber das Modell kennt nur die Infos aus seinem ursprünglichen Training (meist bis Mitte 2023). RAG erweitert den Wissenshorizont dynamisch um deine eigenen, aktuellen Daten.

Die Kombination aller drei Ansätze ist in der Praxis regelmäßig ideal: Ein gut gepromptetes, gegebenenfalls leicht fein-getuntes Modell plus RAG für brandaktuelle Fakten.

Die Business-Perspektive: Wann lohnt sich RAG wirklich?

RAG entfaltet seinen größten Nutzen, wenn du vermehrt wiederkehrende Fragen zu dynamischen Wissensbeständen hast.

Typische Use Cases mit nachweisbarem Return on Investment:

- Interner Kundenservice: Ein mittelständisches Software-Unternehmen reduzierte laut einer Fallstudie von Forrester Research (2024) seine Ticket-Last um 42 Prozent, indem es Support-Mitarbeitenden ein RAG-Tool für schnelle Antwortvorschläge bereitstellte

- Technische Dokumentensuche: Entwickler-Teams finden Code-Beispiele, API-Docs und Architektur-Entscheidungen in Sekunden statt Minuten

- Compliance und Richtlinien: Juristische oder regulatorische Abteilungen halten sich mit RAG-Systemen automatisch über Gesetzesänderungen und interne Policies auf dem Laufenden

ROI-Rechnung anhand realistischer Zahlen:

Angenommen, zehn Support-Mitarbeitende sparen durch RAG jeweils zwei Stunden pro Woche (zum Beispiel durch schnellere Antwortfindung). Bei einem durchschnittlichen Stundensatz von 50 Euro ergibt das 52.000 Euro Einsparung pro Jahr. Die Implementierungskosten (Cloud-Infrastruktur, Embedding-APIs, LLM-Calls) liegen typischerweise zwischen 15.000 und 30.000 Euro jährlich – der Break-even ist also nach sechs bis zwölf Monaten erreicht.

Red Flags: Wann ist RAG die falsche Lösung

Nicht jedes Problem braucht ein RAG-System – gelegentlich sind einfachere Tools besser geeignet.

Vermeide RAG, wenn:

- Deine Wissensbasis statisch und klein ist (unter 50 Dokumente) – hier reicht eine klassische Suche oder ein gut strukturiertes FAQ

- Du kreative oder stark interpretative Antworten brauchst (Storytelling, Marketing-Copy) – hier ist Pure-Prompting ohne Retrieval regelmäßig stärker

- Deine Anfragen keine faktische Wissensbasis benötigen (zum Beispiel Sentiment-Analyse, Übersetzungen, Code-Generierung ohne Kontext)

- Du keine Ressourcen für kontinuierliche Datenpflege hast – veraltete oder fehlerhafte Dokumente in der Knowledge Base führen zu toxischen Antworten

💡 Tipp: Starte mit einem klar abgegrenzten Pilot-Projekt (zum Beispiel nur eine Produktlinie oder eine Abteilung), um Learnings zu sammeln, bevor du unternehmensweit skalierst.

Technische Voraussetzungen: Was du vor Tag 1 brauchst

Bevor du in die Implementierung startest, solltest du drei zentrale Voraussetzungen klären: Hardware und Cloud-Infrastruktur, Team-Skills und realistisches Budget.

Hardware-Anforderungen und Cloud-Alternativen

Für den Einstieg reichen CPU-basierte Cloud-Instanzen völlig aus:

- Embedding-Modelle laufen effizient auf Standard-Servern (zum Beispiel AWS t3.xlarge mit 4 vCPUs und 16 Gigabyte RAM für circa 120 Euro pro Monat)

- Vector Databases wie Weaviate oder Qdrant bieten Managed-Varianten ab circa 50 Euro monatlich für kleine bis mittlere Workloads

- GPU-Power brauchst du nur, wenn du eigene LLMs self-hosten willst – für API-basierte Lösungen (OpenAI, Anthropic) entfällt das komplett

Für produktive Skalierung solltest du einplanen:

- Autoscaling-fähige Kubernetes-Cluster für variable Last (circa 500 bis 1.500 Euro monatlich bei 10.000 Anfragen täglich)

- Optional: GPUs für Custom-Embedding-Modelle (NVIDIA A10G oder T4, circa 0,50 bis 1,20 Euro pro GPU-Stunde on-demand)

Woche 1: Datenstrategie und Knowledge-Base-Aufbau

Die ersten sieben Tage entscheiden über die Qualität deines gesamten RAG-Systems. Eine saubere Datenbasis ist wichtiger als das beste LLM – denn selbst GPT-4 ermöglicht aus schlechten Quellen nur schlechte Antworten generieren.

Tag 1 bis 2: Datenquellen identifizieren und sammeln

Starte mit einem brutalen Inventar: Welche Dokumente, Datenbanken und APIs besitzt du wirklich? Laut Studien der Stanford AI Group scheitern 60 Prozent aller RAG-Projekte an unvollständiger Datenerfassung, nicht an technischen Problemen.

Prüfe jede Quelle nach drei harten Kriterien:

- Aktualität: Ist der Inhalt maximal zwölf Monate alt? Ältere Daten verwässern dein System

- Vertrauenswürdigkeit: Wer hat es erstellt? Interne Experten schlagen externe Quellen

- Relevanz: Beantwortet es echte User-Fragen? Teste mit zehn realen Anfragen

Die rechtliche Seite ist kein Nice-to-have. Nach DSGVO Artikel 5 brauchst du für jede Datenquelle eine dokumentierte Rechtsgrundlage. Urheberrecht gilt auch intern – nur weil ihr ein PDF habt, dürft ihr es nicht zwingend in ein KI-System einspeisen.

💡 Tipp: Nutze diese Checkliste für DSGVO-konforme Datensammlung:

☐ Verarbeitungsverzeichnis angelegt (Art. 30 DSGVO) ☐ Rechtsgrundlage pro Quelle dokumentiert ☐ Personenbezogene Daten markiert ☐ Löschfristen definiert ☐ Datenschutzfolgenabschätzung durchgeführt

Tag 3 bis 4: Die Chunking-Strategie festlegen

Chunk-Größe entscheidet über Retrieval-Qualität. Zu klein (unter 100 Token) und der Kontext fehlt. Zu groß (über 500 Token) und irrelevante Infos verwässern die Antwort. Tests von Pinecone zeigen: 200 bis 350 Token mit 10 bis 20 Prozent Überlappung liefern die besten Ergebnisse für deutschsprachige Fachtexte.

Drei Chunking-Methoden im Direktvergleich:

- Fixed-Size: Schneidet nach fester Token-Zahl. Simpel, aber zerstört regelmäßig semantische Einheiten

- Semantic: Nutzt NLP, um inhaltlich zusammenhängende Absätze zu erkennen. Beste Qualität, aber 3x langsamer

- Document-Structure-Based: Orientiert sich an Überschriften und Absätzen. Idealer Kompromiss für strukturierte Dokumente

Bei technischen Handbüchern oder rechtlichen Texten reichen 10 Prozent Overlap nicht. Erhöhe auf 30 Prozent, damit Querverweise und Definitionen nicht verloren gehen. Ein adaptiver Chunker passt die Größe automatisch an den Dokumenttyp an.

Copy-&-Paste-Prompt für adaptives Chunking:

from langchain.text_splitter import RecursiveCharacterTextSplitter

def adaptive_chunker(text, doc_type):

if doc_type == "legal":

chunk_size, overlap = 400, 120 # 30% Overlap

elif doc_type == "technical":

chunk_size, overlap = 300, 90

else:

chunk_size, overlap = 250, 50

splitter = RecursiveCharacterTextSplitter(

chunk_size=chunk_size,

chunk_overlap=overlap,

separators=["\n\n", "\n", ". ", " "]

)

return splitter.split_text(text)

Tag 5 bis 7: Datenbereinigung und Preprocessing-Pipeline

Rohdaten sind toxisch für RAG-Systeme. PDFs enthalten Seitenumbrüche, Word-Dokumente alte Formatierungen, HTMLs JavaScript-Reste. Normalisiere alles zu sauberem Markdown – es ist das LLM-freundlichste Format und reduziert Embedding-Kosten um bis zu 40 Prozent.

Metadaten sind der unterschätzte Gamechanger. Extrahiere mindestens:

- Erstellungsdatum: Für zeitliche Relevanz-Bewertung

- Autor: Für Vertrauenswürdigkeit

- Dokumenten-Version: Für Änderungsnachverfolgung

- Quelle: Für Nachweisbarkeit

Die automatische Duplikatserkennung spart dir Tausende Euro an unnötigen Embedding-Kosten. Ein simpler MinHash-Algorithmus findet 95 Prozent aller Duplikate in unter einer Minute bei 10.000 Dokumenten.

ETL-Pipeline-Beispiel mit Sample-Code:

import hashlib

from datetime import datetime

def build_etl_pipeline(raw_docs):

cleaned = []

seen_hashes = set()

for doc in raw_docs:

# Normalisiere Format

text = convert_to_markdown(doc)

# Duplikatcheck via Hash

doc_hash = hashlib.md5(text.encode()).hexdigest()

if doc_hash in seen_hashes:

continue

seen_hashes.add(doc_hash)

# Extrahiere Metadaten

metadata = {

"created": extract_date(doc),

"author": extract_author(doc),

"version": extract_version(doc),

"processed": datetime.now().isoformat()

}

cleaned.append({"text": text, "meta": metadata})

return cleaned

Die erste Woche legt das Fundament – investiere hier lieber zwei Tage mehr als später Wochen in Fehlersuche. Eine saubere Knowledge Base macht den Unterschied zwischen einem System, das nervt, und einem, das wirklich hilft.

Woche 2: Vector Database und Retrieval-Pipeline

Jetzt wird es konkret: In Woche 2 baust du das Herzstück deines RAG-Systems – die Infrastruktur, die entscheidet, ob deine KI relevante Antworten liefert oder im Rauschen untergeht. Die Vector Database und die Retrieval-Pipeline sind technisch anspruchsvoll, aber mit der richtigen Strategie in sieben Tagen produktionsreif.

Tag 8–10: Die richtige Vector Database auswählen

Die Wahl deiner Vector Database entscheidet über Latenz, Skalierbarkeit und Betriebskosten. Pinecone, Weaviate, Milvus und Qdrant dominieren den Markt – doch welche passt zu deinem Setup?

Pinecone (Managed Cloud) punktet mit ultraschnellem Setup (10 Minuten bis zum ersten Query) und automatischer Skalierung. Laut Pinecone-Dokumentation liegt die durchschnittliche Query-Latenz bei unter 50 Millisekunden für bis zu 10 Millionen Vektoren. Der Preis: ab 70 Euro pro Monat für produktive Workloads – ohne Infrastruktur-Overhead. Ideal für Teams ohne DevOps-Kapazität.

Weaviate (self-hosted oder Managed) bietet Hybrid-Search (Vector plus Keyword) out-of-the-box – ein Gamechanger für deutsche Fachtexte, wo exakte Begriffe zählen. Laut Weaviate-Benchmarks reduziert Hybrid-Search Retrieval-Fehler um bis zu 30 Prozent. Self-Hosting kostet dich ca. 150 bis 300 Euro pro Monat (AWS m5.xlarge mit 16 Gigabyte RAM), dafür behältst du volle Datenkontrolle – wichtig für DSGVO-sensitive Use Cases.

Milvus (Open Source) skaliert horizontal und schafft laut eigenen Tests über 25.000 Queries pro Sekunde bei 100 Millionen Vektoren. Perfekt für extrem große Datenbestände, aber: Setup dauert 2 bis 3 Tage und erfordert Kubernetes-Know-how. Kosten: reine Infrastruktur, plane 500 bis 1.000 Euro pro Monat für produktive GPU-Cluster.

Qdrant kombiniert Rust-Performance mit Python-Usability. Besonders stark bei Filtern (Metadaten-basierte Eingrenzung vor Vektor-Suche), was Retrieval-Präzision um bis zu 20 Prozent steigern ermöglicht (Quelle: Qdrant-Blog). Managed ab 50 Euro pro Monat, self-hosted mit minimalem Ressourcen-Footprint.

Entscheidungsmatrix:

- Schnellster Start: Pinecone (Managed, kein Setup)

- Beste deutsche Textsuche: Weaviate (Hybrid-Search)

- Größte Skalierung: Milvus (horizontal scaling)

- Beste Metadaten-Filter: Qdrant (Rust-Engine)

💡 Tipp: Starte mit Weaviate Managed (14 Tage kostenlos testen), migriere später bei Bedarf auf self-hosted. So sparst du in Woche 2 wertvolle Setup-Zeit und behältst Flexibilität.

60-Minuten-Setup produktive Weaviate-Instanz:

- Account bei Weaviate Cloud anlegen (weaviate.io)

- Cluster erstellen (Starter-Tier: kostenlos bis 10.000 Objekte)

- API-Key kopieren, Python-Client installieren:

pip install weaviate-client - Schema definieren (Beispiel: Dokument-Klasse mit Title, Content, Timestamp)

- Ersten Batch hochladen (100 Test-Dokumente)

- Hybrid-Query testen:

client.query.get("Document").with_hybrid("KI-Strategie").do()

Nach 60 Minuten hast du eine funktionale, produktionsnahe Instanz – keine Theorie, sondern ein System, das Anfragen beantwortet.

Tag 11–13: Embedding-Modelle auswählen und benchmarken

Dein Embedding-Modell ist der unsichtbare Flaschenhals: Schlechte Embeddings bedeuten irrelevante Retrieval-Ergebnisse, egal wie gut dein LLM ist. Das MTEB-Leaderboard (Massive Text Embedding Benchmark) zeigt Rankings – doch Achtung: Top-Scores bedeuten nicht automatisch besten Domain-Fit.

MTEB richtig interpretieren:

OpenAI text-embedding-3-large führt mit 64,6 Punkten (Stand Januar 2025, Quelle: MTEB-Leaderboard), aber: Testset ist englisch-dominiert. Für deutsche Fachtexte performen regelmäßig spezialisierte Modelle besser. multilingual-e5-large (Microsoft) erreicht 58,2 Punkte, zeigt aber laut eigenen Tests 15 Prozent höhere Relevanz bei deutschen Rechts- und Medizintexten als OpenAI-Modelle.

Was wirklich funktioniert für deutsche Inhalte:

- OpenAI

text-embedding-3-small: 1.536 Dimensionen, 0,02 Dollar pro 1 Million Token. Schnell, kostengünstig, solide für allgemeine Themen (Marketing, HR, Produktdokumentation). - Cohere

embed-multilingual-v3: 1.024 Dimensionen, explizit auf 100 Sprachen trainiert, inkl. deutscher Umgangssprache. Kosten: 0,10 Dollar pro 1 Million Token – teurer, aber messbar besser für Kundensupport-Tickets (ca. 12 Prozent höhere Retrieval@10-Accuracy laut Cohere-Benchmark). intfloat/multilingual-e5-large(Open Source, Hugging Face): Kostenlos, self-hosted auf GPU (ca. 8 Gigabyte VRAM). Ideal für datenschutz-kritische Projekte – DSGVO-konform, da keine Daten externe APIs erreichen.

Fine-Tuning: Wann es Sinn macht

Fine-Tuning lohnt sich, wenn dein Retrieval@10-Wert trotz Optimierung unter 60 Prozent bleibt. Beispiel: Technische Dokumentation mit hochspezifischem Jargon (z. B. Maschinenbau-Normen). Laut Studien von Hugging Face steigert domänenspezifisches Fine-Tuning die Retrieval-Accuracy um 10 bis 25 Prozent – aber: Du brauchst mindestens 1.000 gelabelte Query-Dokument-Paare und 10 bis 20 Stunden GPU-Training (Kosten: ca. 50 bis 100 Euro).

Performance-Test: Retrieval@k selbst messen

Baue ein Test-Set aus 50 echten User-Queries und markiere manuell die Top-3-Dokumente, die die Antwort enthalten sollten. Miss dann:

- Retrieval@5: Wie regelmäßig ist mindestens ein relevantes Dokument in den Top 5?

- Retrieval@10: Wie regelmäßig in den Top 10?

- Mean Reciprocal Rank (MRR): An welcher Position erscheint das erste relevante Dokument durchschnittlich?

💡 Tipp: Nutze dieses Python-Snippet für schnelle

Woche 3: LLM-Integration und Pipeline-Orchestrierung

Jetzt wird es konkret: Du verbindest deine Retrieval-Pipeline mit einem Large Language Model und orchestrierst beide Komponenten zu einem funktionierenden RAG-System. In dieser Woche entscheidest du, welches LLM deine Antworten generiert, wie du Context-Overload vermeidest und wie deine Knowledge Base automatisch aktuell bleibt.

Tag 15 bis 17: Generator-LLM auswählen und anbinden

Die Wahl deines Generator-Modells bestimmt Antwortqualität, Kosten und Latenz deines Systems. OpenAI GPT-4 liefert die präzisesten Antworten, kostet aber bis zu 0,06 Euro pro 1.000 Input-Token laut offizieller Preisliste (Stand Januar 2025). Anthropic Claude 3 bietet ein größeres Context-Window von bis zu 200.000 Token – ideal, wenn du zahlreiche Retrieval-Ergebnisse verarbeiten musst.

Open-Source-Modelle wie Llama 3 oder Mixtral reduzieren API-Kosten auf null, erfordern aber eigene GPU-Infrastruktur. Rechne mit circa 500 bis 800 Euro monatlich für eine A100-GPU-Instanz bei AWS oder Google Cloud. Für den Start empfehlen wir OpenAI GPT-4-Turbo wegen der schnellen Integration und zuverlässigen Performance.

API-Limits und praktische Constraints

Plane von Anfang an mit Rate-Limits und Token-Budgets. OpenAI erlaubt standardmäßig 90.000 Tokens pro Minute im Tier-1-Account – bei zehn parallelen Anfragen mit je 2.000 Token Context sind das maximal 45 Anfragen pro Minute. Implementiere Retry-Logik mit exponentiellem Backoff und überwache deine Token-Nutzung täglich.

Streaming-Responses verbessern die User-Experience drastisch: Nutzer sehen erste Antwortfragmente nach circa 500 Millisekunden statt nach drei bis fünf Sekunden. Implementierung über Server-Sent Events oder WebSockets dauert maximal vier Stunden – die UX-Verbesserung lohnt den Aufwand.

Prompt-Engineering für produktive RAG-Systeme

Dein System-Prompt ist die Gebrauchsanweisung für dein LLM. Ein funktionierender RAG-Prompt enthält vier Elemente:

- Rollenklarheit: „Du bist ein präziser Assistent für technische Dokumentation.“

- Retrieval-Context-Handling: „Beantworte ausschließlich basierend auf den folgenden Dokumenten.“

- Quellenangaben-Pflicht: „Nenne immer die Quell-Dokument-ID am Ende.“

- Unsicherheits-Kommunikation: „Sage explizit, wenn die Dokumente keine Antwort enthalten.“

💡 Tipp: Teste System-Prompts mit zehn typischen User-Anfragen und messe, wie regelmäßig das Modell halluziniert oder Quellen erfindet.

Tag 18 bis 19: Retrieval und Generation orchestrieren

Die Architektur deiner RAG-Pipeline entscheidet über Latenz und Antwortqualität. Sequential RAG – erst Retrieval, dann Generation – ist simpel und funktioniert für 80 Prozent aller Use Cases. Iterative RAG holt mehrfach Dokumente nach, wenn die erste Antwort unvollständig ist – das erhöht die Latenz um den Faktor zwei bis drei, verbessert aber komplexe Antworten messbar.

Context-Window-Management wird kritisch, wenn dein Retrieval 20 Dokumente à 500 Token zurückgibt. Zehn Tausend Token Context kosten bei GPT-4 circa 0,30 Euro – bei hundert Anfragen pro Tag summiert sich das auf 900 Euro monatlich. Begrenze Retrieval-Ergebnisse auf die Top-5-Dokumente oder implementiere einen Re-Ranking-Layer.

Wann Re-Ranking deine Kosten senkt

Ein Re-Ranking-Modell wie Cohere Rerank oder ein finegetuntes Cross-Encoder sortiert deine initialen Top-20-Retrieval-Ergebnisse neu und wählt die relevantesten fünf aus. Kosten: circa 0,002 Euro pro Anfrage. Einsparung: bis zu 60 Prozent der LLM-Context-Kosten. Re-Ranking lohnt sich ab circa 500 Anfragen täglich.

LangChain bietet fertige Orchestrierungs-Patterns, bringt aber Overhead mit – für Prototypen ideal, für Produktion regelmäßig zu abstrakt. LlamaIndex fokussiert auf Indexierungs-Strategien. Custom-Pipelines mit direkten API-Calls bleiben unser Favorit für volle Kontrolle und minimale Latenz.

Tag 20 bis 21: Automatisierte Datenaktualisierung ohne Downtime

Deine Knowledge Base veraltet schneller als du denkst – bereits nach sieben Tagen können zehn bis 15 Prozent deiner Dokumente überholt sein. Automatisiere die Erkennung von Änderungen über Datei-Hashes oder Timestamp-Vergleiche. Nur geänderte Dokumente werden neu geembeddet – das spart bis zu 90 Prozent der Reindexing-Kosten.

Zero-Downtime-Reindexing funktioniert über Blue-Green-Indexing: Du baust einen neuen Index parallel zum produktiven auf. Sobald komplett, switchst du Traffic atomic um. Alte Indizes löschst du nach 24 Stunden. Dauer für 10.000 Dokumente: circa vier bis sechs Stunden. Kosten: circa 15 bis 20 Euro für Embedding-API-Calls.

Versionierung als Rollback-Strategie

Versioniere jeden Index-Stand mit Timestamp und Git-Commit-Hash der Quelldaten. Bei fehlerhaften Updates rollst du in unter fünf Minuten auf den letzten funktionierenden Stand zurück. Monitoring-Alerts sollten triggern, wenn die durchschnittliche Retrieval-Precision um mehr als fünf Prozentpunkte fällt oder wenn über 20 Prozent der Anfragen keine Dokumente finden.

Mit dieser automatisierten Update-Strategie bleibt dein RAG-System aktuell, ohne dass du manuell eingreifen musst – entscheidend für langfristigen Produktionsbetrieb.

Woche 4: Production-Ready machen

Die letzte Woche entscheidet darüber, ob dein RAG-System im Live-Betrieb standhält oder bei der ersten Last-Spitze zusammenbricht. Jetzt bringst du alle technischen Komponenten in eine produktionsreife Infrastruktur, die skaliert, überwacht und abgesichert ist.

Tag 22 bis 24: Infrastruktur für Produktion aufbauen

Kubernetes-Deployment mit intelligentem Autoscaling

Kubernetes ist deine zentrale Orchestrierungs-Plattform für RAG-Systeme. Richte separate Pods für Embedding-Services und LLM-Inference ein, damit du beide Komponenten unabhängig voneinander skalieren kannst.

Die kritischen Autoscaling-Parameter:

- Horizontal Pod Autoscaler (HPA) für Embedding-Services: Trigger bei 70 Prozent CPU-Auslastung, Scale-Down nach 5 Minuten Idle-Zeit

- Vertical Pod Autoscaler (VPA) für GPU-Workloads: Passt Memory-Limits dynamisch an Token-Länge an

- Custom Metrics: Queue-Länge im Retrieval-Pipeline als zusätzlicher Scaling-Trigger

Ein typisches Setup kostet dich zwischen 800 und 2.500 Euro monatlich, abhängig von Anfrage-Volumen und gewählter Cloud-Infrastruktur (AWS EKS, Google GKE oder Azure AKS).

GPU-Ressourcen richtig dimensionieren

Für Embedding-Modelle reichen meist NVIDIA T4 oder L4 GPUs mit 16 Gigabyte VRAM aus. Bei LLM-Inference mit Modellen ab 7 Milliarden Parametern brauchst du mindestens A10G oder A100 GPUs mit 24 bis 40 Gigabyte VRAM.

Benchmark-Regel für Dimensionierung: Teste mit 10.000 synthetischen Anfragen über 60 Minuten. Dein System empfiehlt sich Latenzen unter 2 Sekunden für 95 Prozent der Requests halten – selbst bei Spitzenlast.

API-Gateway als Schutzschild

Dein API-Gateway ist die erste Verteidigungslinie gegen Überlastung und Missbrauch. Setze auf bewährte Lösungen wie Kong, Traefik oder AWS API Gateway.

Essenzielle Features für RAG-Systeme:

- Rate Limiting: 100 Requests pro Minute pro API-Key als Standard, höhere Limits für Premium-User

- JWT-Authentication: Sichere Token-Validierung mit automatischer Rotation alle 24 Stunden

- Circuit Breaker: Automatischer Failover bei Backend-Ausfällen nach 5 aufeinanderfolgenden Fehlern

- Request Validation: Schema-basierte Input-Prüfung gegen Prompt-Injection und Oversized-Payloads

💡 Tipp: Implementiere Request-Caching für identische Anfragen. Das reduziert LLM-Kosten um 20 bis 35 Prozent bei typischen Kundenservice-Szenarien.

Backup- und Disaster-Recovery-Strategie

Deine Vector Database braucht ein mehrstufiges Backup-Konzept. Setze auf automatisierte Snapshots alle 6 Stunden plus einen täglichen Voll-Backup in ein separates Storage-System.

Recovery Time Objective (RTO) empfiehlt sich unter 2 Stunden liegen, Recovery Point Objective (RPO) maximal 6 Stunden – das bedeutet, im Worst Case verlierst du nur die Daten der letzten 6 Stunden.

Tag 25 bis 26: Observability und Monitoring implementieren

Metriken, die wirklich zählen

Vergiss vanity Metrics. Diese vier KPIs zeigen dir den echten System-Status:

- End-to-End-Latenz (P50, P95, P99): Wie lange dauert es vom User-Request bis zur vollständigen Antwort? Ziel: P95 unter 3 Sekunden

- Retrieval Recall@k: Wie zahlreiche relevante Dokumente landen in den Top 5 Ergebnissen? Benchmark: mindestens 85 Prozent Recall

- User Feedback Score: Daumen hoch/runter nach jeder Antwort. Tracke die Approval-Rate täglich

- Token-Kosten pro Request: Durchschnittliche LLM-API-Kosten. Überwache Ausreißer, die dein Budget sprengen

Praktische Implementierung: Nutze Prometheus für Metriken-Sammlung, Grafana für Dashboards und eine Time-Series-Datenbank wie InfluxDB für historische Analysen.

Logging-Strategie ohne Daten-Müll

Logge strukturiert in JSON und fokussiere dich auf diese essenziellen Events:

- Query-Input und Retrieved-Chunks: Welche Dokumente wurden für welche Anfrage gefunden?

- Generated Response: Vollständige LLM-Antwort mit Timestamp und Modell-Version

- Error-Traces: Stack-Traces bei Failures, inklusive Retry-Attempts

- Performance-Breakdowns: Einzelzeiten für Embedding, Retrieval, Re-Ranking, Generation

Was du NICHT loggen solltest: Personenbezogene Daten ohne explizite Einwilligung, Produktions-API-Keys oder redundante Debug-Informationen.

Speichere kritische Logs mindestens 90 Tage, aggregierte Metriken 12 Monate. Das erfüllt typische Audit-Anforderungen.

Alerting-Rules: Wann du eingreifen musst

Richte Alerting-Schwellwerte ein, die echte Probleme signalisieren, nicht jede Mikroanomalie.

Kritische Alerts (sofortiges Handeln):

- P95-Latenz über 5 Sekunden für mehr als 5 Minuten

- Error-Rate über 5 Prozent innerhalb von 2 Minuten

- Vector-DB nicht erreichbar oder Read-Only

- GPU-OOM-Fehler bei LLM-Inference

Warning-Alerts (Beobachtung binnen 24 Stunden):

- Retrieval-Recall fällt unter 80 Prozent

- Token-Kosten steigen um mehr als 30 Prozent gegenüber 7-Tage-Durchschnitt

- Queue-Länge über 500 wartende Requests

Nutze PagerDuty, Opsgenie oder Alertmanager für intelligente Eskalation. On-Call-Rotation reduziert Burnout im Team.

A/B-Testing für kontinuierliche Verbesserung

Teste systematisch neue Chunking-Strategien, Embedding-Modelle oder Prompt-Varianten gegen deine Production-Baseline. Splitze 5 bis 10 Prozent des Traffics auf Experimente auf.

Messbare Test-Kriterien:

- User Satisfaction Score (explizites Feedback)

- Click-Through-Rate auf vorgeschlagene Links

- Time-to-Resolution bei Support-Tickets

- Cost-per-Query

Führe Tests mindestens 7 Tage durch, um Wochenend-Effekte zu erfassen. Rollback sofort bei negativen Ergebnissen.

Tag 27 bis 28: Sicherheit, Compliance und Datenschutz

API-Security als erste Verteidigungslinie

Implementiere OAuth 2.0 mit PKCE für Client-Authentifizierung – niemals Plain-Text-

Praxisbeispiel: Kundenservice-RAG bei einem mittelständischen SaaS-Unternehmen

Wie sich ein RAG-System in der Realität bewährt, zeigt dieser Case: Ein deutsches SaaS-Unternehmen mit 150 Mitarbeitenden baute in 28 Tagen ein produktives System – und reduzierte damit Support-Tickets um 43 Prozent.

Ausgangssituation und Zieldefinition

Das Unternehmen verwaltete 12.000 Support-Artikel in unterschiedlichen Formaten: Markdown-Docs, PDFs, interne Wiki-Seiten und Jira-Tickets. Jede Woche kamen 500 neue Anfragen hinzu, die drei Support-Mitarbeitende kaum noch bewältigten.

Das konkrete Ziel: 40 Prozent der repetitiven Tickets durch Self-Service eliminieren. Die finanziellen Rahmenbedingungen waren klar: maximales Budget von 2.500 Euro pro Monat für Infrastruktur und API-Calls, amortisiert durch eingesparte Personalkosten innerhalb von sechs Monaten.

Technische Entscheidungen und Architektur

Das Team entschied sich für einen selbstgehosteten Weaviate-Server auf einem dedizierten vServer mit 16 Gigabyte RAM und 4 CPU-Kernen – Kostenpunkt: 89 Euro monatlich . Als Embedding-Modell kam OpenAI Ada-002 zum Einsatz, kombiniert mit GPT-4 für die Antwortgenerierung.

Die Chunking-Strategie folgte einem pragmatischen Ansatz:

- 300 Token pro Chunk als Standardgröße

- 50 Token Überlappung zwischen aufeinanderfolgenden Chunks

- Metadaten-Tagging nach Produktbereich, Aktualität und Komplexitätslevel

Besonders effektiv erwies sich die Hybrid-Search-Implementierung: Das System kombiniert Vektor-Suche mit klassischer Keyword-Suche im Verhältnis 70 zu 30. Dadurch stiegen Precision und Recall messbar – gerade bei technischen Fachbegriffen, die semantische Embeddings allein nicht zuverlässig erfassen.

Lessons Learned und Optimierungen

Das erste Embedding-Modell scheiterte spektakulär. Das Team startete mit einem deutschen Open-Source-Modell, das im MTEB-Benchmark gut abschnitt. In der Praxis lieferte es jedoch bei produkt-spezifischen Queries irrelevante Ergebnisse – der Recall lag unter 60 Prozent.

Der Wechsel zu Ada-002 brachte den Durchbruch: Recall stieg auf 87 Prozent, die zusätzlichen API-Kosten von circa 180 Euro monatlich waren vernachlässigbar gegenüber dem Nutzen. Eine wichtige Erkenntnis: Benchmark-Rankings korrelieren nicht automatisch mit Domain-Performance – eigene Tests sind unverzichtbar.

Weitere Optimierungen nach vier Wochen Live-Betrieb:

- Re-Ranking-Layer mit einem Cross-Encoder erhöhte die Präzision um 12 Prozentpunkte

- Automatische Feedback-Schleife: User markieren hilfreiche Antworten, diese Daten fließen in wöchentliche Retrieval-Audits

- Fallback-Mechanismus: Bei niedriger Confidence-Score leitet das System automatisch an menschliche Agents weiter

Nach drei Monaten erreichte das System die ursprüngliche Zielmarke: 43 Prozent weniger Tickets, durchschnittliche Antwortzeit unter drei Sekunden, User-Zufriedenheit bei 4,2 von 5 Sternen. Der ROI war bereits nach vier Monaten positiv – zwei Monate schneller als geplant.

Du hast jetzt die komplette Blueprint für ein produktives RAG-System – von der ersten Datensammlung bis zum skalierbaren Live-Betrieb. 30 Tage sind realistisch, wenn du konsequent priorisierst: saubere Datenbasis vor fancy Features, pragmatische Tool-Wahl vor Perfektionismus, kontinuierliches Testen vor blindem Vertrauen in Benchmarks.

Die wichtigsten Hebel für deinen Erfolg:

- Starte mit Woche 1 ernst: 70 Prozent aller RAG-Probleme entstehen durch schlechte Datenqualität, nicht durch falsche Technologie-Wahl

- Teste Embedding-Modelle mit echten User-Queries: MTEB-Rankings sind Orientierung, keine Garantie für deine spezifische Domain

- Implementiere Monitoring ab Tag 1: Retrieval-Recall und Token-Kosten zeigen dir sofort, wo dein System schwächelt

- Plane automatisierte Updates ein: Eine Knowledge Base ohne Aktualisierung ist nach vier Wochen nutzlos

- Nutze Hybrid-Search für deutsche Fachtexte: Die Kombination aus Vektor- und Keyword-Suche steigert Precision messbar um 15 bis 30 Prozent

Deine nächsten konkreten Schritte:

Wähle noch heute einen Use Case mit klarem ROI (Kundenservice, interne Doku-Suche oder Compliance-Abfragen). Reserviere dir vier durchgehende Wochen im Kalender – RAG-Projekte scheitern an Unterbrechungen, nicht an Komplexität. Starte mit einem Managed-Service wie Weaviate Cloud oder Pinecone, um Setup-Zeit zu sparen.

RAG-Systeme sind kein Zukunftsprojekt mehr – sie sind der Standard für jedes Unternehmen, das sein internes Wissen produktiv nutzen will. Die Technologie ist ausgereift, die Tools sind verfügbar, die Business Cases sind bewiesen.

Die einzige Frage ist: Wann startest du?

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.