Multiverse Computing sichert sich 215 Millionen Dollar für Durchbruch in der KI-Komprimierung – Sprachmodelle werden um 95% verkleinert bei minimalen Leistungsverlusten.

Das spanische Startup Multiverse Computing hat in einer Series-B-Finanzierungsrunde 189 Millionen Euro (215 Millionen Dollar) eingesammelt, um seine CompactifAI-Technologie zu skalieren. Die Finanzierung wurde von Bullhound Capital angeführt, mit Beteiligung von HP Tech Ventures, Toshiba und weiteren Investoren. Die Bewertung des Unternehmens stieg dabei auf über 500 Millionen Dollar – eine Verfünffachung gegenüber der Series-A-Runde von 2024.

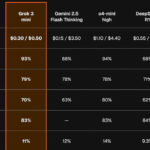

Die quantum-inspirierte Kompressionstechnologie CompactifAI reduziert große Sprachmodelle (LLMs) um bis zu 95% ihrer ursprünglichen Größe, während die Leistung nahezu vollständig erhalten bleibt. Im Gegensatz zu herkömmlichen Methoden, die oft 20-30% Genauigkeitsverlust bei 50-60% Komprimierung verursachen, erreicht CompactifAI eine 93%ige Größenreduktion mit nur 2-3% Präzisionsverlust.

Die Kosteneinsparungen sind erheblich: Inferenzkosten sinken um 50-80% und die Verarbeitungsgeschwindigkeit steigt um das 4-12fache. Multiverse’s komprimierte Llama 3.3-70B Slim Version behält 97% der ursprünglichen Modellgenauigkeit bei 60% weniger Parametern und 84% geringerem Energieverbrauch.

Quantum-inspirierte Tensor-Netzwerke als Schlüsseltechnologie

Die proprietäre Technologie nutzt Tensor-Netzwerke aus der Quantenphysik, um redundante Parameter in LLMs zu identifizieren und zu entfernen. Diese Methode zerlegt Gewichtsmatrizen in optimierte Tensorstrukturen und beschneidet unnötige Korrelationen. Nach der Komprimierung durchlaufen die Modelle ein Retraining, um verlorene Leistung zurückzugewinnen.

Die Technologie ermöglicht es, dass komprimierte Modelle wie Mistral Small 3.1 Slim auf Edge-Geräten wie Smartphones, Raspberry Pi-Boards und Drohnen laufen können. Ein Raspberry Pi 5 erreicht beispielsweise 5,13 Token pro Sekunde mit einem komprimierten phi-2-Q4-Modell – vergleichbar mit der Leistung auf leistungsstärkerer Hardware.

Strategische Investoren und Marktpositionierung

Bullhound Capital führte die Finanzierungsrunde an und bringt Erfahrung aus erfolgreichen Investments in Spotify und Revolut mit. HP Tech Ventures‘ Beteiligung signalisiert strategisches Interesse an der Einbettung effizienter KI in HPs Hypermobilität- und IoT-Bereiche. Toshibas Engagement unterstreicht die industriellen Anwendungsmöglichkeiten in Energie und Fertigung.

Mit 160 Patenten und über 100 globalen Kunden hat sich Multiverse von seinen Ursprüngen im Quantencomputing für das Finanzwesen zu einem Marktführer in der KI-Optimierung entwickelt. Der Umsatz verdoppelt sich jährlich, angetrieben durch Lizenzgebühren und eine neue AWS-Partnerschaft, die API-Zugang zu komprimierten Modellen bietet.

Zusammenfassung

- Multiverse Computing sammelt 215 Millionen Dollar in Series-B-Runde ein, Bewertung steigt auf über 500 Millionen Dollar

- CompactifAI-Technologie reduziert LLMs um 95% bei nur 2-3% Genauigkeitsverlust

- Quantum-inspirierte Tensor-Netzwerke ermöglichen effiziente Modellkomprimierung

- Inferenzkosten sinken um 50-80%, Verarbeitungsgeschwindigkeit steigt um das 4-12fache

- Komprimierte Modelle laufen auf Edge-Geräten wie Smartphones und Raspberry Pi

- Bullhound Capital führt Finanzierungsrunde an, HP Tech Ventures und Toshiba beteiligen sich

- Über 100 globale Kunden nutzen bereits die Technologie, darunter Iberdrola und Bosch

- AWS-Partnerschaft bietet API-Zugang zu komprimierten Modellen

Quelle: TechChrunch

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.