Deepseek ist ein leistungsstarkes Open-Source-Sprachmodell, das sich für Recherche, Codegenerierung und viele weitere KI-Anwendungen eignet. Mit Ollama kannst du Deepseek ganz einfach lokal auf deinem Rechner ausführen – ohne auf eine Cloud-Anbindung angewiesen zu sein. In diesem Artikel erfährst du, wie du Deepseek mit Ollama installierst, konfigurierst und sicher nutzt.

Was ist Deepseek?

Deepseek ist ein modernes Large Language Model (LLM), das speziell für hohe Leistungsfähigkeit und Effizienz optimiert wurde. Das Modell DeepSeek R1 wurde im Januar 2025 veröffentlicht und erregte internationale Aufmerksamkeit, da es vergleichbar gut wie das aktuell stärkste Modell OpenAI GPT-o1 ist und zudem kostenlos als Open Source verfügbar ist und zu einem Bruchteil der Kosten erstellt wurde.

Deepseek R1 eignet sich für viele typische Anwendungsfälle wie:

- Automatisierte Texterstellung und Textanalysen

- Erstellung von Code und technischen Dokumentationen

- Recherche und Zusammenfassungen großer Datenmengen

- Chatbot-Entwicklung

Welche Vorteile bietet Deepseek gegenüber anderen KI-Modellen und Tools?

Deepseek R1 bietet durch die lokale Nutzbarkeit auf dem eigenen Rechner oder Server die Chance, ein mächtiges KI-Modell ähnlich wie GPT-o1 einsetzen zu können ohne Daten an US-Unternehmen oder weitere Organisationen weiterzugeben und zudem volle Kontrolle über Daten und das KI-System zu haben. Dies ist besonders für Firmen interessant, die auf Datenschutz und Governance sowie eine hohe Verfügbarkeit des Systems und Unabhägigkeit von externen IT-Services achten müssen.

Wie kann man Deepseek R1 mit Ollama auf dem eigenen Server nutzen?

Ollama ist ein Tool für Windows, MacOS und Linux. Es ermöglicht, moderne OpenSource KI-Modelle direkt auf dem eigenen Rechner auszuführen. Die Vorteile von Ollama in Kombination mit Deepseek:

- Lokale Ausführung: Keine Daten verlassen den eigenen Rechner.

- Einfache Installation: Ollama macht das Setup von Deepseek unkompliziert.

- Bessere Kontrolle: Anpassungen und Optimierungen sind direkt auf dem eigenen System möglich.

Somit kann man die grundlegende Deepseek-Modell einfach testen und nutzen.

Welche Anforderungen braucht Deepseek R1 auf dem eigenen Rechner?

Beim Einsatz von Deepseek auf einem eigenen Server sind Grenzen durch die Hardware des Rechners gesetzt. Das Modell Deepseek R1 gibt es darum in mehreren Versionen, von klein bis groß. Je nachdem, wie leistungsstark der Rechner ist, kann man ein größeres Modell wählen:

Parameter des Deepseek-Modells:

Deepseek R1 ist aktuell verfügbar in den Parameter-Versionen 1.5b, 7b, 8b, 14b, 32b, 70b und 671b. Lesebeispiel: Das Modell „Deepeek R1 8b“ basiert auf 8 Milliarden (billion) Parametern. Die Parameteranzahl kann man sich grob vorstellen als die Anzahl der Neuronen im „Gehirn der KI“, dem neuronalen Netz (Hinweis: Jedoch funktionieren Parameter anders als echte Neuronen)

Notwendige Rechenpower für die Deepseek-Nutzung:

- Auf einem modenen Windows-Rechner oder MacBook M1-M3 lässt sich Deepseek mit ca. bis zu 8b laufen lassen

- Auf einem Hetzner-Server können größere Modell bis zu 70b betrieben werden

- Auf einer Cloud-Plattform wie Azure, AWS oder GCP kann das 671b-Modell mit skalierbarer Cloud-Hardware genutzt werden

Installation: Deepseek R1 mit Ollama auf dem eigenen Rechner einrichten

Für die Installation braucht man einen möglichst aktuellen Win/Mac/Linux-Rechner, ca. 5 GB freien Festplattenspeicher, das kostenlose Tool Ollama und ein passendes Deepseek-Modell. Dies ist mit leicht erweiterten Computer-Kenntnissen auch für Laien in ca. 5 Minuten machbar.

So gehts Schritt für Schritt:

1. Ollama installieren

Ollama ermöglicht es, verschiedene KI-Modelle wie Deepseek, Mistral und weitere einfach zu installieren und zu nutzen. Jedoch hat es keine grafische Oberfläche, so dass man das KI-Modell per Textkommando startet. Ollama ist für macOS, Linux und Windows verfügbar.

Für Windows und MacOS:

Hier gibt es hier einen einfachen Installer, mit dem man Ollama per Klick installieren kann: https://ollama.com

Unter Linux und macOS:

Profi-User können Ollama mit folgendem Befehl installieren:

curl -fsSL https://ollama.ai/install.sh | sh

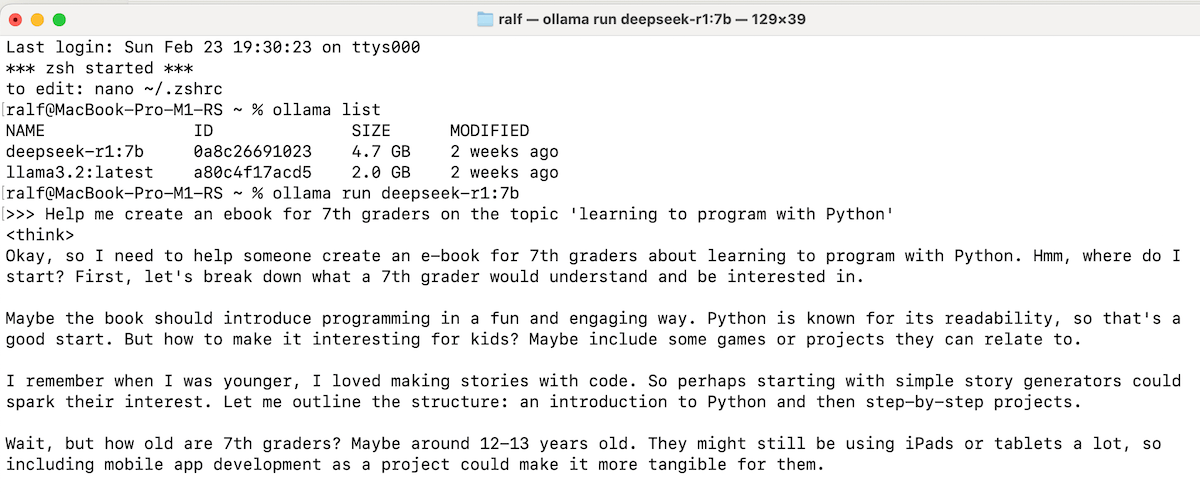

2. Deepseek-Modell in Ollama downloaden

Sobald Ollama installiert ist, kann Deepseek mit einem einzigen Befehl heruntergeladen und gestartet werden. Dafür startet man ein Terminal und gibt folgenden Befehl ein. Das Modell wird dann automatisch aus dem Ollama-Repository geladen und auf dem lokalen Rechner gespeichert. Dies dauert für ein 7b-Modell ca. 10 Minuten, da hier ca. 4-5 GB heruntergeladen werden.

ollama pull deepseek-r1:7b

Auf der Ollama-Website kann man mehr über alle KI-Modelle erfahren. Hier gehts zur Detailseite von Deepseek-R1 auf der Ollama-Website.

3. Deepseek lokal in Ollama ausführen

Nach dem erfolgreichen Download kann das Modell gestartet werden. Nun ist Deepseek bereit und kann über das Terminal für Abfragen genutzt werden.

ollama run deepseek-r1:7b

Beispiel: Ein Informatik-Ebook für 7.-Klässler erstellen mit Deepseek

Als Beispiel geben wir Deepseek R1 (7B) die Aufgabe, uns dabei zu helfen, ein Ebook zu erstellen. Es soll Python-Grundlagen für SchülerInnen in Klasse 7 vermitteln.

Help me create an ebook for 7th graders on the topic 'learning to program with Python'

Ergebnis:

Deepseek R1 ist genau wie OpenAI GPT-o1 ein Reasoning-Model. Das bedeutet, dass es zuerst explizit nachdenkt und einen Plan entwickelt, wie es zum Ziel kommt. Dies verbessert stark die Ergebnisqualität gegenüber anderen Modellen, dauert aber etwas länger.

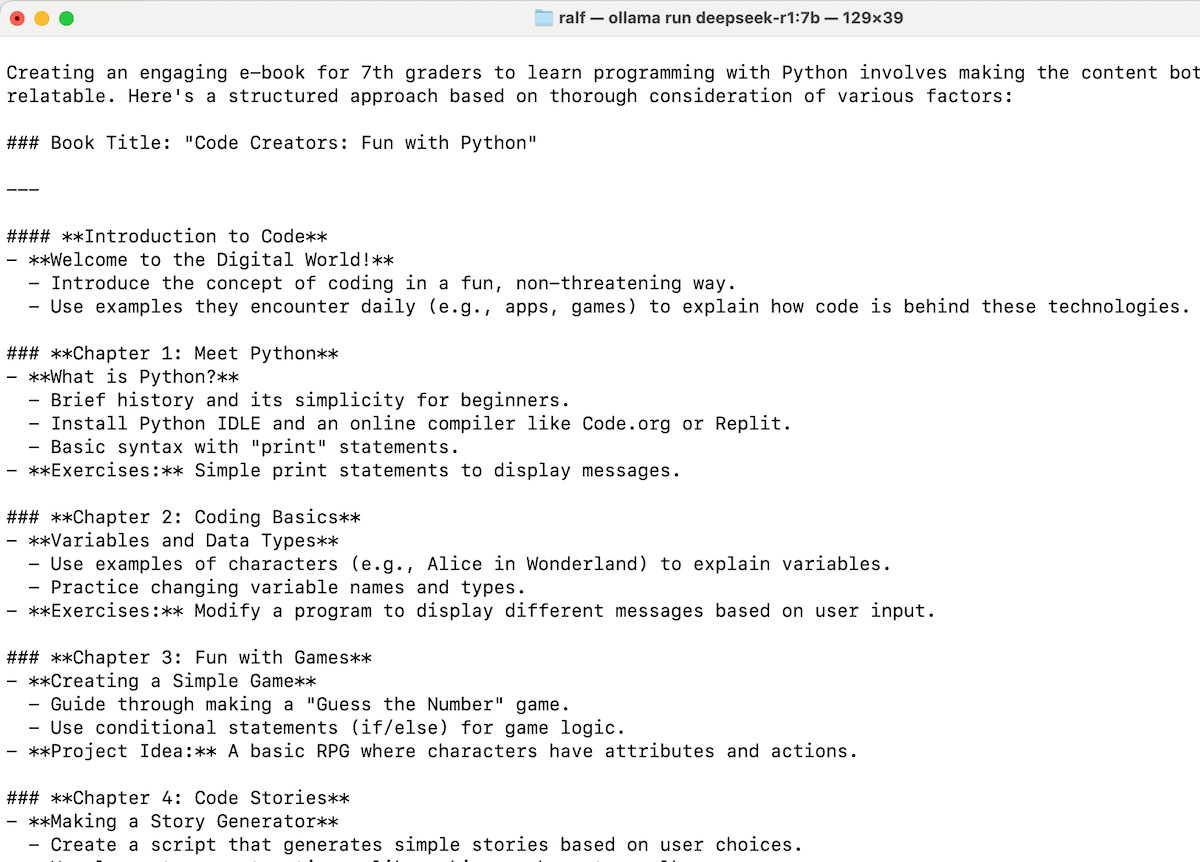

Ergebnis: Inhaltsverzeichnis und Text für das Ebook

Als Ergebnis der Reasoning-Phase hat Deepseek eine sinnvolle und an die Zielgruppe „Klasse 7“ angepasste Struktur erstellt. Das Ergebnis ist selbst für das kleine 7B-Modell bereits gut und kann natürlich noch weiter durch besseres Prompting verfeinert werden.

Die nächsten Schritte können sein, das Ebook von Englisch in die gewünschte Sprache zu übersetzen. Deepseek unterstützt zahlreiche Sprachen in hoher Textqualität, so dass dieser Schritt sehr einfach möglich ist. Für die weitere Feinjustierung kopiert man den Text dann in Word oder ähnliches Tool, ergänzt weitere Absätze, Bilder und Visualisierungen und erstellt dann ein PDF daraus.

Use Cases: Wie kann Deepseek mit Ollama genutzt werden?

1. Recherche und Datenanalyse

Deepseek eignet sich hervorragend zur automatisierten Verarbeitung großer Textmengen. Ein Beispiel:

"Fasse die neuesten Forschungsergebnisse zu KI-basierten Diagnoseverfahren zusammen."

Das Modell gibt eine prägnante Zusammenfassung aus und hilft so bei der effizienten Informationsverarbeitung.

2. Codegenerierung und Debugging

Deepseek kann Entwicklern helfen, Code zu schreiben und Fehler zu analysieren. Beispiel:

"Schreibe eine Python-Funktion, die eine Liste von Zahlen sortiert."

Das Modell liefert eine vollständige Implementierung der gewünschten Funktion.

3. Chatbots & Automatisierungen

Mit Deepseek können interaktive Chatbots erstellt werden, die vollständig offline laufen. Dies ist ideal für Datenschutz-sensitive Anwendungen oder interne Unternehmenslösungen.

Fazit & Ausblick

Deepseek mit Ollama bietet eine leistungsfähige Möglichkeit, das beliebte KI-Modell sicher lokal zu nutzen, ohne dass man seine Daten über Ländergrenzen preisgibt. Die Ergebnisqualität ist selbst beim kleinen 7B-Modell in unserer Beispielaufgabe zur Ebook-Erstellung bereits gut gebrauchtbar. Es eignet sich besonders für Entwickler, Unternehmen und Researcher, die Wert auf Datenschutz und Performance legen.

Teste Deepseek selbst: Installiere Ollama und starte dein erstes KI-Modell direkt auf deinem Rechner!

Offizielle Links:

Ralf Schukay liebt Analytics, Python & alles mit Daten. In seiner Freizeit spielt er Synthesizer (Nord, Novation), joggt und fährt Gravel Bike. Er arbeitet als Teamlead Analytics & Conversion mit einem fitten und netten Team in der Berliner Digitalagentur >MAI mediaworx<