Mistral AI bringt mit dem Update auf Codestral 25.01 spezialisierte Modelle für „Vibe Coding“ direkt in deine Entwicklungsumgebung. Ab sofort verfügbar, ermöglichen diese latenzfreies Autocomplete ohne manuelle Syntax-Eingabe. So kann man komplexe Software-Logik einfach durch natürliche Sprache erstellen.

Key Takeaways

Mistral AI definiert mit seinen spezialisierten Modellen neu, wie Software entsteht, und macht komplexe Entwicklungsschritte durch natürliche Sprache zugänglich. Hier sind die essenziellen Erkenntnisse und konkreten Handlungsschritte, um diese Technologie sofort in deinen Workflow zu integrieren.

- Vibe Coding ersetzt manuelle Syntax durch den Einsatz natürlicher Spracheingaben, sodass du dich auf die Logik und Architektur statt auf das Tippen von Codezeilen konzentrierst.

- Optimierte Codestral-Modelle garantieren durch extrem niedrige Latenzzeiten eine Echtzeit-Autovervollständigung direkt während des Schreibens in deiner IDE.

- Repository-weites Kontextverständnis wird durch massive Fenster von bis zu 128.000 Token ermöglicht, wodurch die KI Abhängigkeiten über Hunderte von Dateien hinweg korrekt analysiert.

- Integriere die Modelle nahtlos in VS Code, indem du Open-Source-Extensions wie Continue.dev mit deinem API-Key für sofortige Produktivitätsgewinne verknüpfst.

- Sichere lokale Deployments erlauben dir, sensible Projekte datenschutzkonform via Ollama oder vLLM zu bearbeiten, ohne Code an externe Cloud-Server zu senden.

Nutze diese neuen Tools jetzt, um deine Coding-Effizienz massiv zu steigern und technische Hürden abzubauen.

Mistral AI und der „Vibe Coding“ Trend

Mistral AI positioniert sich mit neuen, dedizierten Coding-Modellen neu im Entwickler-Markt. Wie TechCrunch berichtet, reagiert das Unternehmen damit auf den Trend des „Vibe Coding“ – einer Entwicklungsmethode, bei der du Software primär durch natürliche Spracheingaben (Prompts) statt durch manuelles Schreiben von Syntax erstellst.

Die neuen Modelle bauen auf der Codestral-Architektur auf, wurden jedoch spezifisch für Fill-in-the-Middle (FIM) Aufgaben und Repository-weites Verständnis optimiert. Ziel ist es nicht nur, Code zu vervollständigen, sondern die Logik ganzer Projekte zu erfassen. Mistral tritt damit in direkte Konkurrenz zu Modellen, die im Hintergrund von Editoren wie Cursor oder Tools wie Replit laufen.

Technische Fähigkeiten

Die Modelle zielen auf eine Reduktion der Latenz bei gleichzeitiger Erhöhung der Präzision. Sie unterstützen über 80 Programmiersprachen, wobei der Fokus auf Python, Java, C++ und TypeScript liegt.

| Feature | Spezifikation | Nutzen |

| Modell-Typ | Codestral (optimiert) | Spezialisierung auf Code-Generierung und Debugging |

| Kontext-Fenster | 32k – 128k Token | Erlaubt das Einlesen ganzer Dateien oder kleiner Repositories |

| Latenz | Low-Latency Mode | Echtzeit-Vorschläge während des Tippens (Autocomplete) |

Die Anwendung: Integration in deinen Workflow

Du kannst die neuen Modelle entweder direkt über die API in deine eigenen Applikationen einbinden oder über Plugins in deiner bestehenden IDE nutzen.

So nutzt du die Modelle in VS Code (via Continue):

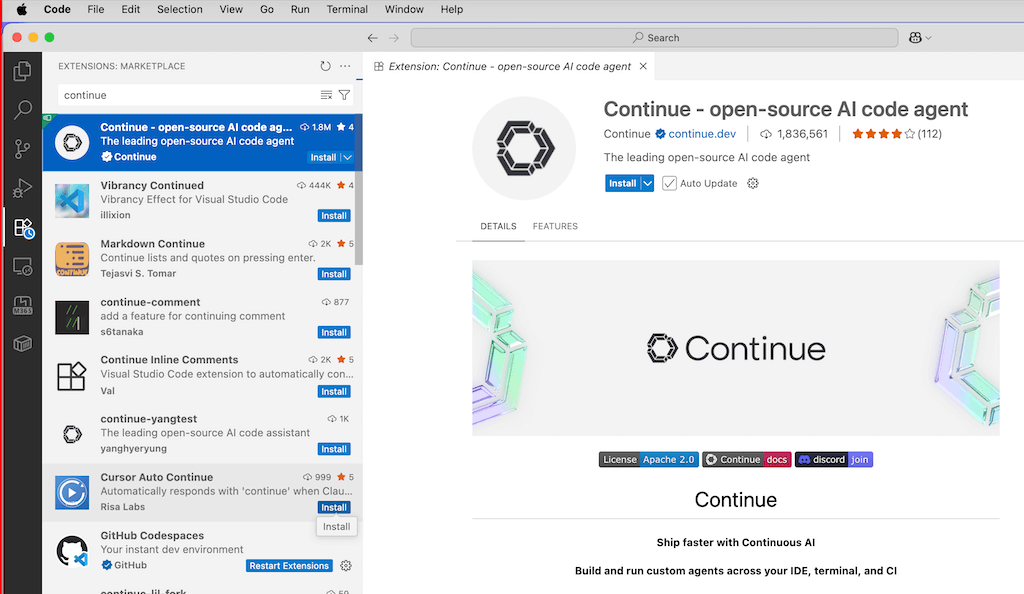

- Plugin installieren: Suche im VS Code Marketplace nach der Extension „Continue“ und installiere sie.

- API Key generieren: Gehe auf die Mistral-Plattform (La Plateforme) und erstelle einen neuen API-Key.

- Konfiguration: Öffne die

config.jsonvon Continue. - Provider setzen: Füge Mistral als Provider hinzu und setze

modelaufcodestral-latest(oder die spezifische Version). - Anwendung: Drücke

CMD+I(oderSTRG+I), um den Inline-Edit-Modus zu starten, und beschreibe deine gewünschte Änderung in natürlicher Sprache. Das Modell führt die Anpassung direkt im Code durch.

Alternativ kannst du für schnelle Tests ohne IDE-Setup „Le Chat“ von Mistral nutzen, um Snippets generieren zu lassen oder Logikfehler durch Pasten von Codeblöcken zu debuggen.

Mistral AI: Fokus auf Vibe Coding und neue Modelle

Mistral AI hat sein Portfolio um dedizierte Modelle für Softwareentwicklung erweitert. Mit diesem Schritt reagiert das Unternehmen auf den Trend zum „Vibe Coding“, bei dem Entwickler primär über natürliche Sprache mit Codebasen interagieren, statt jede Zeile Syntax manuell zu schreiben. Laut einem Bericht von TechCrunch positionieren sich diese Modelle als direkte Konkurrenz zu proprietären Lösungen wie Claude Sonnet 3.5 oder O1, jedoch mit dem Fokus auf Effizienz und offene Verfügbarkeit.

Die neuen Modelle, oft Weiterentwicklungen der Codestral-Linie, bieten spezialisierte Fähigkeiten für „Fill-in-the-Middle“ (FIM) Aufgaben und unterstützen über 80 Programmiersprachen, darunter Python, Java, C++ und TypeScript. Ein Kernfeature ist das erweiterte Kontextfenster, das es erlaubt, gesamte Repositories in den Prompt-Kontext zu laden, um Abhängigkeiten besser zu verstehen.

Technische Spezifikationen

Die Modelle sind auf niedrige Latenz optimiert, was sie für Autocomplete-Aufgaben in IDEs geeignet macht. Sie unterscheiden sich von den generalistischen Mistral-Modellen (wie Mistral Large) durch ein spezifisches Fine-Tuning auf Code-Repositories und technische Dokumentationen.

| Feature | Spezifikation |

| Fokus | Code-Generierung, Debugging, Refactoring |

| Kontext-Fenster | 32k bis 128k Token (modellabhängig) |

| Primäre Sprachen | Python, JS/TS, Rust, Go, C++ |

| Bereitstellung | La Plateforme API, Le Chat, Hugging Face |

Nutzung in der Entwicklungsumgebung

Um die neuen Modelle effektiv in deinen Workflow zu integrieren, hast du zwei Hauptwege: die direkte API-Anbindung oder die Nutzung über KI-Plugins in deiner IDE.

So nutzt du die Modelle in VS Code:

- Installation: Installiere ein kompatibles Plugin wie Continue.dev oder die offizielle Mistral-Erweiterung (falls verfügbar).

- API Key generieren: Gehe auf die Mistral „La Plateforme“ Konsole, erstelle einen neuen API-Schlüssel und kopiere diesen.

- Konfiguration: Öffne die

config.jsondeines Plugins. Füge unter „models“ den entsprechenden Modell-Namen ein (z.B.codestral-latest). - Aktivierung: Wähle im Chat-Fenster oder in der Autocomplete-Statusleiste das Mistral-Modell als aktiven Provider aus.

Für Nutzer ohne IDE-Integration steht die Funktionalität auch über „Le Chat“ zur Verfügung. Hier kannst du Code-Snippets direkt einfügen oder ZIP-Dateien ganzer Projekte hochladen, um Refactoring-Vorschläge zu erhalten.

Mistral AI veröffentlicht optimierte Coding-Modelle

Mistral AI expandiert weiter in den Bereich der Code-Generierung. Wie TechCrunch berichtet, zielen die neuen Modelle darauf ab, den sogenannten „Vibe Coding“-Trend zu bedienen – ein Workflow, bei dem Entwickler primär das gewünschte Verhalten beschreiben und die syntaktische Umsetzung der KI überlassen.

Der Fokus liegt auf einer verbesserten „Fill-in-the-Middle“ (FIM) Fähigkeit und reduzierter Latenz für Echtzeit-Vorschläge. Die Modelle sind darauf trainiert, nicht nur Boilerplate-Code zu erzeugen, sondern komplexe Logik über mehrere Dateien hinweg (Repo-Level Awareness) zu verstehen. Dies positioniert Mistral als direkte Alternative zu Anthropic’s Claude Sonnet oder OpenAI’s Modellen innerhalb von IDE-Erweiterungen wie Cursor oder Windsurf.

Technische Eckdaten

Die Kernfunktionen im Überblick:

| Feature | Beschreibung |

|---|---|

| Spezialisierung | Optimiert für Python, JavaScript, Java, C++ und Shell-Scripting. |

| Kontext-Fenster | 32k bis 128k Token (abhängig von der spezifischen Version). |

| Deployment | Verfügbar via API (La Plateforme) oder für Self-Hosting. |

So integrierst du die neuen Modelle

Um die Coding-Modelle in deine tägliche Entwicklungsumgebung (IDE) einzubinden, benötigst du keine eigene Infrastruktur. Die effizienteste Methode ist die Nutzung von Open-Source-Extensions, die API-Endpunkte unterstützen.

Die Anwendung:

- API Key generieren:

- Logge dich in die Mistral „La Plateforme“ Konsole ein.

- Erstelle unter „API Keys“ einen neuen Schlüssel und limitiere bei Bedarf das Budget.

- IDE Extension installieren:

- Nutze in VS Code die Extension Continue (Open Source) oder Twinny.

- Konfiguration:

- Öffne die Einstellungen der Extension (

config.jsonbei Continue). - Trage unter

modelsden ProviderMistralein. - Setze als Modellnamen

codestral-latest(oder die spezifische Version aus dem Dashboard). - Füge deinen API Key ein.

- Öffne die Einstellungen der Extension (

- Nutzung:

- Markiere Code und drücke

Cmd+L(oder den Shortcut der Extension), um Refactoring-Vorschläge zu erhalten, oder nutze die Autocomplete-Funktion während des Tippens.

- Markiere Code und drücke

Mistral AI pusht Code-Modelle für „Vibe Coding“

Mistral AI hat neue Modelle veröffentlicht, die spezifisch auf Code-Generierung und Autovervollständigung ausgelegt sind. Laut einem Bericht von TechCrunch adressiert das Update den wachsenden Trend des „Vibe Coding“ – eine Entwicklungsmethode, bei der natürliche Sprache die Syntax-Kontrolle ersetzt und der KI-Agent die Implementierung übernimmt.

Die neuen Modelle, eine Weiterentwicklung der Codestral-Reihe, bieten optimierte Latenzzeiten für Autocomplete-Aufgaben (Fill-in-the-Middle) und unterstützen über 80 Programmiersprachen, darunter Python, Java, C++ und JavaScript. Ein Schlüsselfaktor ist die Beibehaltung offener Gewichtungen (Open Weights) für bestimmte Modellgrößen, was lokalen Betrieb (On-Premise) ohne Datenabfluss ermöglicht.

Technische Spezifikationen

Das Update konzentriert sich auf Performance in IDEs. Die Modelle verarbeiten Kontextfenster von bis zu 32k Token effizienter, um Repository-weite Abhängigkeiten zu verstehen.

| Feature | Spezifikation | Nutzen |

| FIM (Fill-In-The-Middle) | Native Unterstützung | Präzise Code-Ergänzung mitten in Funktionen. |

| Kontext | 32k – 128k Token | Verständnis über mehrere Dateien hinweg. |

| Deployment | API & Local (Ollama/vLLM) | Datenschutz und Offline-Verfügbarkeit. |

Die Anwendung: Integration in deine IDE

Du kannst die neuen Modelle entweder über die Mistral API nutzen oder lokal hosten, um Latenz und Kosten zu kontrollieren.

So richtest du es in VS Code (via Continue oder Cursor) ein:

- API-Key generieren: Gehe auf die Mistral-Plattform (

console.mistral.ai) und erstelle einen neuen API-Schlüssel. - Extension konfigurieren: Öffne die Einstellungen deiner KI-Extension (z.B. Continue).

- Provider wählen: Wähle „Mistral“ als Provider aus und füge den API-Key ein.

- Modell setzen: Wähle das neueste Modell (z.B.

codestral-latest) als Standard für Autocomplete und Chat.

Für lokale Nutzung (Datenschutz-Fokus):

- Installiere Ollama.

- Führe im Terminal

ollama pull codestralaus. - Setze in deiner IDE den API-Endpunkt auf

http://localhost:11434.

Dies ermöglicht dir eine Code-Assistenz, die keine Telemetriedaten an Cloud-Provider sendet – essenziell für Projekte mit strengen Compliance-Vorgaben.

Mistral veröffentlicht Codestral 25.01

Mistral AI aktualisiert sein spezialisiertes Coding-Modell und veröffentlicht Codestral 25.01. Das Update reagiert auf den Trend des „Vibe Coding“, bei dem Entwickler primär über natürliche Sprache steuern, während die KI die Implementierung übernimmt. Wie TechCrunch berichtet, liegt der Fokus auf niedriger Latenz und lokalem Deployment, um Abhängigkeiten von reinen Cloud-Lösungen wie GitHub Copilot zu reduzieren.

Das Modell positioniert sich als effiziente Alternative zu massiven Generalisten-Modellen. Es wurde spezifisch für „Fill-in-the-Middle“ (FIM) Aufgaben und Code-Vervollständigung trainiert. Im Vergleich zur Vorgängerversion zeigt Codestral 25.01 verbesserte Benchmarks in Python, SQL und TypeScript sowie eine höhere Token-Effizienz.

Technische Spezifikationen

Das Modell nutzt eine Architektur, die schnelle Inferenzzeiten ermöglicht – ein kritischer Faktor für Autocomplete-Features in IDEs. Es unterstützt Kontext-Fenster, die groß genug sind, um relevante Projektdateien zu erfassen, ohne die Antwortzeit signifikant zu verlangsamen.

| Feature | Detail |

| Modell-ID | codestral-2501 |

| Hauptfokus | Code Completion, FIM, Refactoring |

| Sprachabdeckung | 80+ (Optimiert für Python, JS/TS, Java) |

| Lizenzmodell | Mistral Research License (lokal) / Commercial API |

Integration in den Workflow

Codestral 25.01 ist nicht nur über die Chat-Oberfläche „Le Chat“ verfügbar, sondern primär für die Integration in Entwicklungsumgebungen (IDEs) gedacht. Du kannst es als Backend für Extensions nutzen, die lokale LLMs oder externe APIs unterstützen.

So nutzt du es in VS Code (via Continue):

- API Key erstellen: Registriere dich auf der Mistral „La Plateforme“ und generiere einen API-Key.

- Extension installieren: Installiere „Continue“ aus dem VS Code Marketplace.

- Konfiguration anpassen: Öffne die

config.jsonder Extension (unten links im Continue-Fenster auf das Zahnrad klicken). - Modell hinzufügen: Füge unter

modelsfolgenden Eintrag hinzu:provider: „mistral“model: „codestral-2501“apiKey: „[Dein Key]“

- Aktivierung: Wähle Codestral im Dropdown-Menü der Extension aus. Nutze Highlight +

CMD+I(Edit) oderCMD+L(Chat), um Code direkt im Editor generieren oder erklären zu lassen.

Fazit

Mistral AI liefert mit den neuen Coding-Modellen weit mehr als nur ein technisches Update. Es ist der Beweis, dass High-End-Code-Assistenz nicht zwingend an teure Closed-Source-Abos gebunden sein muss.

Du bekommst ein Werkzeug an die Hand, das Datenschutz mit extremer Geschwindigkeit vereint und „Vibe Coding“ vom Buzzword zur realen, effizienten Arbeitsweise macht. Der Fokus verschiebt sich für dich vom reinen Syntax-Schreiben hin zum Orchestrieren von Logik.

Das Wichtigste für deinen Workflow:

- Unabhängigkeit: Mit offenen Gewichtungen und lokalen Optionen (via Ollama) behältst du die volle Souveränität über deinen Code.

- Effizienz: Die optimierte Latenz und FIM-Fähigkeiten machen das Modell zur echten Alternative für Echtzeit-Autonomie in der IDE.

- Tieferes Verständnis: Dank großer Kontext-Fenster erfasst die KI nicht nur einzelne Dateien, sondern die Struktur ganzer Projekte.

Deine nächsten Schritte:

- Hole dir einen API-Key auf „La Plateforme“ oder richte Codestral lokal via Ollama ein.

- Installiere die Continue Extension in VS Code, um das Modell direkt in deinen Editor zu holen.

- Nimm dir ein bestehendes Skript vor und lass es testweise per Prompt refactorn, um ein Gefühl für die Präzision zu bekommen.

Wir bewegen uns in eine Ära, in der Kreativität wichtiger wird als das Auswendiglernen von Befehlen. Mistral gibt dir die Freiheit, diesen Wandel kosteneffizient und selbstbestimmt zu gestalten. Probier es aus – der Code wartet nicht.

Florian Schröder ist Experte im Online-Marketing mit Schwerpunkt PPC (Pay-Per-Click) Kampagnen. Die revolutionären Möglichkeiten der KI erkennt er nicht nur, sondern hat sie bereits fest in seine tägliche Arbeit integriert, um innovative und effektive Marketingstrategien zu entwickeln.

Er ist überzeugt davon, dass die Zukunft des Marketings untrennbar mit der Weiterentwicklung und Nutzung von künstlicher Intelligenz verbunden ist und setzt sich dafür ein, stets am Puls dieser technologischen Entwicklungen zu bleiben.